⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-22 更新

RL from Physical Feedback: Aligning Large Motion Models with Humanoid Control

Authors:Junpeng Yue, Zepeng Wang, Yuxuan Wang, Weishuai Zeng, Jiangxing Wang, Xinrun Xu, Yu Zhang, Sipeng Zheng, Ziluo Ding, Zongqing Lu

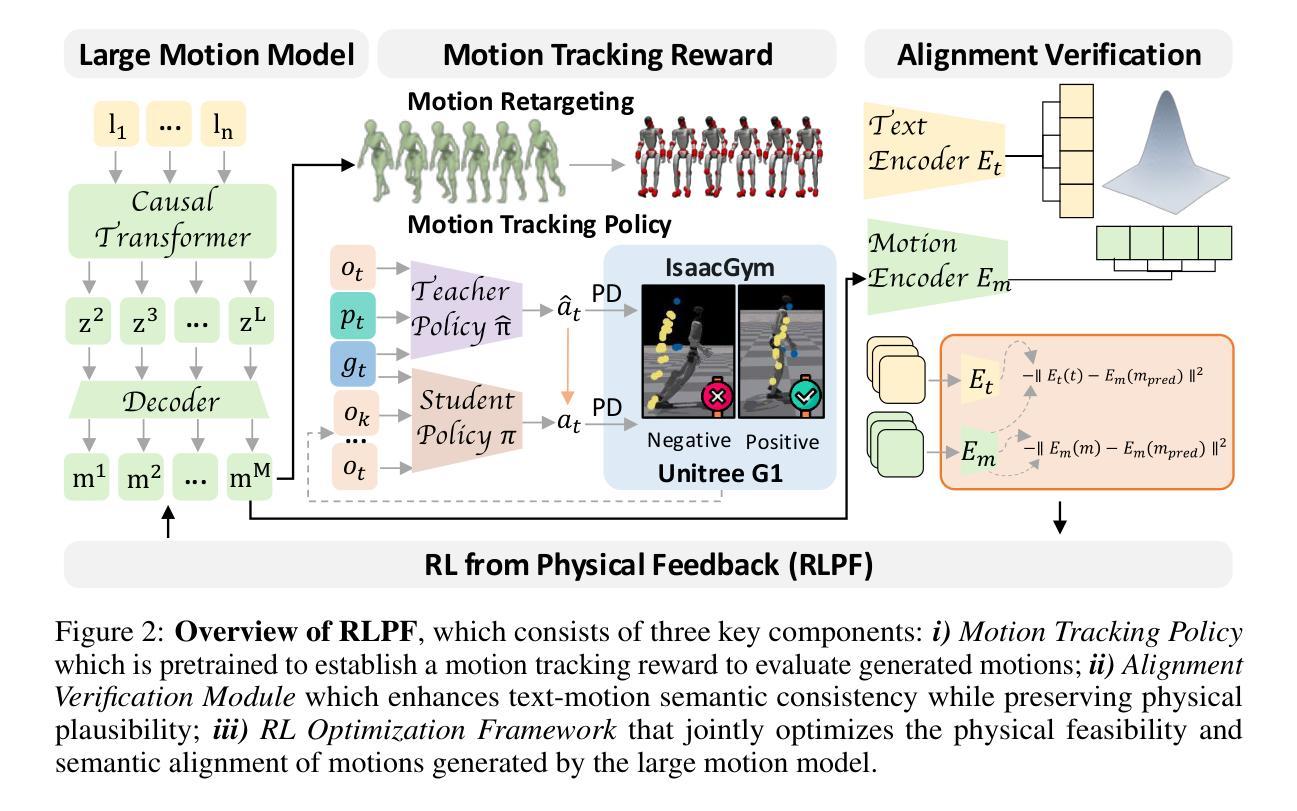

This paper focuses on a critical challenge in robotics: translating text-driven human motions into executable actions for humanoid robots, enabling efficient and cost-effective learning of new behaviors. While existing text-to-motion generation methods achieve semantic alignment between language and motion, they often produce kinematically or physically infeasible motions unsuitable for real-world deployment. To bridge this sim-to-real gap, we propose Reinforcement Learning from Physical Feedback (RLPF), a novel framework that integrates physics-aware motion evaluation with text-conditioned motion generation. RLPF employs a motion tracking policy to assess feasibility in a physics simulator, generating rewards for fine-tuning the motion generator. Furthermore, RLPF introduces an alignment verification module to preserve semantic fidelity to text instructions. This joint optimization ensures both physical plausibility and instruction alignment. Extensive experiments show that RLPF greatly outperforms baseline methods in generating physically feasible motions while maintaining semantic correspondence with text instruction, enabling successful deployment on real humanoid robots.

本文重点关注机器人技术中的一项关键挑战:将文本驱动的人类运动转化为人形机器人的可执行动作,从而实现新行为的高效且经济的学习。尽管现有的文本到运动生成方法实现了语言与运动之间的语义对齐,但它们通常会产生运动学上或物理上不可行的运动,不适合在真实世界中进行部署。为了弥补仿真到现实的差距,我们提出了强化学习物理反馈(RLPF)这一新型框架,它将物理感知运动评估与文本驱动的运动生成相结合。RLPF采用运动跟踪策略在物理模拟器中评估可行性,为微调运动生成器生成奖励。此外,RLPF还引入了对齐验证模块,以保持对文本指令的语义保真。这种联合优化确保了物理可行性和指令对齐。大量实验表明,RLPF在生成物理可行运动方面大大优于基准方法,同时保持与文本指令的语义对应,成功部署在真实的人形机器人上。

论文及项目相关链接

Summary

本文探讨机器人领域的一个关键挑战:将文本驱动的人类运动转化为人形机器人的可执行动作。文章指出,尽管现有的文本到运动生成方法实现了语言与运动的语义对齐,但它们常常产生在动力学或物理上不可行的运动,无法在实际环境中部署。为解决仿真到现实的差距,文章提出了一种名为强化学习物理反馈(RLPF)的新框架,该框架将物理感知运动评估与文本驱动的运动生成相结合。RLPF通过运动跟踪策略在物理模拟器中评估可行性,并为微调运动生成器生成奖励。此外,RLPF引入了对齐验证模块,以保持对文本指令的语义保真度。这种联合优化确保了物理可行性和指令对齐。实验表明,RLPF在生成物理可行运动方面大大优于基准方法,同时保持与文本指令的语义对应,成功部署在真实的人形机器人上。

Key Takeaways

- 本文主要挑战在于将文本驱动的人类运动转化为人形机器人的可执行动作,实现新行为的高效且经济的学习。

- 现有方法虽然可以实现语言与运动的语义对齐,但产生的运动在物理上常常不可行,无法直接应用于实际环境。

- 为解决仿真与现实的差距,提出了强化学习物理反馈(RLPF)的新框架。

- RLPF通过运动跟踪策略在物理模拟器中评估可行性,并生成奖励以微调运动生成器。

- RLPF引入了对齐验证模块来保持对文本指令的语义保真度。

- 联合优化确保了物理可行性和指令对齐。

点此查看论文截图

Motion-R1: Chain-of-Thought Reasoning and Reinforcement Learning for Human Motion Generation

Authors:Runqi Ouyang, Haoyun Li, Zhenyuan Zhang, Xiaofeng Wang, Zheng Zhu, Guan Huang, Xingang Wang

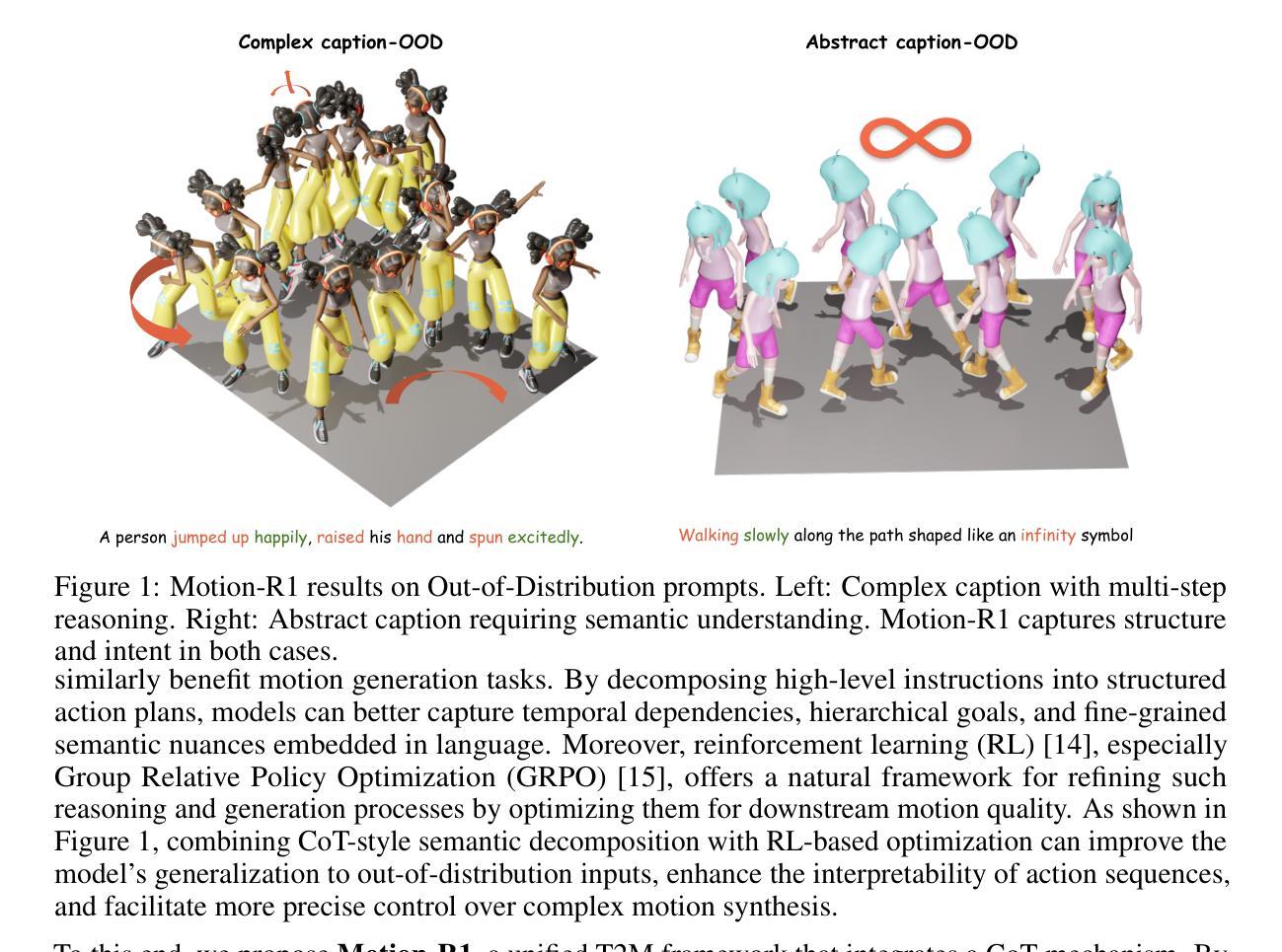

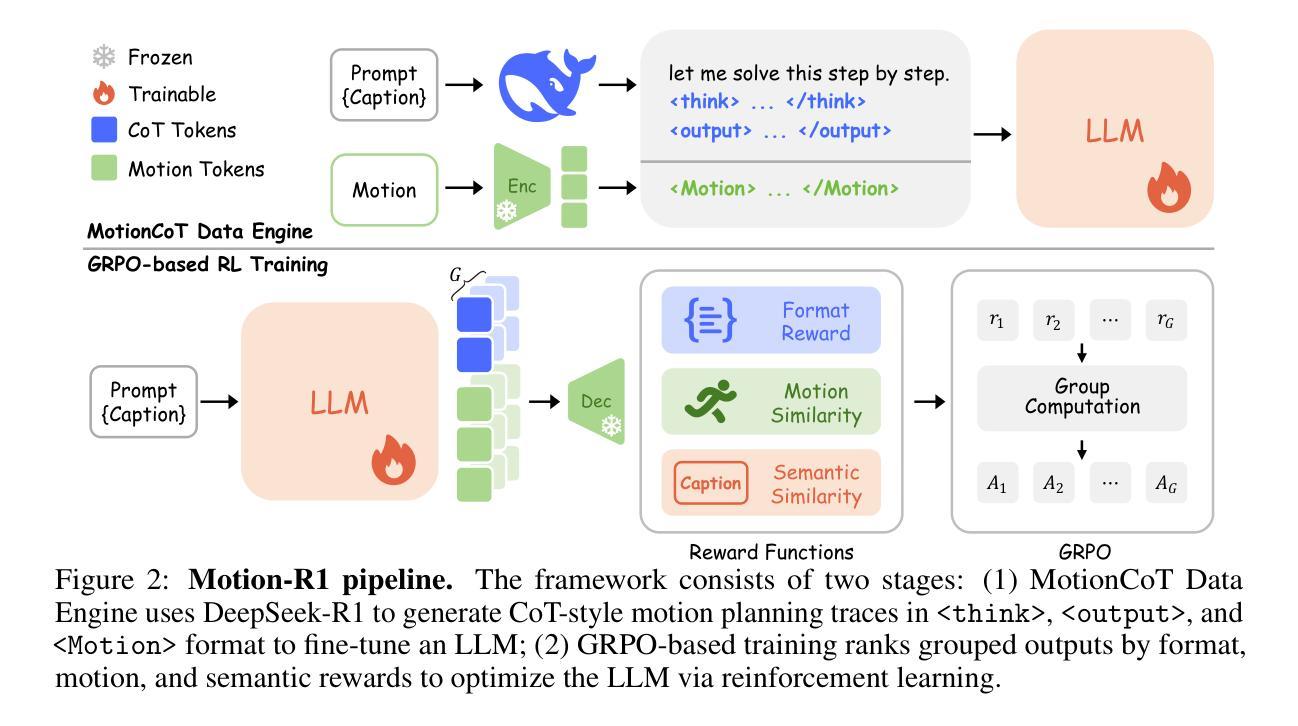

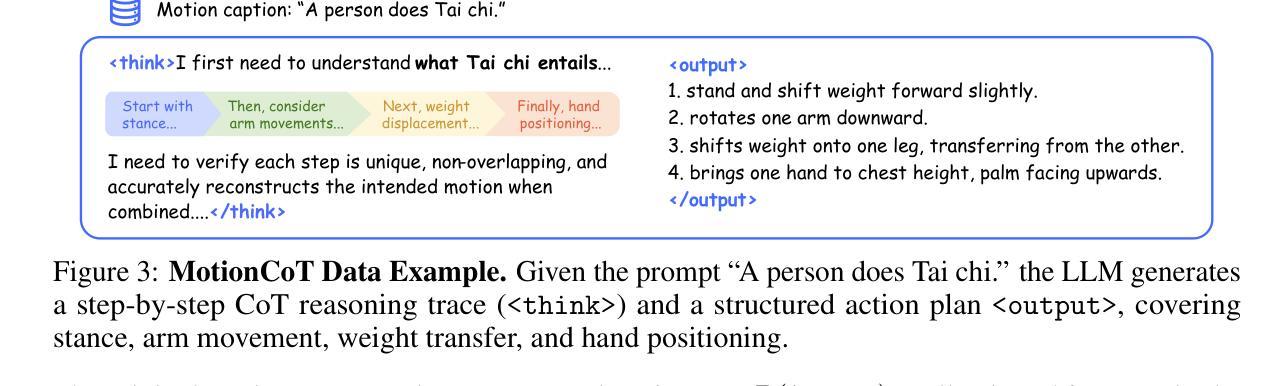

Recent advances in large language models, especially in natural language understanding and reasoning, have opened new possibilities for text-to-motion generation. Although existing approaches have made notable progress in semantic alignment and motion synthesis, they often rely on end-to-end mapping strategies that fail to capture deep linguistic structures and logical reasoning. Consequently, generated motions tend to lack controllability, consistency, and diversity. To address these limitations, we propose Motion-R1, a unified motion-language modeling framework that integrates a Chain-of-Thought mechanism. By explicitly decomposing complex textual instructions into logically structured action paths, Motion-R1 provides high-level semantic guidance for motion generation, significantly enhancing the model’s ability to interpret and execute multi-step, long-horizon, and compositionally rich commands. To train our model, we adopt Group Relative Policy Optimization, a reinforcement learning algorithm designed for large models, which leverages motion quality feedback to optimize reasoning chains and motion synthesis jointly. Extensive experiments across multiple benchmark datasets demonstrate that Motion-R1 achieves competitive or superior performance compared to state-of-the-art methods, particularly in scenarios requiring nuanced semantic understanding and long-term temporal coherence. The code, model and data will be publicly available.

最近的大型语言模型进展,特别是在自然语言理解和推理方面,为文本到动作生成提供了新的可能性。尽管现有方法已经在语义对齐和动作合成方面取得了显著的进步,但它们通常依赖于端到端的映射策略,无法捕捉深层语言结构和逻辑推理。因此,生成的动作往往缺乏可控性、一致性和多样性。为了解决这些局限性,我们提出了Motion-R1,这是一个统一的动作语言建模框架,它集成了思维链机制。Motion-R1通过显式地将复杂的文本指令分解为逻辑结构化的行动路径,为动作生成提供高级语义指导,从而显著提高模型解释和执行多步骤、长期视野和组合丰富指令的能力。为了训练我们的模型,我们采用了针对大型模型的强化学习算法——群组相对策略优化,该算法利用动作质量反馈来联合优化推理链和动作合成。在多个基准数据集上的广泛实验表明,Motion-R1在需要微妙语义理解和长期时间一致性的场景中,实现了与最新技术方法相当的或更优的性能。代码、模型和数据将公开可用。

论文及项目相关链接

Summary

本文介绍了基于大型语言模型的文本到动作生成技术的最新进展。针对现有方法的不足,如缺乏深度语言结构和逻辑推理的捕捉,本文提出了Motion-R1框架。该框架结合了Chain-of-Thought机制,能够将复杂的文本指令分解为逻辑结构化的行动路径,为动作生成提供高级语义指导。通过采用针对大型模型的强化学习算法Group Relative Policy Optimization,该模型能够在多个基准数据集上实现出色的性能,特别是在需要微妙语义理解和长期时间连贯性的场景中。

Key Takeaways

- 大型语言模型在文本到动作生成方面的最新进展及挑战。

- 现有方法依赖端到端的映射策略,难以捕捉深度语言结构和逻辑推理。

- Motion-R1框架结合Chain-of-Thought机制,能分解复杂文本指令为逻辑结构化的行动路径。

- Motion-R1框架提高了模型执行多步骤、长期视野和组合丰富指令的能力。

- 采用Group Relative Policy Optimization强化学习算法,联合优化推理链和动作合成。

- Motion-R1在多个基准数据集上实现了与最新技术相当或更优越的性能。

- 模型、代码和数据将公开发布。

点此查看论文截图