⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-26 更新

A Global-Local Cross-Attention Network for Ultra-high Resolution Remote Sensing Image Semantic Segmentation

Authors:Chen Yi, Shan LianLei

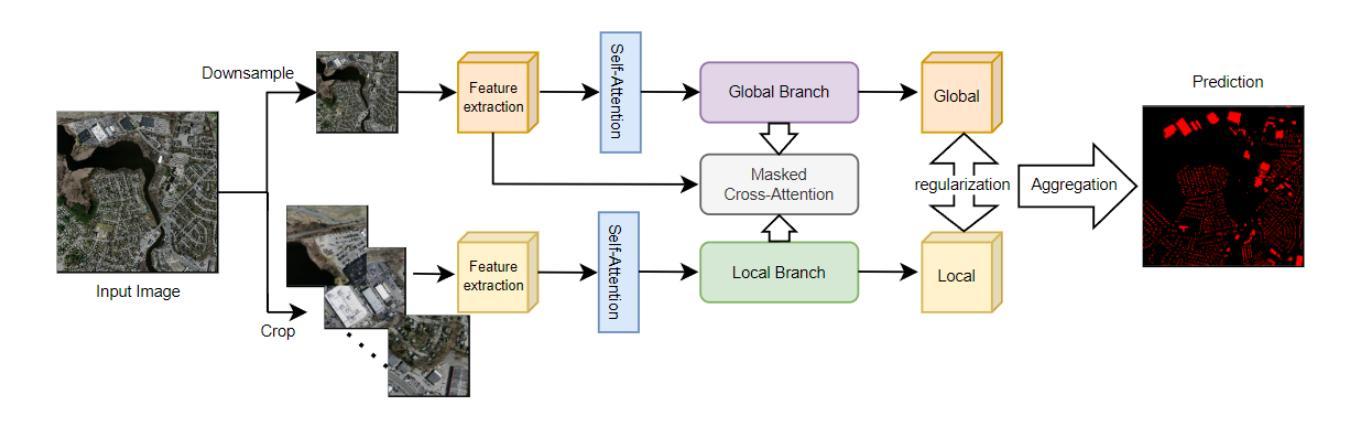

With the rapid development of ultra-high resolution (UHR) remote sensing technology, the demand for accurate and efficient semantic segmentation has increased significantly. However, existing methods face challenges in computational efficiency and multi-scale feature fusion. To address these issues, we propose GLCANet (Global-Local Cross-Attention Network), a lightweight segmentation framework designed for UHR remote sensing imagery.GLCANet employs a dual-stream architecture to efficiently fuse global semantics and local details while minimizing GPU usage. A self-attention mechanism enhances long-range dependencies, refines global features, and preserves local details for better semantic consistency. A masked cross-attention mechanism also adaptively fuses global-local features, selectively enhancing fine-grained details while exploiting global context to improve segmentation accuracy. Experimental results show that GLCANet outperforms state-of-the-art methods regarding accuracy and computational efficiency. The model effectively processes large, high-resolution images with a small memory footprint, providing a promising solution for real-world remote sensing applications.

随着超高分辨率(UHR)遥感技术的快速发展,对精确高效的语义分割的需求显著增加。然而,现有方法在计算效率和多尺度特征融合方面面临挑战。为了解决这些问题,我们提出了GLCANet(全局-局部交叉注意力网络),这是一个为超高分辨率遥感影像设计的轻量化分割框架。GLCANet采用双流架构,旨在高效融合全局语义和局部细节,同时最小化GPU的使用。自注意力机制增强了长程依赖性,细化了全局特征,并保留了局部细节,以实现更好的语义一致性。掩模交叉注意力机制也自适应地融合全局-局部特征,有选择地突出细节,同时利用全局上下文信息来提高分割精度。实验结果表明,GLCANet在精度和计算效率方面优于最新方法。该模型能够在较小的内存占用下处理大型高分辨率图像,为现实世界遥感应用提供了有前景的解决方案。

论文及项目相关链接

摘要

随着超高分辨率(UHR)遥感技术的快速发展,对准确高效的语义分割需求显著增加。然而,现有方法在计算效率和多尺度特征融合方面面临挑战。为解决这些问题,我们提出了GLCANet(全局-局部交叉注意力网络),这是一个为超高分辨率遥感图像设计的轻量级分割框架。GLCANet采用双流架构,能够高效融合全局语义和局部细节,同时最小化GPU使用。自注意力机制增强了远程依赖性,细化了全局特征,并保留了局部细节,以实现更好的语义一致性。掩码交叉注意力机制还自适应地融合全局局部特征,有选择地突出细节,并利用全局上下文提高分割精度。实验结果表明,GLCANet在精度和计算效率方面优于最新方法。该模型能够在内存占用较小的情况下处理大型高分辨率图像,为现实世界遥感应用提供了有前景的解决方案。

要点

- 超高分辨率遥感技术的快速发展推动了准确高效语义分割的需求。

- 现有方法在计算效率和多尺度特征融合方面存在挑战。

- GLCANet是一个轻量级的分割框架,专为超高分辨率遥感图像设计。

- 采用双流架构,高效融合全局语义和局部细节,最小化GPU使用。

- 自注意力机制增强远程依赖性,细化全局特征并保留局部细节。

- 掩码交叉注意力机制自适应融合全局和局部特征,提高分割精度。

- GLCANet在精度和计算效率方面优于现有方法。

点此查看论文截图