⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-26 更新

Tailored Conversations beyond LLMs: A RL-Based Dialogue Manager

Authors:Lucie Galland, Catherine Pelachaud, Florian Pecune

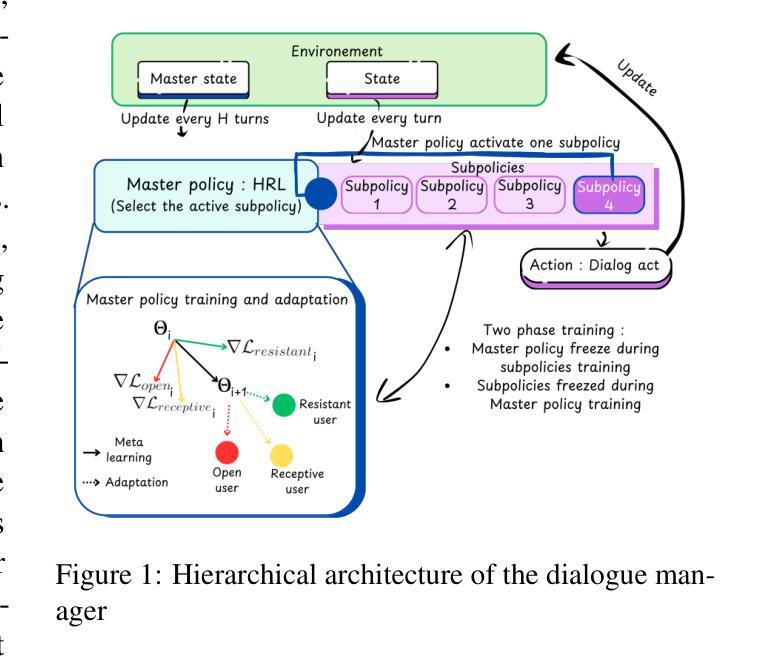

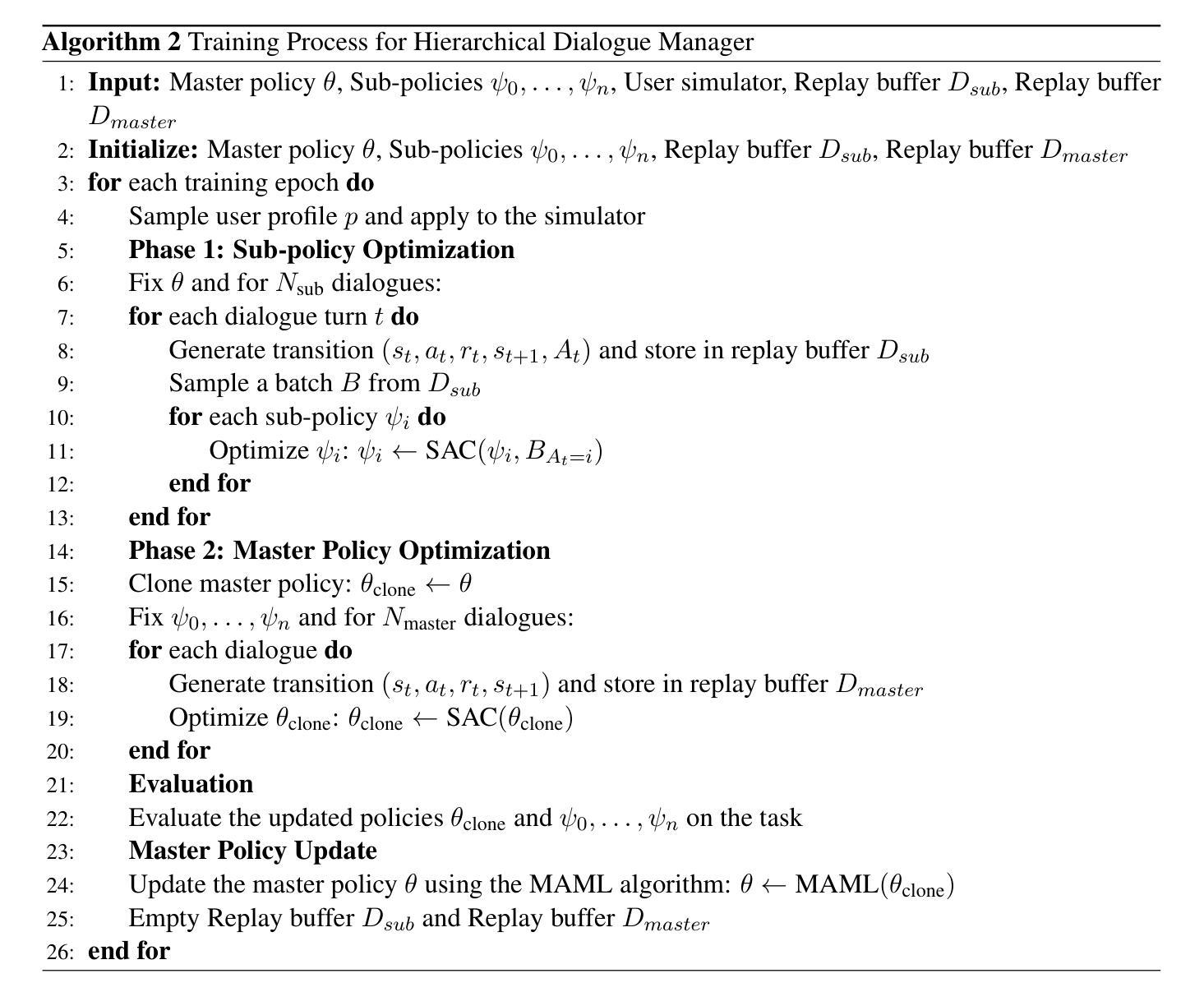

In this work, we propose a novel framework that integrates large language models (LLMs) with an RL-based dialogue manager for open-ended dialogue with a specific goal. By leveraging hierarchical reinforcement learning to model the structured phases of dialogue and employ meta-learning to enhance adaptability across diverse user profiles, our approach enhances adaptability and efficiency, enabling the system to learn from limited data, transition fluidly between dialogue phases, and personalize responses to heterogeneous patient needs. We apply our framework to Motivational Interviews, aiming to foster behavior change, and demonstrate that the proposed dialogue manager outperforms a state-of-the-art LLM baseline in terms of reward, showing a potential benefit of conditioning LLMs to create open-ended dialogue systems with specific goals.

在这项工作中,我们提出了一种新型框架,该框架将大型语言模型(LLM)与基于强化学习的对话管理器相结合,用于实现具有特定目标的开放对话。我们借助分层强化学习来模拟对话的结构化阶段,并利用元学习来提高对不同用户配置的适应性。我们的方法提高了适应性和效率,使系统能够在有限的数据中学习,在对话阶段之间流畅过渡,并对不同患者的需求做出个性化响应。我们将框架应用于动机面试,旨在促进行为改变,并证明所提出的对话管理器在奖励方面优于最新的LLM基准测试,显示出将LLM设置于创建具有特定目标的开放对话系统的潜在优势。

论文及项目相关链接

Summary

本工作提出一种新型框架,结合大型语言模型(LLMs)和基于强化学习(RL)的对话管理器,用于实现具有特定目标的开放对话。通过利用分层强化学习对对话的结构阶段进行建模,并借助元学习提高对不同用户特征的适应性,该方法增强了系统的适应性和效率,使系统能够从有限的数据中学习,在对话阶段之间流畅过渡,并对不同患者的需求做出个性化响应。本研究将框架应用于动机面试,旨在促进行为改变,并证明所提出的对话管理器在奖励方面优于最先进的大型语言模型基线,显示出将大型语言模型用于创建具有特定目标的开放对话系统的潜在优势。

Key Takeaways

- 提出了一种新型框架,结合了大型语言模型和基于强化学习的对话管理器。

- 利用分层强化学习对对话的结构阶段进行建模。

- 通过元学习提高对不同用户特征的适应性。

- 系统能够从有限的数据中学习,并在对话阶段之间流畅过渡。

- 能够个性化响应不同患者的需求。

- 将框架应用于动机面试,旨在促进行为改变。

点此查看论文截图

Commonsense Generation and Evaluation for Dialogue Systems using Large Language Models

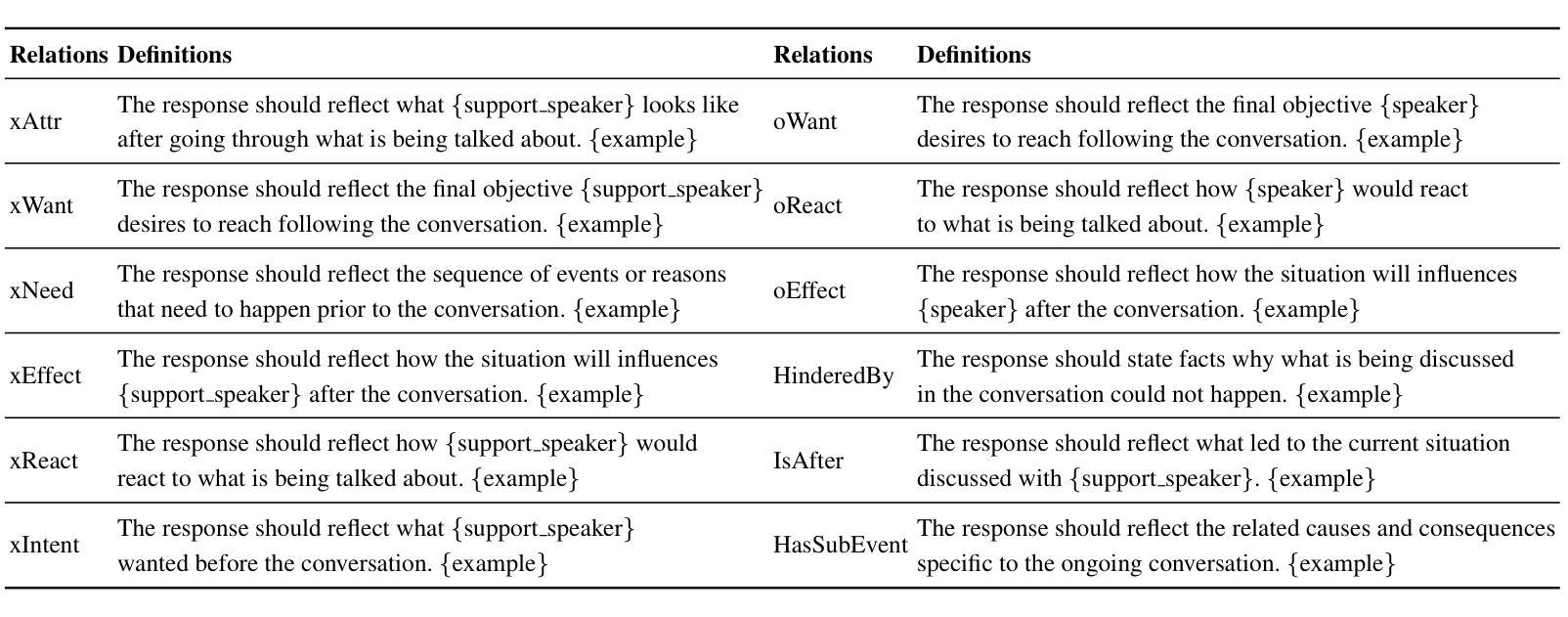

Authors:Marcos Estecha-Garitagoitia, Chen Zhang, Mario Rodríguez-Cantelar, Luis Fernando D’Haro

This paper provides preliminary results on exploring the task of performing turn-level data augmentation for dialogue system based on different types of commonsense relationships, and the automatic evaluation of the generated synthetic turns. The proposed methodology takes advantage of the extended knowledge and zero-shot capabilities of pretrained Large Language Models (LLMs) to follow instructions, understand contextual information, and their commonsense reasoning capabilities. The approach draws inspiration from methodologies like Chain-of-Thought (CoT), applied more explicitly to the task of prompt-based generation for dialogue-based data augmentation conditioned on commonsense attributes, and the automatic evaluation of the generated dialogues. To assess the effectiveness of the proposed approach, first we extracted 200 randomly selected partial dialogues, from 5 different well-known dialogue datasets, and generate alternative responses conditioned on different event commonsense attributes. This novel dataset allows us to measure the proficiency of LLMs in generating contextually relevant commonsense knowledge, particularly up to 12 different specific ATOMIC [10] database relations. Secondly, we propose an evaluation framework to automatically detect the quality of the generated dataset inspired by the ACCENT [26] metric, which offers a nuanced approach to assess event commonsense. However, our method does not follow ACCENT’s complex eventrelation tuple extraction process. Instead, we propose an instruction-based prompt for each commonsense attribute and use state-of-the-art LLMs to automatically detect the original attributes used when creating each augmented turn in the previous step. Preliminary results suggest that our approach effectively harnesses LLMs capabilities for commonsense reasoning and evaluation in dialogue systems.

本文提供了初步结果,探索基于不同类型常识关系的对话系统的回合级数据增强任务,以及生成合成回合的自动评估。所提出的方法利用预训练的大型语言模型(LLM)的扩展知识和零样本能力来遵循指令、理解上下文信息以及他们的常识推理能力。该方法从如思维链(CoT)等方法论中汲取灵感,更明确地应用于基于提示的生成对话数据增强任务,该任务受常识属性条件的影响,以及生成对话的自动评估。为了评估所提出方法的有效性,我们首先从5个著名的对话数据集中随机抽取了200个部分对话,根据不同的事件常识属性生成了替代响应。这个新型数据集使我们能够衡量LLM在生成与上下文相关的常识知识方面的熟练程度,特别是达到12种不同的ATOMIC [10]数据库关系。其次,我们提出了一个评估框架,该框架基于ACCENT [26]指标自动检测生成数据集的质量。然而,我们的方法并不遵循ACCENT复杂的事件关系元组提取过程。相反,我们针对每个常识属性提出了基于指令的提示,并使用最新的LLM自动检测在上一阶段创建每个增强回合时使用的原始属性。初步结果表明,我们的方法有效地利用了LLM在对话系统中的常识推理和评估能力。

论文及项目相关链接

Summary

本文初步探讨了基于不同常识关系类型的对话系统层级数据增强任务,以及生成合成对话的自动评估方法。研究利用预训练大型语言模型(LLM)的扩展知识、零样本能力和常识推理能力,明确应用于基于提示的生成式对话数据增强任务,并评估生成对话的质量。

Key Takeaways

- 利用大型语言模型(LLM)进行对话系统的数据增强,基于不同常识关系类型进行探索。

- 提出一种自动评估框架来评估生成对话的质量,该框架基于事件常识的敏锐评估方法。

- 通过从五个知名对话数据集中随机抽取的200个部分对话来测试方法的有效性。

- 生成的数据集旨在衡量语言模型在生成与上下文相关的常识知识方面的熟练程度,特别是基于ATOMIC数据库的12种特定关系。

- 提出一种简化的自动评估方法,通过为每个常识属性设计指令性提示,利用最新语言模型自动检测创建增强对话时使用的原始属性。

- 研究结果显示,该方法有效利用语言模型的常识推理能力,为对话系统带来性能提升。

点此查看论文截图

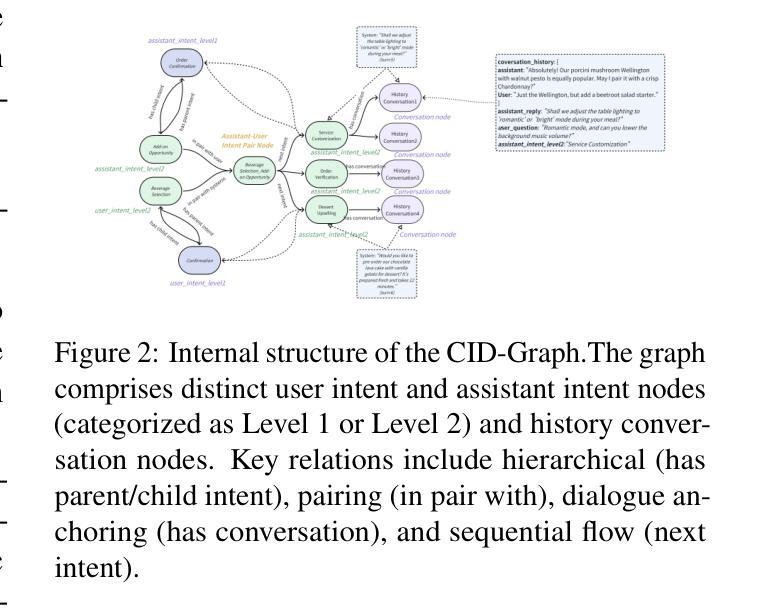

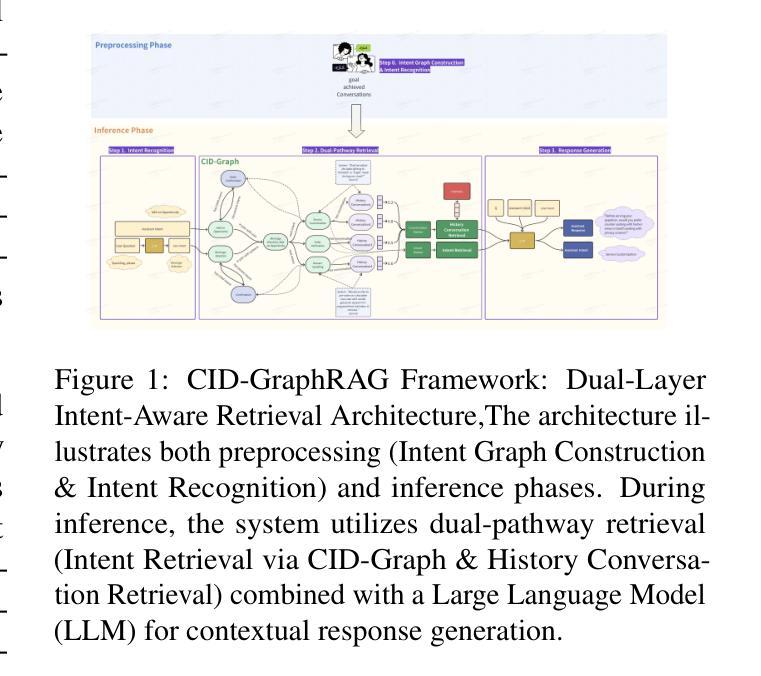

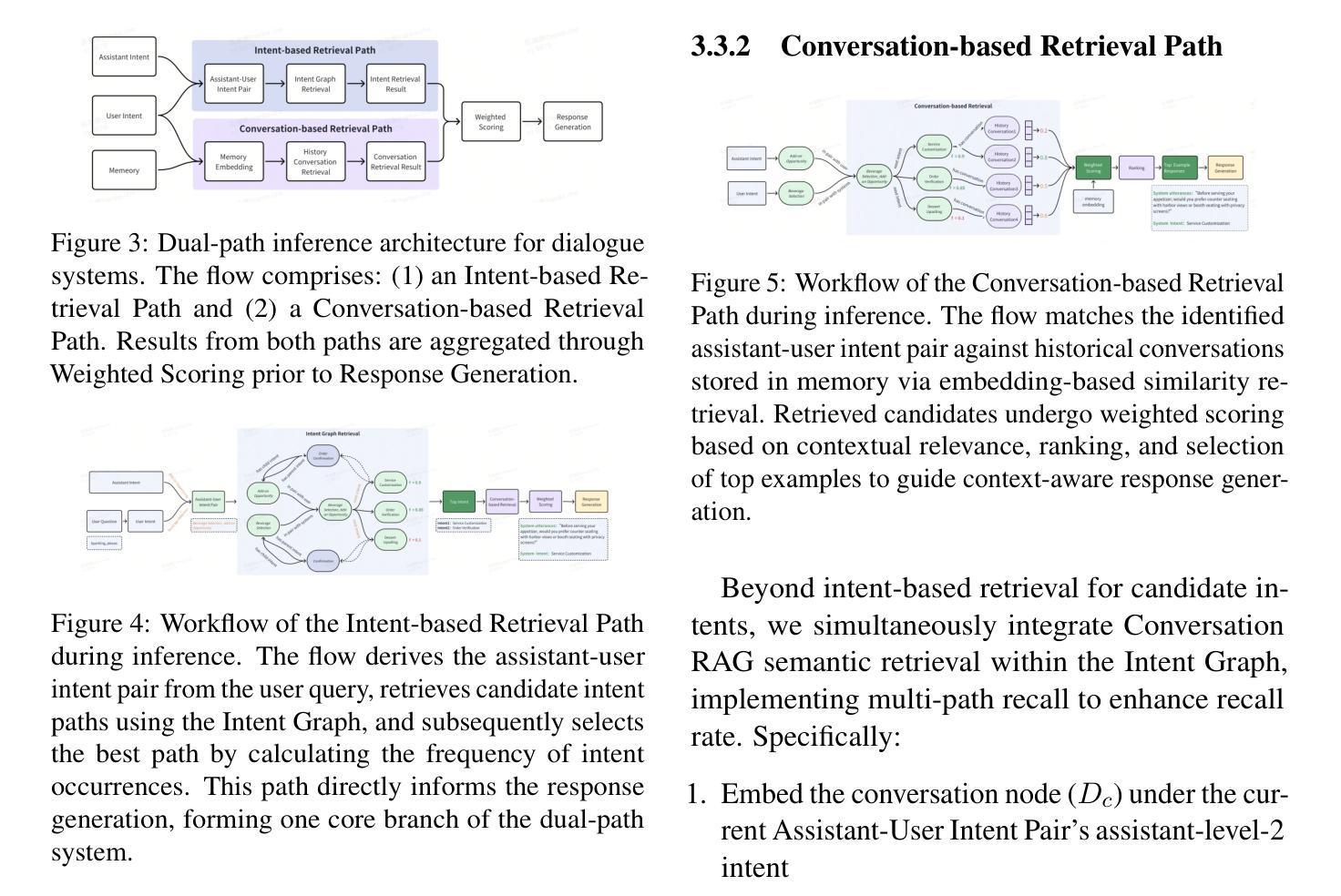

Conversational Intent-Driven GraphRAG: Enhancing Multi-Turn Dialogue Systems through Adaptive Dual-Retrieval of Flow Patterns and Context Semantics

Authors:Ziqi Zhu, Tao Hu, Honglong Zhang, Dan Yang, HanGeng Chen, Mengran Zhang, Xilun Chen

We present CID-GraphRAG (Conversational Intent-Driven Graph Retrieval Augmented Generation), a novel framework that addresses the limitations of existing dialogue systems in maintaining both contextual coherence and goal-oriented progression in multi-turn customer service conversations. Unlike traditional RAG systems that rely solely on semantic similarity (Conversation RAG) or standard knowledge graphs (GraphRAG), CID-GraphRAG constructs dynamic intent transition graphs from goal achieved historical dialogues and implements a dual-retrieval mechanism that adaptively balances intent-based graph traversal with semantic search. This approach enables the system to simultaneously leverage both conversional intent flow patterns and contextual semantics, significantly improving retrieval quality and response quality. In extensive experiments on real-world customer service dialogues, we employ both automatic metrics and LLM-as-judge assessments, demonstrating that CID-GraphRAG significantly outperforms both semantic-based Conversation RAG and intent-based GraphRAG baselines across all evaluation criteria. Quantitatively, CID-GraphRAG demonstrates substantial improvements over Conversation RAG across automatic metrics, with relative gains of 11% in BLEU, 5% in ROUGE-L, 6% in METEOR, and most notably, a 58% improvement in response quality according to LLM-as-judge evaluations. These results demonstrate that the integration of intent transition structures with semantic retrieval creates a synergistic effect that neither approach achieves independently, establishing CID-GraphRAG as an effective framework for addressing the challenges of maintaining contextual coherence and goal-oriented progression in knowledge-intensive multi-turn dialogues.

我们提出了CID-GraphRAG(会话意图驱动的图检索增强生成),这是一种新的框架,解决了现有对话系统在维持多轮客户服务对话的上下文连贯性和目标导向进展方面的局限性。与传统的仅依赖语义相似性的RAG系统(对话RAG)或标准知识图谱(GraphRAG)不同,CID-GraphRAG从已实现的目标对话中构建动态意图转移图,并实现了双检索机制,该机制自适应地平衡了基于意图的图遍历和语义搜索。这种方法使系统能够同时利用会话意图流模式和上下文语义,显著提高了检索质量和响应质量。我们在现实世界的客户服务对话中进行了大量实验,采用了自动指标和LLM作为评委的评估方法,证明了CID-GraphRAG在所有这些评估标准上都显著优于基于语义的对话RAG和基于意图的GraphRAG基准。定量上,CID-GraphRAG在自动指标上相对于对话RAG有了显著改进,BLEU得分提高11%,ROUGE-L得分提高5%,METEOR得分提高6%,并且根据LLM作为评委的评估,响应质量提高了58%。这些结果表明,意图转移结构与语义检索的结合产生了协同作用,任何一种方法都无法独立实现,因此确立了CID-GraphRAG作为一个有效的框架,用于应对知识密集型多轮对话中保持上下文连贯性和目标导向进展的挑战。

论文及项目相关链接

摘要

CID-GraphRAG(会话意图驱动的图检索增强生成)是一个新颖框架,解决了现有对话系统在维持多轮客户服务对话中的上下文连贯性和目标导向进展方面的局限性。与传统的仅依赖语义相似性的RAG系统(会话RAG)或标准知识图谱(GraphRAG)不同,CID-GraphRAG构建动态意图转换图,通过已实现目标的历史对话,并实现了双检索机制,该机制自适应地平衡了基于意图的图遍历和语义搜索。这种方法使系统能够同时利用会话意图流模式和上下文语义,显著提高了检索质量和响应质量。在现实世界客户服务对话的广泛实验中,我们采用了自动度量标准和LLM评估,证明了CID-GraphRAG在各项评估标准上显著优于语义基础的会话RAG和基于意图的GraphRAG基线。定量数据显示,CID-GraphRAG在自动度量标准上的相对改进显著,BLEU提高11%,ROUGE-L提高5%,METEOR提高6%,最重要的是,根据LLM评估,响应质量提高58%。这些结果表明,意图转换结构与语义检索的结合产生了协同作用,而单一方法无法实现这种协同作用,因此确立了CID-GraphRAG作为解决知识密集型多轮对话中维持上下文连贯性和目标导向进展挑战的有效框架。

关键见解

- CID-GraphRAG是一个新颖框架,用于解决对话系统在维持多轮客户服务对话中的上下文连贯性和目标导向进展方面的局限性。

- 与传统RAG系统和知识图谱不同,CID-GraphRAG构建动态意图转换图并实施了双检索机制。

- 该框架结合了会话意图流模式和上下文语义,提高了检索和响应质量。

- 在现实世界的客户服务对话中进行了广泛实验,证明CID-GraphRAG显著优于其他方法。

- CID-GraphRAG在自动评估指标上的改进显著,特别是在响应质量方面。

- 结果表明意图转换结构与语义检索的协同作用对于提高对话系统性能至关重要。

点此查看论文截图