⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-26 更新

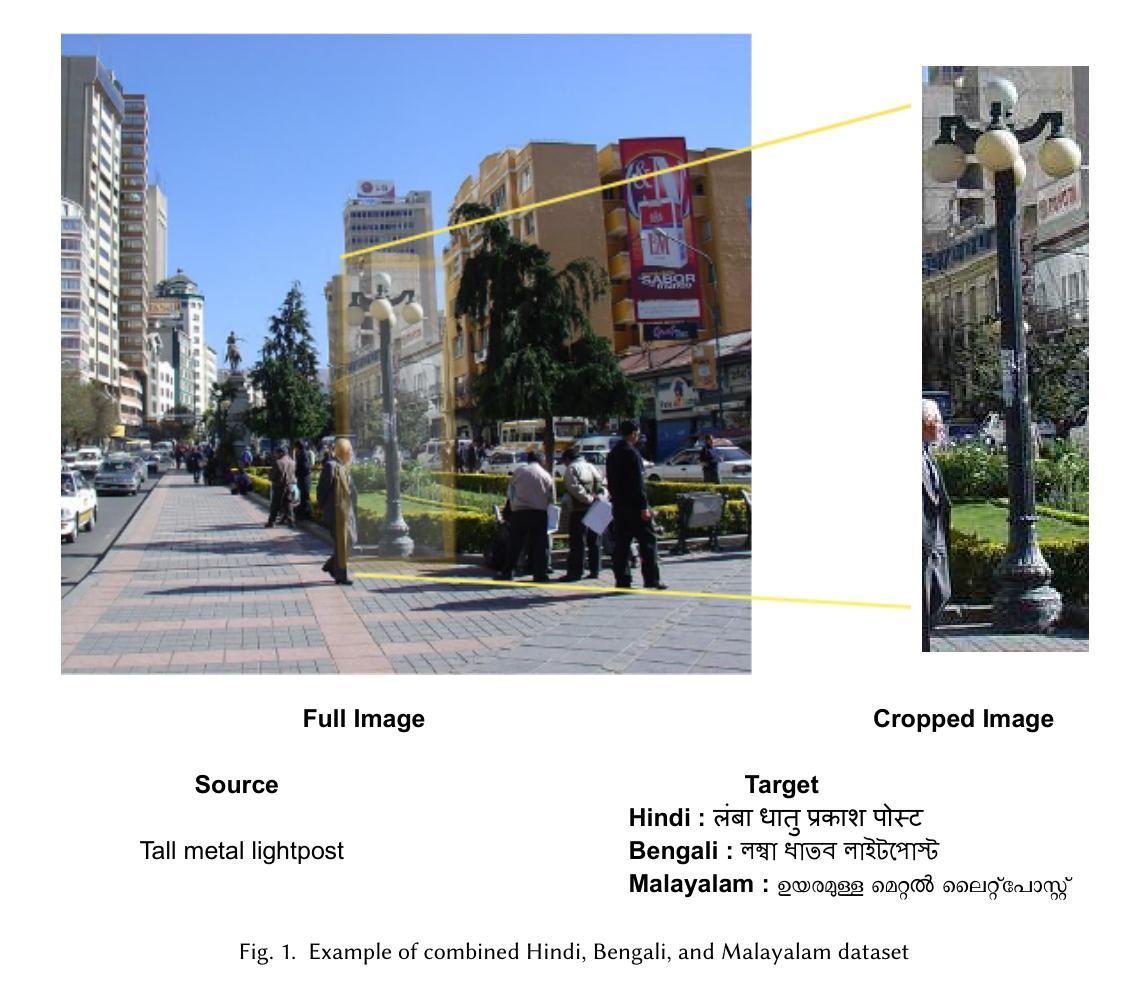

Impact of Visual Context on Noisy Multimodal NMT: An Empirical Study for English to Indian Languages

Authors:Baban Gain, Dibyanayan Bandyopadhyay, Samrat Mukherjee, Chandranath Adak, Asif Ekbal

Neural Machine Translation (NMT) has made remarkable progress using large-scale textual data, but the potential of incorporating multimodal inputs, especially visual information, remains underexplored in high-resource settings. While prior research has focused on using multimodal data in low-resource scenarios, this study examines how image features impact translation when added to a large-scale, pre-trained unimodal NMT system. Surprisingly, the study finds that images might be redundant in this context. Additionally, the research introduces synthetic noise to assess whether images help the model handle textual noise. Multimodal models slightly outperform text-only models in noisy settings, even when random images are used. The study’s experiments translate from English to Hindi, Bengali, and Malayalam, significantly outperforming state-of-the-art benchmarks. Interestingly, the effect of visual context varies with the level of source text noise: no visual context works best for non-noisy translations, cropped image features are optimal for low noise, and full image features perform better in high-noise scenarios. This sheds light on the role of visual context, especially in noisy settings, and opens up a new research direction for Noisy Neural Machine Translation in multimodal setups. The research emphasizes the importance of combining visual and textual information to improve translation across various environments. Our code is publicly available at https://github.com/babangain/indicMMT.

神经机器翻译(NMT)在大规模文本数据的应用上取得了显著的进步,但在高资源环境中,尤其是融入多模态输入(特别是视觉信息)的潜力尚未得到充分探索。虽然之前的研究主要集中在低资源场景中使用多模态数据,但本研究探讨了当图像特征被添加到大规模预训练的单模态NMT系统中时,如何影响翻译。令人惊讶的是,研究结果表明在这种情况下图像可能是多余的。此外,该研究还引入了合成噪声,以评估图像是否有助于模型处理文本噪声。即使在随机图像的情况下,多模态模型在噪声环境中的性能也略优于仅使用文本模型的性能。该研究的实验从英语翻译到印地语、孟加拉语和马拉雅拉姆语,显著超越了最新的基准测试。有趣的是,视觉上下文的影响随着源文本噪声水平的变化而变化:对于非噪声翻译,没有视觉上下文效果最好,对于低噪声,裁剪的图像特征最优,而在高噪声场景中,完整图像特征表现更好。这揭示了视觉上下文在噪声环境中的作用,并为多模态设置中的噪声神经机器翻译开辟了新的研究方向。该研究强调了结合视觉和文本信息以改善各种环境中的翻译的重要性。我们的代码公开在https://github.com/babangain/indicMMT。

论文及项目相关链接

Summary

大规模文本数据在神经网络机器翻译(NMT)中取得了显著进展,但尤其是在资源丰富的情况下,融入多模态输入,尤其是视觉信息的潜力尚未被充分探索。本研究关注图像特征如何影响添加到大规模预训练单模态NMT系统中的翻译效果。研究结果显示,在资源丰富的情况下,图像可能是冗余的。此外,研究还引入了合成噪声,以评估图像是否有助于模型处理文本噪声。在多模态模型中,即使在随机图像的情况下,也略微优于仅使用文本模型的噪声环境翻译。该研究从英语翻译到印地语、孟加拉语和马拉雅拉姆语的实验显著优于现有最佳基准测试。有趣的是,视觉上下文的影响随源文本噪声水平而变化:无视觉上下文在非噪声翻译中表现最佳,裁剪图像特征在低噪声下最优,而完整图像特征在高噪声场景中表现更好。这为解决噪声环境下的视觉上下文作用提供了新的研究方向,并强调了结合视觉和文本信息在各种环境中改进翻译的重要性。相关代码已公开在https://github.com/babangain/indicMMT。

Key Takeaways

- 神经网络机器翻译(NMT)虽然在大规模文本数据上取得了进展,但在资源丰富的情况下融入多模态输入(尤其是视觉信息)的潜力尚未被充分探索。

- 在资源丰富的情况下,图像可能是冗余的,对翻译效果的影响需要进一步研究。

- 通过引入合成噪声,研究评估了图像在帮助模型处理文本噪声方面的作用。

- 多模态模型在噪声环境下的翻译性能略优于仅使用文本模型的性能。

- 不同水平的源文本噪声对视觉上下文的影响不同,这为解决噪声环境下的视觉上下文作用提供了新的研究方向。

- 结合视觉和文本信息在各种环境中可以改进翻译效果。

点此查看论文截图