⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-28 更新

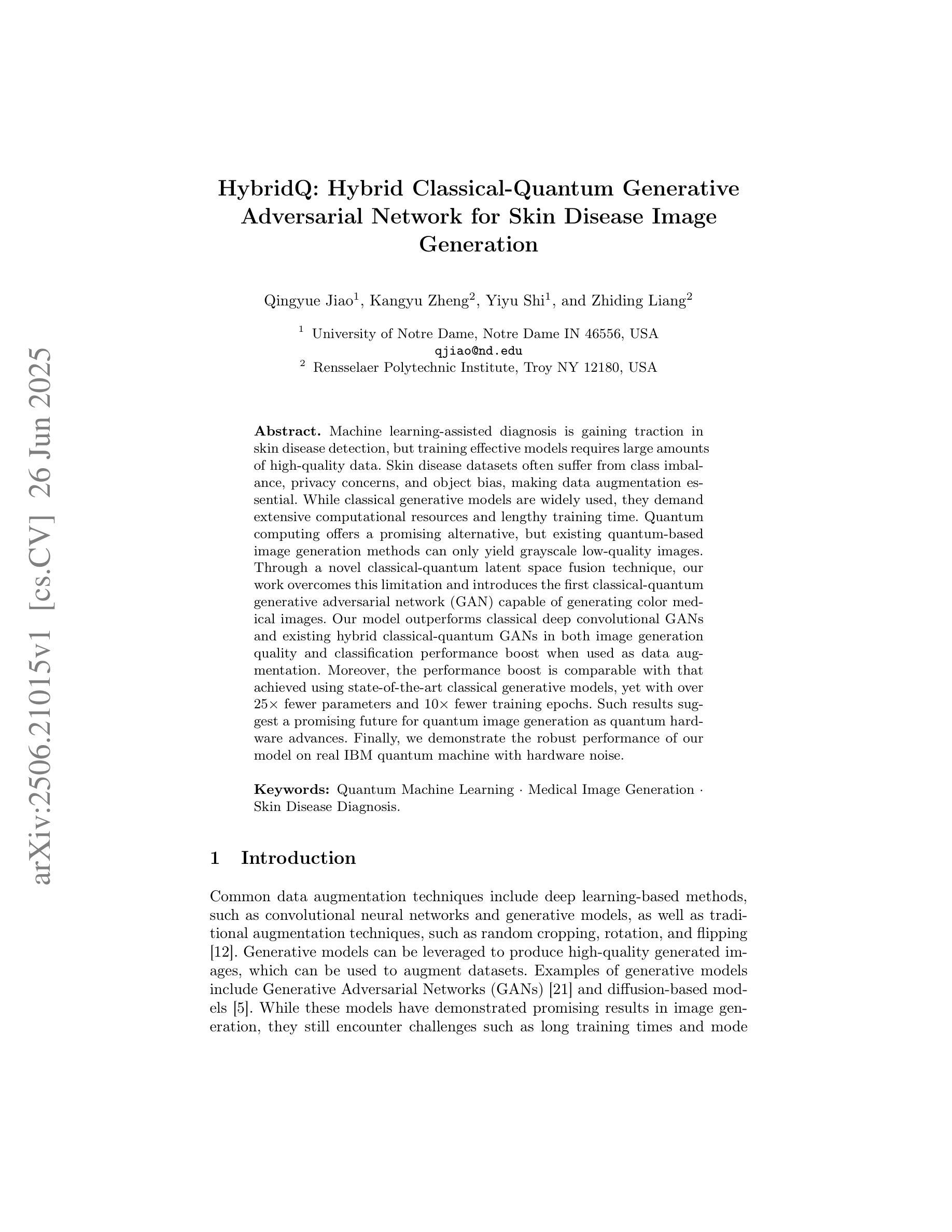

HybridQ: Hybrid Classical-Quantum Generative Adversarial Network for Skin Disease Image Generation

Authors:Qingyue Jiao, Kangyu Zheng, Yiyu Shi, Zhiding Liang

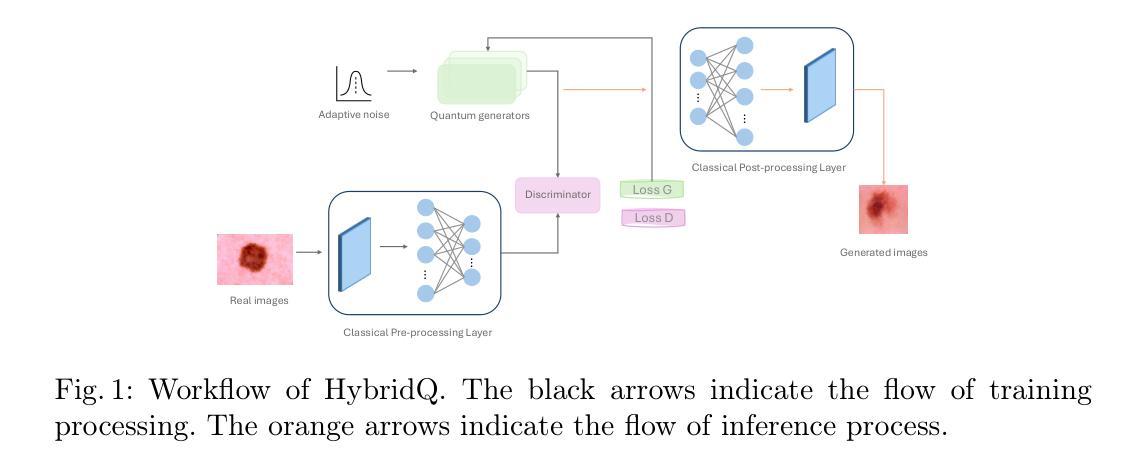

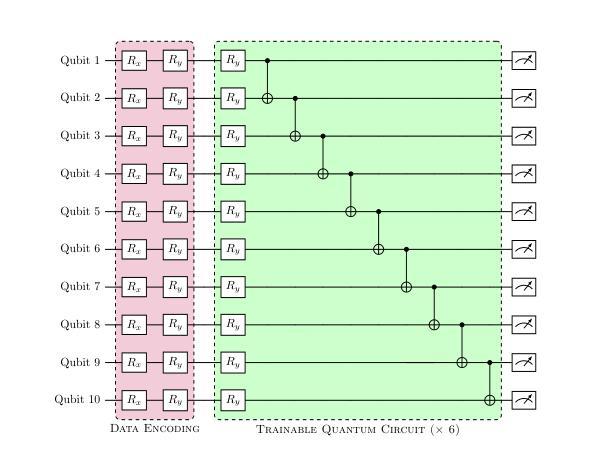

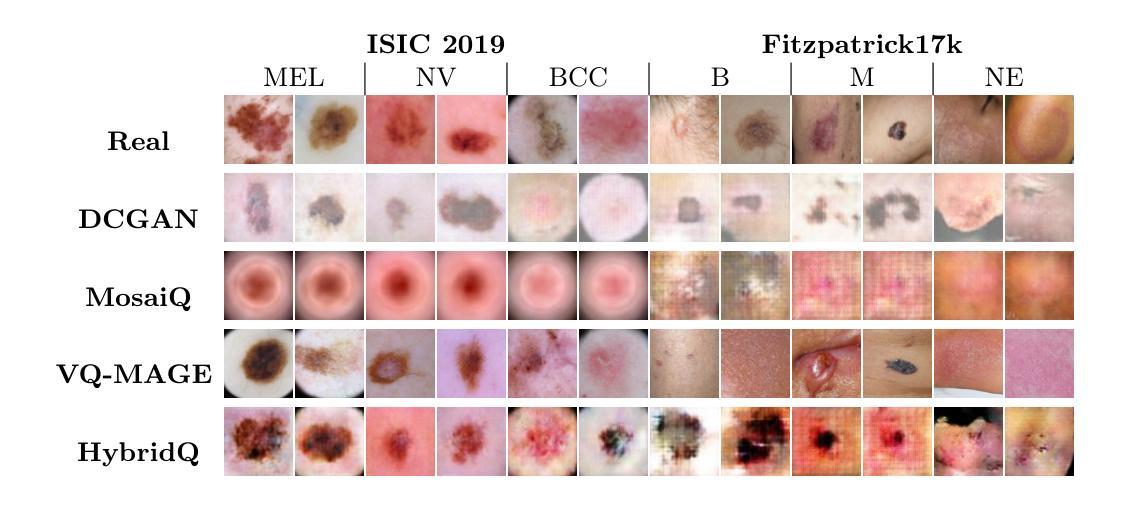

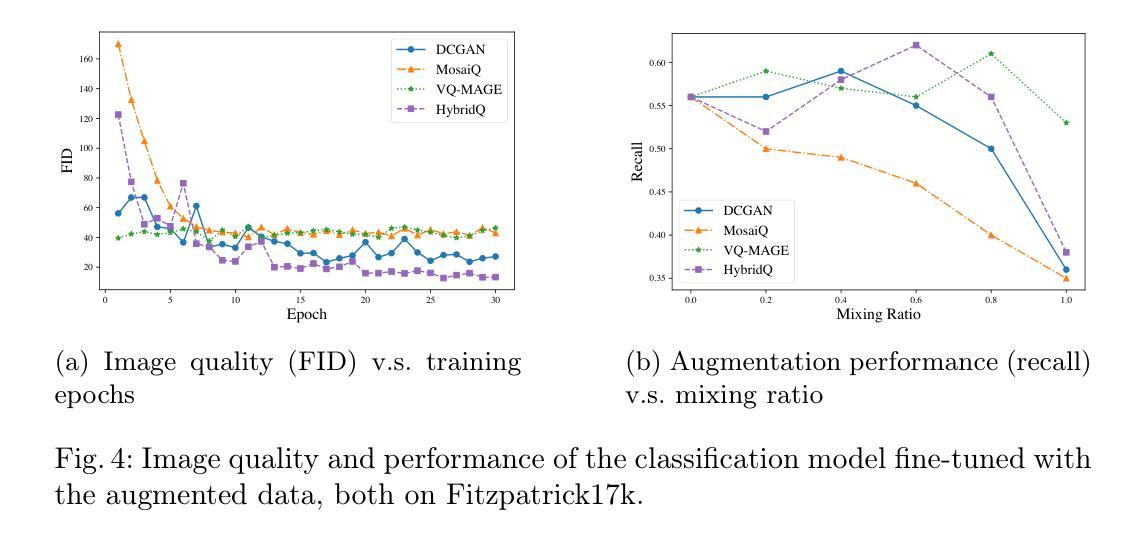

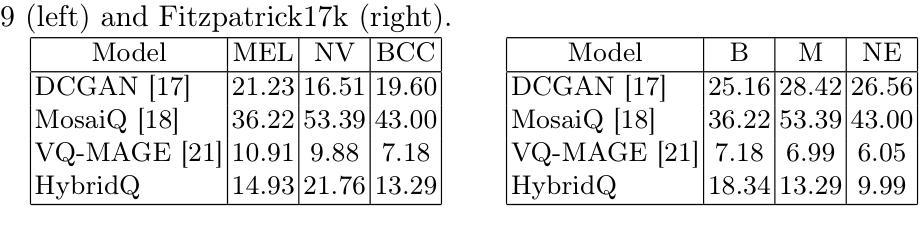

Machine learning-assisted diagnosis is gaining traction in skin disease detection, but training effective models requires large amounts of high-quality data. Skin disease datasets often suffer from class imbalance, privacy concerns, and object bias, making data augmentation essential. While classical generative models are widely used, they demand extensive computational resources and lengthy training time. Quantum computing offers a promising alternative, but existing quantum-based image generation methods can only yield grayscale low-quality images. Through a novel classical-quantum latent space fusion technique, our work overcomes this limitation and introduces the first classical-quantum generative adversarial network (GAN) capable of generating color medical images. Our model outperforms classical deep convolutional GANs and existing hybrid classical-quantum GANs in both image generation quality and classification performance boost when used as data augmentation. Moreover, the performance boost is comparable with that achieved using state-of-the-art classical generative models, yet with over 25 times fewer parameters and 10 times fewer training epochs. Such results suggest a promising future for quantum image generation as quantum hardware advances. Finally, we demonstrate the robust performance of our model on real IBM quantum machine with hardware noise.

机器学习辅助诊断在皮肤病检测中越来越受到重视,但训练有效的模型需要大量的高质量数据。皮肤病数据集经常面临类别不平衡、隐私担忧和对象偏见等问题,这使得数据增强变得至关重要。虽然经典的生成模型被广泛应用,但它们需要大量的计算资源和漫长的训练时间。量子计算提供了一个有前景的替代方案,但现有的基于量子图像生成的方法只能产生灰度低质量的图像。通过一种新颖的经典-量子潜在空间融合技术,我们的工作克服了这一限制,并引入了第一个经典-量子生成对抗网络(GAN),能够生成彩色医学图像。我们的模型在图像生成质量和分类性能提升方面都优于经典的深度卷积GANs和现有的混合经典-量子GANs,在用作数据增强时表现尤为突出。此外,性能提升与最先进的经典生成模型相当,但参数少了25倍以上,训练周期也减少了10倍以上。随着量子硬件的进步,这些结果预示着量子图像生成具有光明的未来。最后,我们在带有硬件噪声的真实IBM量子计算机上展示了模型的稳健性能。

论文及项目相关链接

Summary

本文提出一种融合经典与量子计算的方法,构建了一个生成对抗网络(GAN),用于生成彩色医学图像。该方法克服了现有量子图像生成方法的局限性,可以生成高质量彩色皮肤疾病图像,用于辅助机器学习和诊断。与传统方法相比,该模型在图像生成质量和分类性能上都有显著提升,且参数更少,训练周期更短。此外,该模型在IBM真实量子机器上表现稳健。

Key Takeaways

- 机器学习辅助诊断在皮肤疾病检测中受到关注,但训练有效模型需要大量高质量数据。

- 皮肤疾病数据集存在类别不平衡、隐私问题和目标偏见等问题,使得数据增强变得重要。

- 量子计算为图像生成提供了有前景的替代方案,但现有量子图像生成方法只能生成低质量灰度图像。

- 提出一种新型经典-量子潜在空间融合技术,克服了这一局限性,并引入了首个能够生成彩色医学图像的古典-量子生成对抗网络(GAN)。

- 该模型在图像生成质量和分类性能提升方面优于传统的深度卷积GANs和现有的混合古典-量子GANs。

- 与最先进的经典生成模型相比,该模型的性能提升相当,但参数更少(超过25倍),训练周期也更少(减少10倍)。

点此查看论文截图

3DGH: 3D Head Generation with Composable Hair and Face

Authors:Chengan He, Junxuan Li, Tobias Kirschstein, Artem Sevastopolsky, Shunsuke Saito, Qingyang Tan, Javier Romero, Chen Cao, Holly Rushmeier, Giljoo Nam

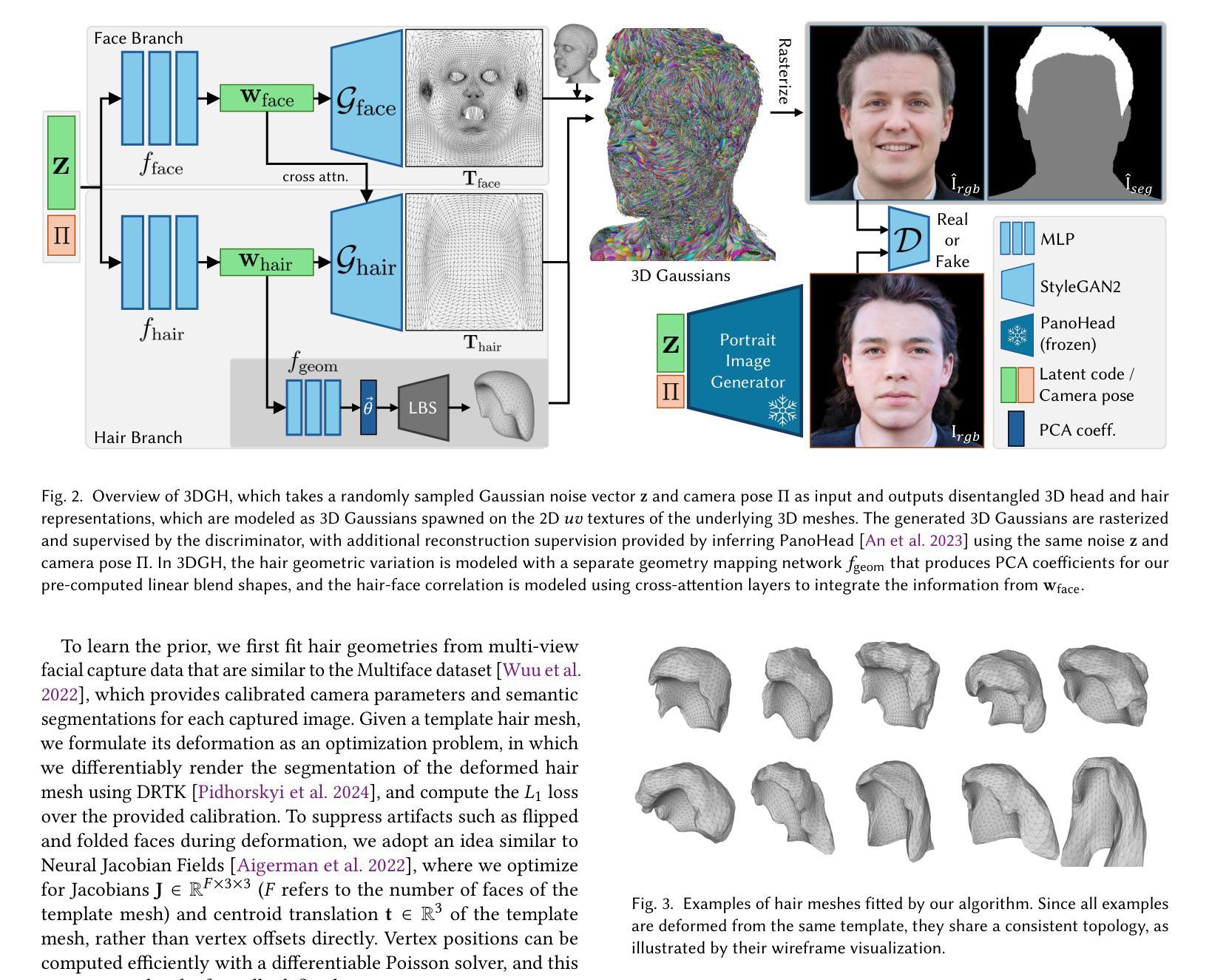

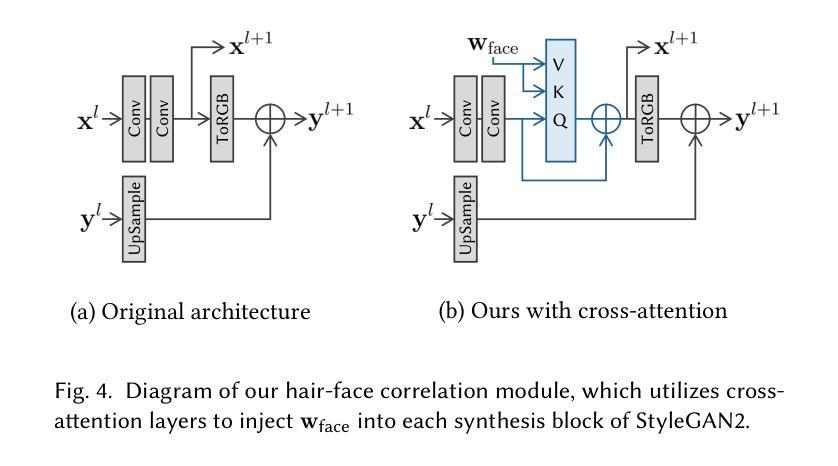

We present 3DGH, an unconditional generative model for 3D human heads with composable hair and face components. Unlike previous work that entangles the modeling of hair and face, we propose to separate them using a novel data representation with template-based 3D Gaussian Splatting, in which deformable hair geometry is introduced to capture the geometric variations across different hairstyles. Based on this data representation, we design a 3D GAN-based architecture with dual generators and employ a cross-attention mechanism to model the inherent correlation between hair and face. The model is trained on synthetic renderings using carefully designed objectives to stabilize training and facilitate hair-face separation. We conduct extensive experiments to validate the design choice of 3DGH, and evaluate it both qualitatively and quantitatively by comparing with several state-of-the-art 3D GAN methods, demonstrating its effectiveness in unconditional full-head image synthesis and composable 3D hairstyle editing. More details will be available on our project page: https://c-he.github.io/projects/3dgh/.

我们提出了3DGH,这是一个用于生成具有可组合头发和面部组件的3D人头的无条件生成模型。与以前将头发和面部建模纠缠在一起的工作不同,我们提出了一种基于模板的3D高斯斑点图的新数据表示法来分离它们,其中引入了可变形头发几何来捕捉不同发型之间的几何变化。基于这种数据表示,我们设计了一种基于3D GAN的架构,具有双生成器,并采用交叉注意力机制来建模头发和面部之间的内在关联。该模型在合成渲染图像上进行训练,使用精心设计的目标来稳定训练和促进头发与面部的分离。我们进行了大量实验来验证3DGH的设计选择,并通过与几种最先进的3D GAN方法进行比较,从定性和定量两个方面对其进行了评估,证明了它在无条件全头图像合成和可编辑的3D发型编辑方面的有效性。更多详细信息将公布在我们的项目页面:https://c-he.github.io/projects/3dgh/。

论文及项目相关链接

PDF Accepted to SIGGRAPH 2025. Project page: https://c-he.github.io/projects/3dgh/

摘要

本文提出了一种用于生成三维人类头部的不条件生成模型——3DGH,该模型具有可组合的发型和面部组件。与以往将发型和面部建模纠缠在一起的工作不同,本文提出了一种基于模板的三维高斯喷绘的新数据表示方法,引入可变形头发几何来捕捉不同发型之间的几何变化以实现发型与面部的分离。基于这种数据表示,设计了一种基于三维生成对抗网络(GAN)的架构,采用双生成器和交叉注意力机制来模拟发型和面部之间的内在关联。该模型在合成渲染图像上进行训练,采用精心设计的目标来稳定训练过程并促进发型与面部的分离。通过大量实验验证了3DGH的设计选择,并与几种最先进的三维GAN方法进行了比较,展示了其在无条件全头图像合成和可编辑三维发型设计中的有效性。更多详细信息请访问我们的项目网站:网站链接。

关键见解

- 提出了一个全新的无条件生成模型3DGH,专门用于生成三维人类头部,包括可组合的发型和面部组件。

- 采用了一种基于模板的三维高斯喷绘数据表示方法,实现了发型与面部建模的分离。

- 引入可变形头发几何来捕捉不同发型间的几何变化。

- 基于三维GAN架构,采用双生成器和交叉注意力机制设计,以模拟发型和面部之间的内在关联。

- 在合成渲染图像上训练模型,采用精心设计的目标来稳定训练过程并促进发型与面部的分离。

- 通过广泛实验验证了模型的有效性,与现有先进技术进行了比较。

点此查看论文截图