⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-28 更新

PanSt3R: Multi-view Consistent Panoptic Segmentation

Authors:Lojze Zust, Yohann Cabon, Juliette Marrie, Leonid Antsfeld, Boris Chidlovskii, Jerome Revaud, Gabriela Csurka

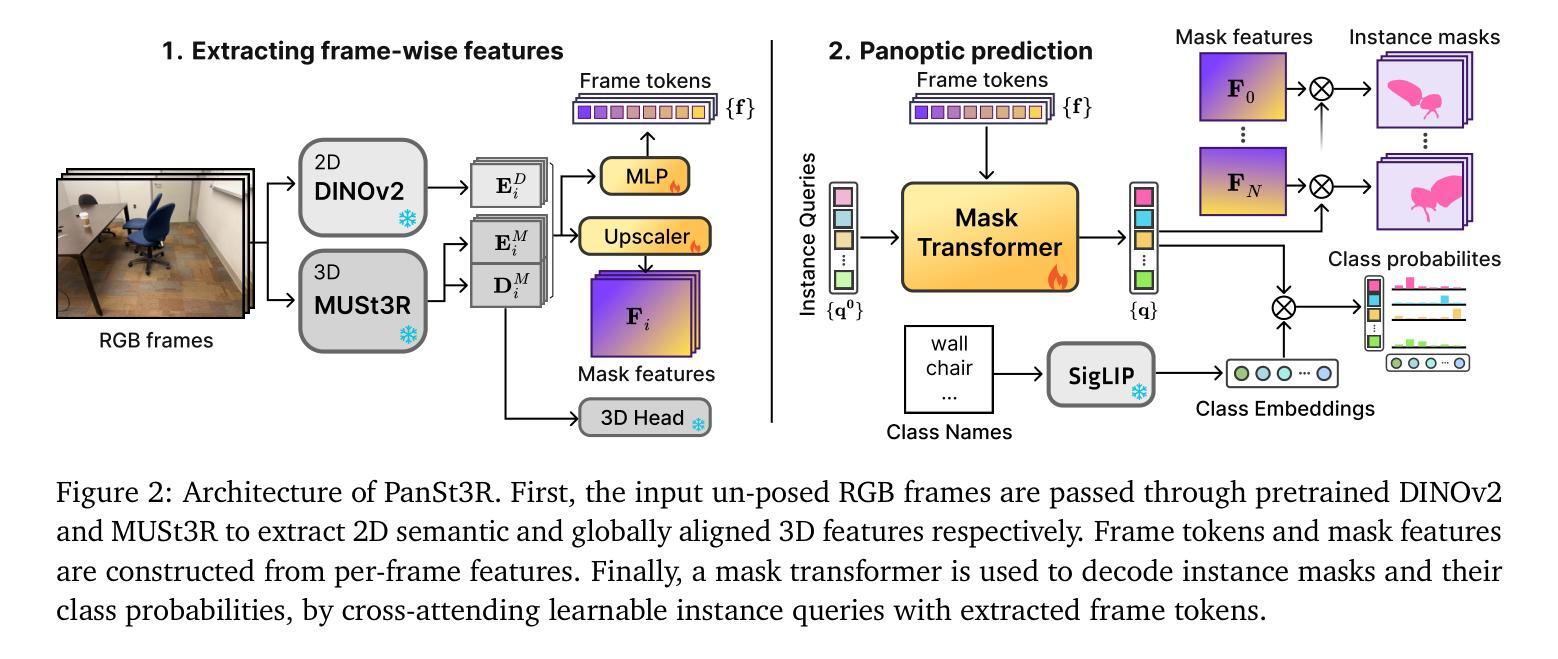

Panoptic segmentation of 3D scenes, involving the segmentation and classification of object instances in a dense 3D reconstruction of a scene, is a challenging problem, especially when relying solely on unposed 2D images. Existing approaches typically leverage off-the-shelf models to extract per-frame 2D panoptic segmentations, before optimizing an implicit geometric representation (often based on NeRF) to integrate and fuse the 2D predictions. We argue that relying on 2D panoptic segmentation for a problem inherently 3D and multi-view is likely suboptimal as it fails to leverage the full potential of spatial relationships across views. In addition to requiring camera parameters, these approaches also necessitate computationally expensive test-time optimization for each scene. Instead, in this work, we propose a unified and integrated approach PanSt3R, which eliminates the need for test-time optimization by jointly predicting 3D geometry and multi-view panoptic segmentation in a single forward pass. Our approach builds upon recent advances in 3D reconstruction, specifically upon MUSt3R, a scalable multi-view version of DUSt3R, and enhances it with semantic awareness and multi-view panoptic segmentation capabilities. We additionally revisit the standard post-processing mask merging procedure and introduce a more principled approach for multi-view segmentation. We also introduce a simple method for generating novel-view predictions based on the predictions of PanSt3R and vanilla 3DGS. Overall, the proposed PanSt3R is conceptually simple, yet fast and scalable, and achieves state-of-the-art performance on several benchmarks, while being orders of magnitude faster than existing methods.

三维场景的泛景分割(Panoptic segmentation)是一个具有挑战性的问题,尤其是在仅依赖无姿态的二维图像进行密集的三维场景重建中的对象实例分割和分类时。现有方法通常使用现成的模型来提取每帧的二维泛景分割,然后优化隐式几何表示(通常基于NeRF)来集成和融合二维预测结果。我们认为,依赖二维泛景分割来解决固有的三维多视角问题是次优的,因为它未能充分利用跨视角的空间关系的潜力。此外,这些方法不仅需要相机参数,还需要对每个场景进行昂贵的测试时间优化。相反,在这项工作中,我们提出了一种统一和集成的PanSt3R方法,通过联合预测三维几何和多视角泛景分割,在一次前向传递中消除了对测试时间优化的需求。我们的方法建立在最近的3D重建技术的基础上,特别是可伸缩的多视角版本的DUSt3R的MUSt3R,并通过语义意识和多视角泛景分割能力增强了其功能。我们还重新审视了标准的后处理掩膜合并过程,并引入了一种更原则的多视角分割方法。此外,我们还提出了一种基于PanSt3R和香草3DGS预测的新视角预测的简单方法。总的来说,所提出的PanSt3R在概念上很简单,既快速又可扩展,在多个基准测试中达到了最先进的性能,同时比现有方法快几个数量级。

论文及项目相关链接

PDF Accepted at ICCV 2025

摘要

本文探讨了基于NeRF技术的Panoptic全景场景分割技术的新进展。传统方法主要依赖于每帧的二维全景分割提取模型进行场景的三维重建和分类,然而这种依赖于二维全景分割对本质上是三维多视角的问题并不理想。为解决此问题,本文提出了一种联合预测三维几何和多视角全景分割的统一方法PanSt3R。此方法不需要测试时的优化步骤,一次性即可完成任务,并以更快更优秀的方式达到了在各种数据集上的性能标杆。本研究充分利用三维重建的优势进行多维预测处理,并提出了更科学的后处理合并策略以及基于预测的全视角预测生成方法。总体来说,PanSt3R模型简洁高效,在多个基准测试中均表现优异。

关键见解

- Panoptic全景场景分割涉及场景的密集三维重建中的对象实例分割和分类,是一个具有挑战性的课题。现有的基于NeRF的方法依赖现有的模型进行二维全景分割提取,然后优化隐式几何表示进行融合预测。然而,这种方法在处理多视角问题时并不理想。

- PanSt3R方法通过联合预测三维几何和多视角全景分割,避免了测试时的优化步骤,简化了流程并提高了效率。该方法利用最近的三维重建技术,尤其是MUSt3R的优势,并增强了其语义感知和多视角全景分割能力。此外,还重新审视了标准后处理掩膜合并过程,并提出了更科学的原则方法用于多视角分割。该方法实现了在多视图环境下的全局信息理解和协同分割的新进展。这种方法在处理三维全景图像时表现出了优秀的性能和潜力。因此它在解决复杂场景的全景理解问题上提供了有力的支持。它的性能超过了现有方法并且大大减少了计算时间。这使得在实际应用中,如自动驾驶和虚拟现实等领域有巨大的应用前景。这也是首次将多视角全景分割和NeRF技术紧密结合在一起,提供了一个全新的解决思路和视角。这是NeRF领域的创新应用和研究进展的标志性里程碑之一。这不仅提高了计算机视觉领域的效率和能力也扩展了它的应用范围和能力在复杂场景的重建和理解方面提供了全新的解决方案和可能性。总的来说这是一个高效简洁的方法具有巨大的潜力和应用价值值得进一步研究和探索。

点此查看论文截图

2D Triangle Splatting for Direct Differentiable Mesh Training

Authors:Kaifeng Sheng, Zheng Zhou, Yingliang Peng, Qianwei Wang

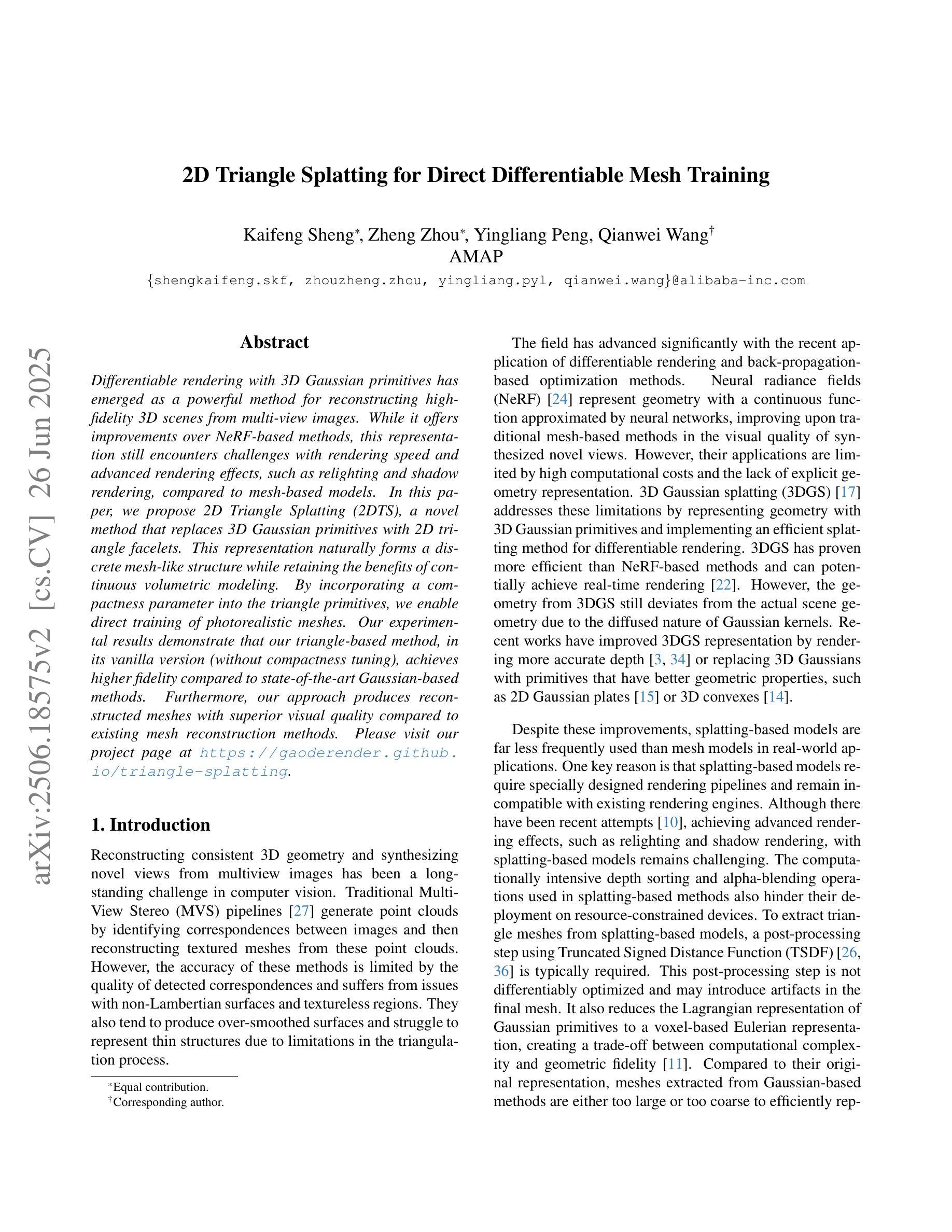

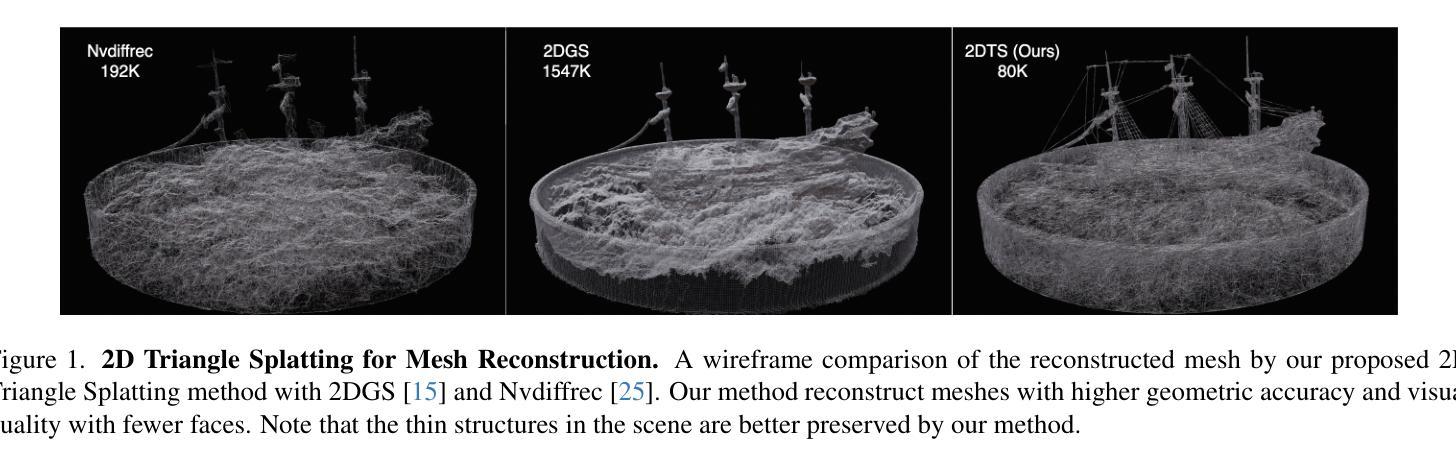

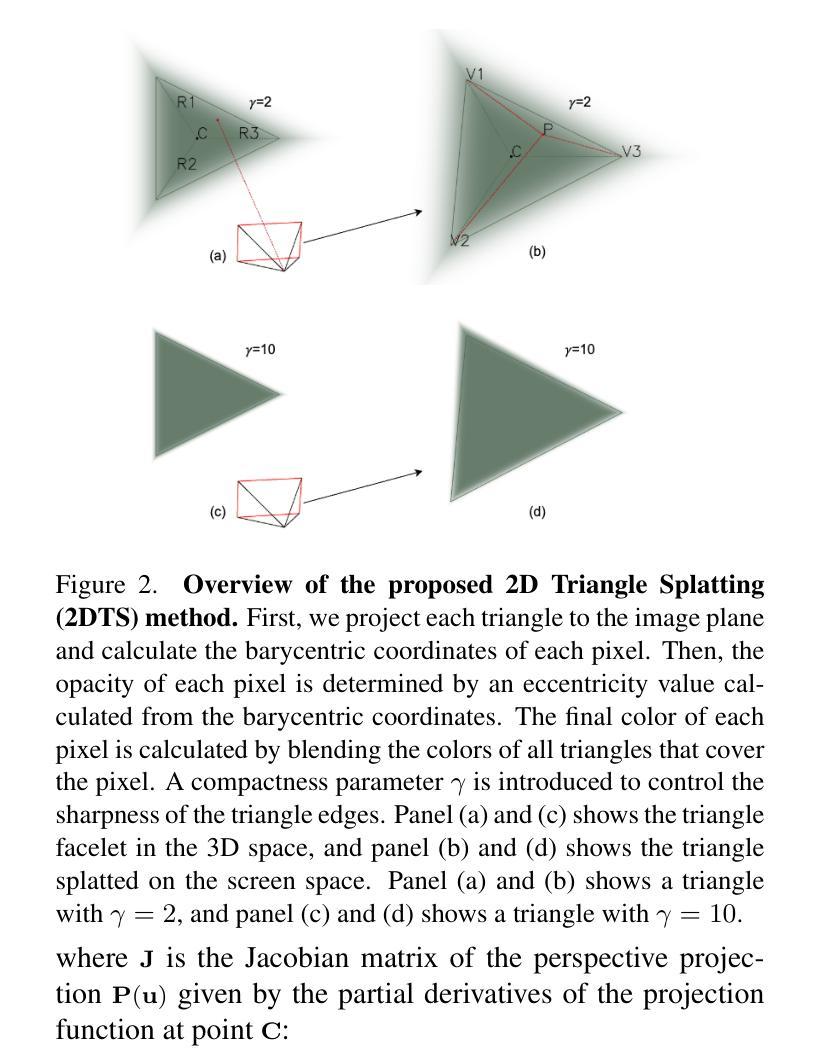

Differentiable rendering with 3D Gaussian primitives has emerged as a powerful method for reconstructing high-fidelity 3D scenes from multi-view images. While it offers improvements over NeRF-based methods, this representation still encounters challenges with rendering speed and advanced rendering effects, such as relighting and shadow rendering, compared to mesh-based models. In this paper, we propose 2D Triangle Splatting (2DTS), a novel method that replaces 3D Gaussian primitives with 2D triangle facelets. This representation naturally forms a discrete mesh-like structure while retaining the benefits of continuous volumetric modeling. By incorporating a compactness parameter into the triangle primitives, we enable direct training of photorealistic meshes. Our experimental results demonstrate that our triangle-based method, in its vanilla version (without compactness tuning), achieves higher fidelity compared to state-of-the-art Gaussian-based methods. Furthermore, our approach produces reconstructed meshes with superior visual quality compared to existing mesh reconstruction methods. Please visit our project page at https://gaoderender.github.io/triangle-splatting.

使用三维高斯基本体进行可微分渲染已经成为从多视角图像重建高保真三维场景的一种强大方法。虽然相较于基于NeRF的方法有所改进,但这种表示形式在渲染速度以及相较于基于网格的模型的先进渲染效果(如重新照明和阴影渲染)方面仍面临挑战。在本文中,我们提出了二维三角片(2DTS),这是一种用二维三角形贴片替换三维高斯基本体的新方法。这种表示形式在保持连续体积建模的优势的同时,自然地形成了离散网格状结构。通过将紧凑参数融入三角形基本体中,我们实现了对逼真网格的直接训练。我们的实验结果表明,我们的基于三角形的方法在原始版本(无紧凑度调整)上实现了与最新高斯方法相比更高的保真度。此外,我们的方法生成的重建网格在视觉质量上优于现有的网格重建方法。请访问我们的项目页面:https://gaoderender.github.io/triangle-splatting了解更多信息。

论文及项目相关链接

PDF 13 pages, 8 figures

Summary

基于二维三角剖分(2DTS)的新型渲染方法,采用二维三角面片替代三维高斯原始数据,实现了高保真三维场景的重建。该方法结合了连续体积建模的优点,自然形成离散网格结构。实验结果表明,该方法在不使用紧凑度调整的情况下,与最先进的高斯方法相比,实现了更高的保真度,并且生成的重建网格具有优越的视觉质量。

Key Takeaways

- 该论文提出了一种新型渲染方法——二维三角剖分(2DTS),利用二维三角面片替代三维高斯原始数据进行渲染。

- 2DTS方法结合了连续体积建模的优点,并自然形成了离散网格结构。

- 实验结果显示,在不使用紧凑度调整的情况下,2DTS方法与最先进的高斯方法相比具有更高的保真度。

- 该方法能够生成具有优越视觉质量的重建网格。

- 通过引入紧凑度参数,2DTS方法能够实现直接训练的光照真实感网格。

- 该论文中的项目页面提供了更多关于2DTS方法的详细信息,包括实现细节和实验结果。

点此查看论文截图