⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-07-06 更新

FixTalk: Taming Identity Leakage for High-Quality Talking Head Generation in Extreme Cases

Authors:Shuai Tan, Bill Gong, Bin Ji, Ye Pan

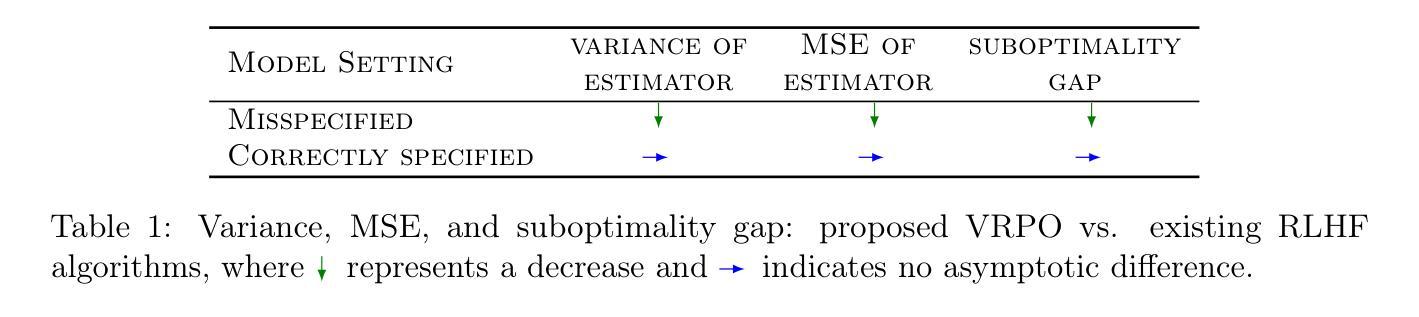

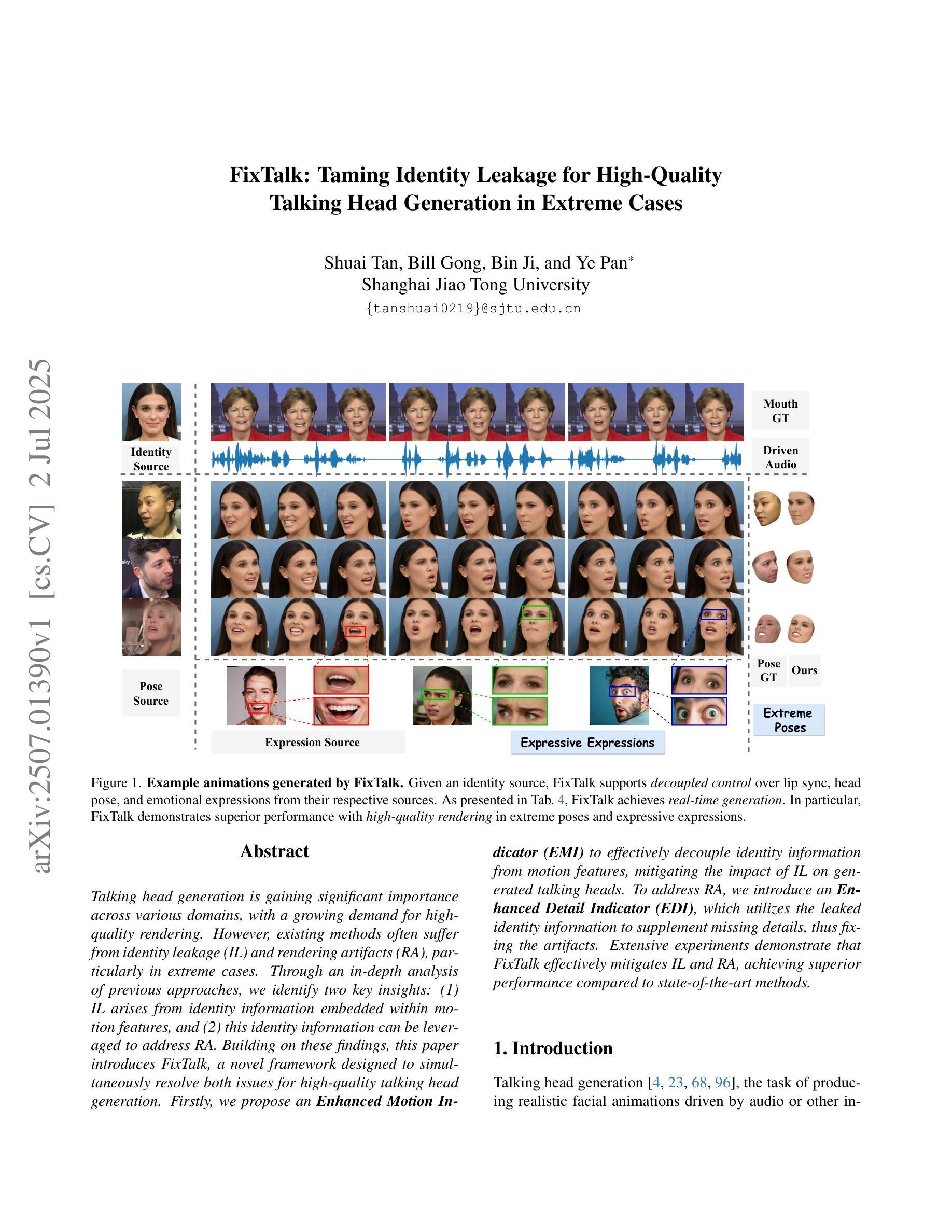

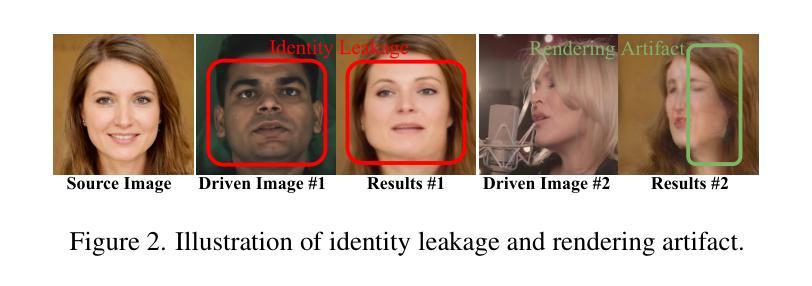

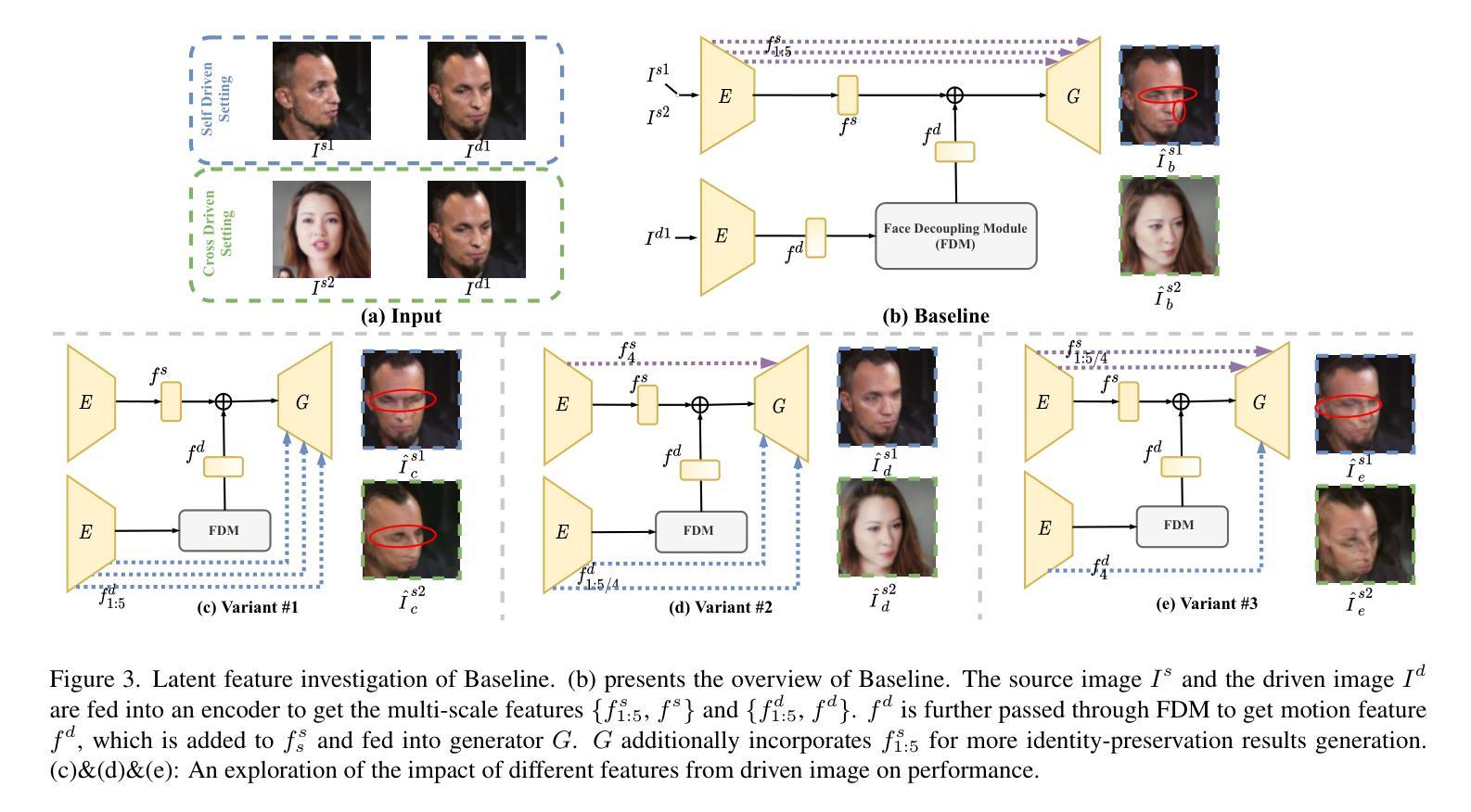

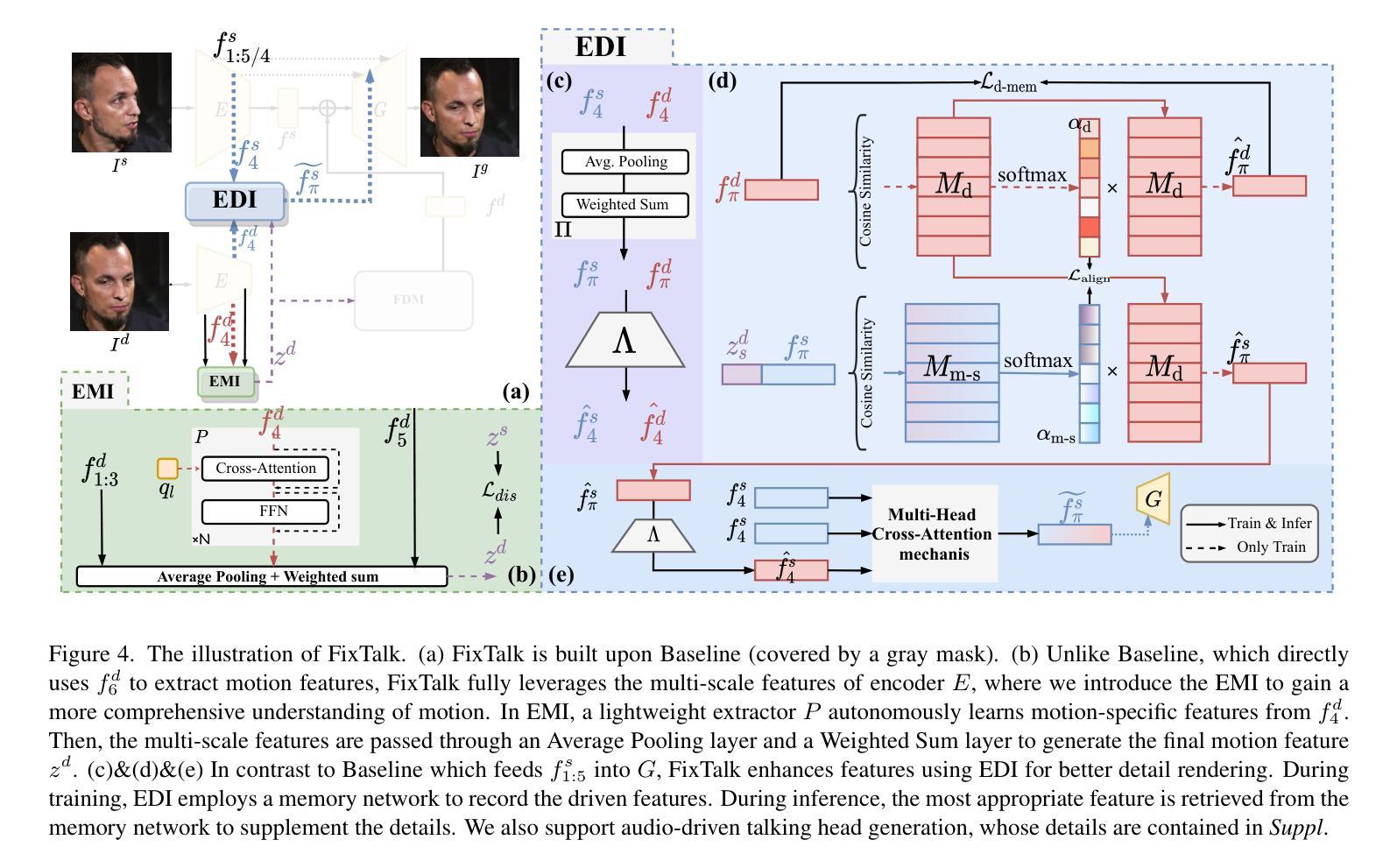

Talking head generation is gaining significant importance across various domains, with a growing demand for high-quality rendering. However, existing methods often suffer from identity leakage (IL) and rendering artifacts (RA), particularly in extreme cases. Through an in-depth analysis of previous approaches, we identify two key insights: (1) IL arises from identity information embedded within motion features, and (2) this identity information can be leveraged to address RA. Building on these findings, this paper introduces FixTalk, a novel framework designed to simultaneously resolve both issues for high-quality talking head generation. Firstly, we propose an Enhanced Motion Indicator (EMI) to effectively decouple identity information from motion features, mitigating the impact of IL on generated talking heads. To address RA, we introduce an Enhanced Detail Indicator (EDI), which utilizes the leaked identity information to supplement missing details, thus fixing the artifacts. Extensive experiments demonstrate that FixTalk effectively mitigates IL and RA, achieving superior performance compared to state-of-the-art methods.

头部生成技术在各个领域都获得了巨大的重要性,并且对高质量渲染的需求也在日益增长。然而,现有方法经常面临身份泄露(IL)和渲染伪影(RA)的问题,特别是在极端情况下。通过对先前方法的深入分析,我们发现了两个关键见解:(1)IL源于运动特征中嵌入的身份信息;(2)可以利用这种身份信息进行RA处理。基于这些发现,本文介绍了FixTalk,这是一个新型框架,旨在同时解决这两个问题,以实现高质量的头部生成。首先,我们提出了一种增强运动指示符(EMI),可以有效地将身份信息从运动特征中分离出来,从而减轻IL对生成头部的影响。为了解决RA,我们引入了增强细节指示符(EDI),它利用泄露的身份信息来补充缺失的细节,从而修复伪影。大量实验表明,FixTalk有效地减轻了IL和RA问题,实现了与最先进的方法相比的卓越性能。

论文及项目相关链接

Summary

本文探讨了说话人头部生成技术在各个领域中的重要性,并指出了现有方法存在的身份泄露(IL)和渲染伪影(RA)问题。通过对先前方法的深入分析,本文发现了两个关键见解:(1)IL源于运动特征中的身份信息的嵌入;(2)可以利用身份信息来解决RA问题。基于这些发现,本文提出了一种名为FixTalk的新型框架,旨在同时解决这两个问题,以实现高质量的说话人头部生成。通过增强运动指示符(EMI)有效分离运动特征中的身份信息,并引入增强细节指示符(EDI)利用泄露的身份信息补充缺失的细节,从而修复伪影。实验表明,FixTalk能够有效地减轻IL和RA问题,实现相较于现有先进方法的优越性能。

Key Takeaways

- 说话头生成技术面临身份泄露(IL)和渲染伪影(RA)的挑战。

- 身份泄露源于运动特征中的身份信息嵌入。

- 可以利用身份信息来解决渲染伪影问题。

- FixTalk框架旨在同时解决IL和RA问题,实现高质量说话头生成。

- 增强运动指示符(EMI)有效分离运动特征中的身份信息。

- 增强细节指示符(EDI)利用泄露的身份信息补充缺失的细节,修复伪影。

点此查看论文截图

ARTalk: Speech-Driven 3D Head Animation via Autoregressive Model

Authors:Xuangeng Chu, Nabarun Goswami, Ziteng Cui, Hanqin Wang, Tatsuya Harada

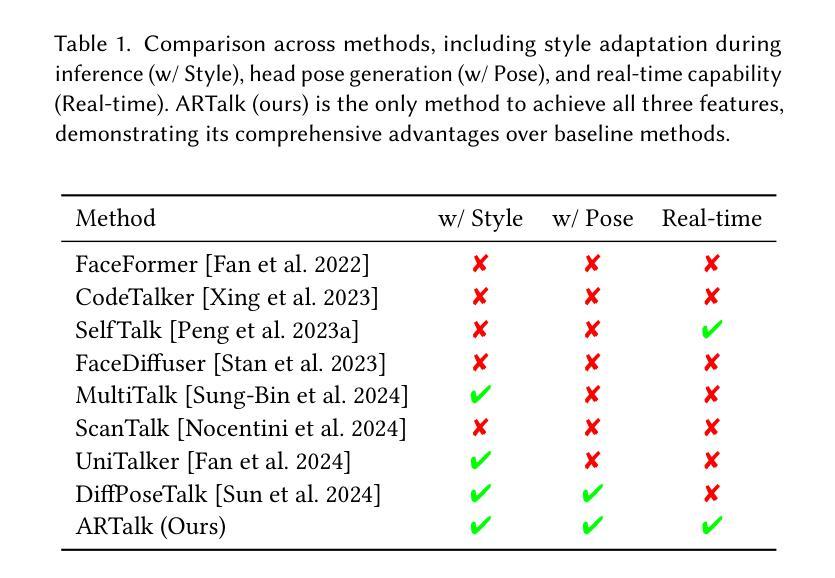

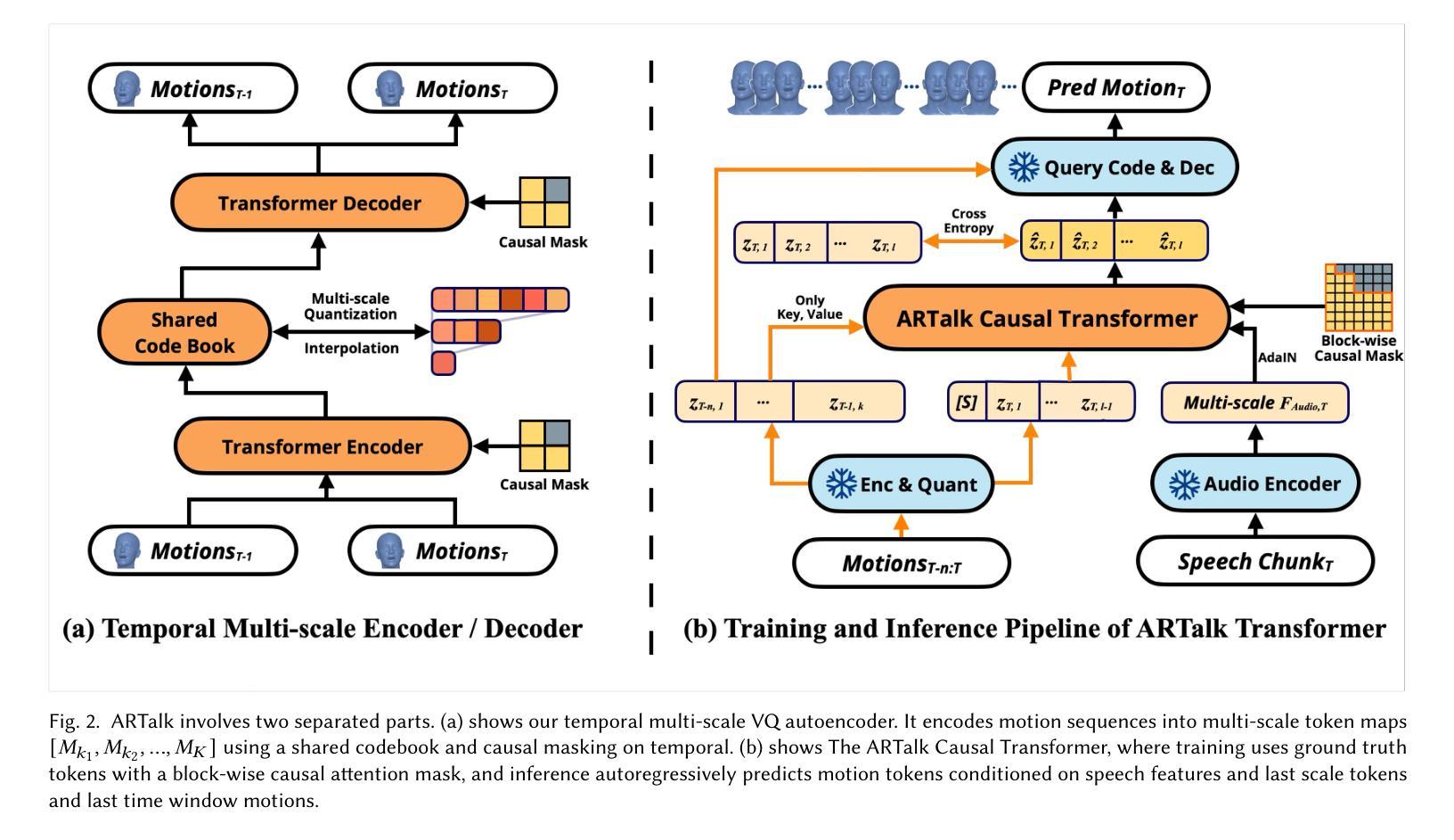

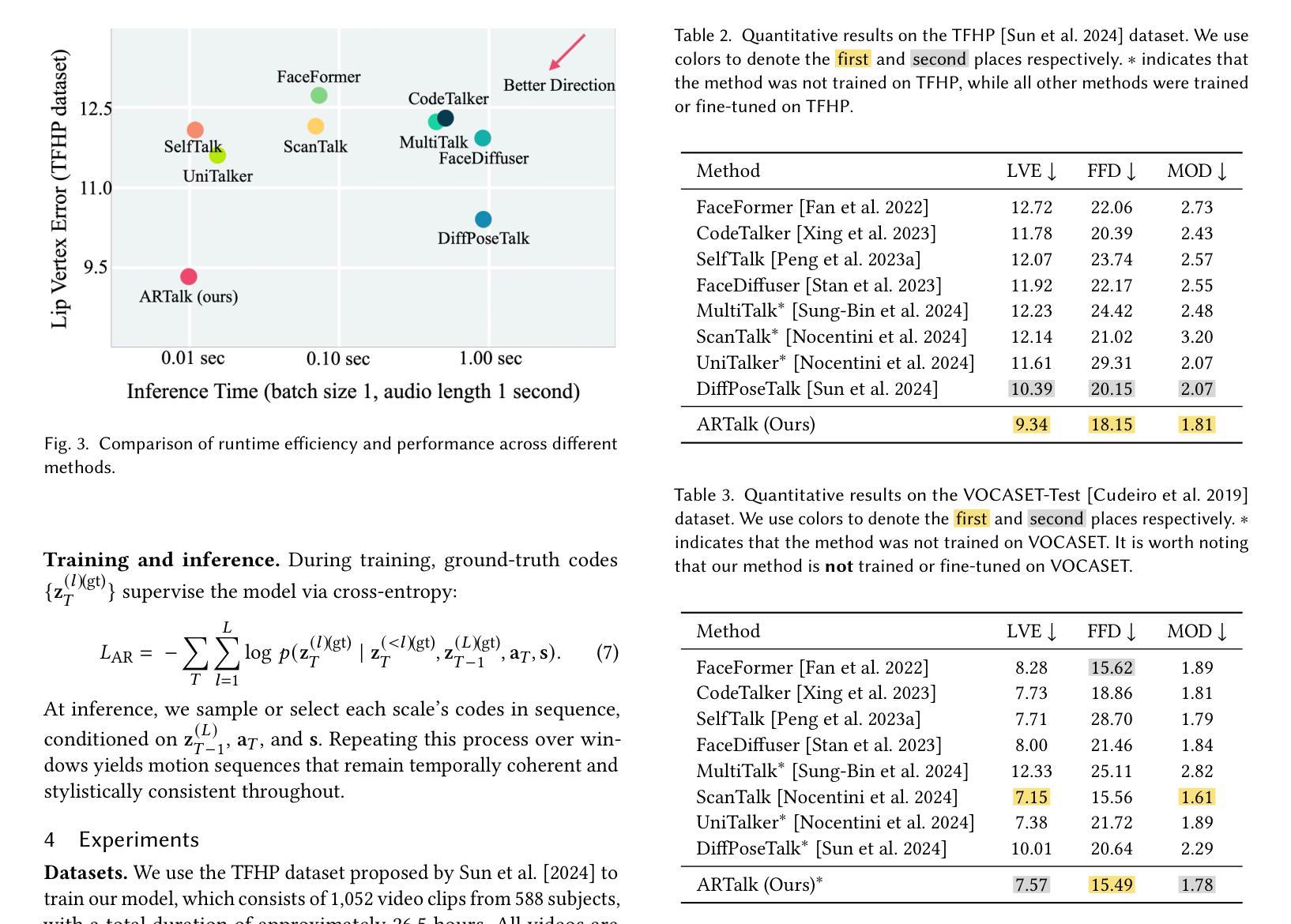

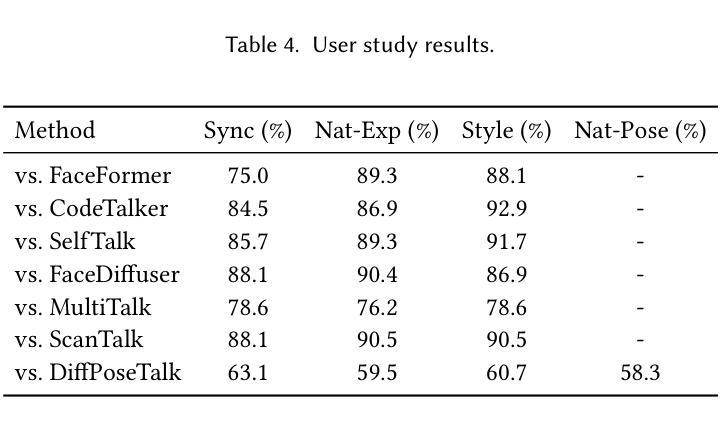

Speech-driven 3D facial animation aims to generate realistic lip movements and facial expressions for 3D head models from arbitrary audio clips. Although existing diffusion-based methods are capable of producing natural motions, their slow generation speed limits their application potential. In this paper, we introduce a novel autoregressive model that achieves real-time generation of highly synchronized lip movements and realistic head poses and eye blinks by learning a mapping from speech to a multi-scale motion codebook. Furthermore, our model can adapt to unseen speaking styles, enabling the creation of 3D talking avatars with unique personal styles beyond the identities seen during training. Extensive evaluations and user studies demonstrate that our method outperforms existing approaches in lip synchronization accuracy and perceived quality.

语音驱动的3D面部动画旨在从任意音频片段中为3D头部模型生成逼真的嘴唇动作和面部表情。尽管现有的基于扩散的方法能够产生自然运动,但其缓慢的生成速度限制了其应用潜力。在本文中,我们引入了一种新型自回归模型,通过学习从语音到多尺度运动字典的映射,实现高度同步的嘴唇运动、逼真的头部姿势和眨眼动作的实时生成。此外,我们的模型能够适应未见过的说话风格,使能够创建具有独特个人风格的3D聊天角色,而不仅仅是训练期间见过的身份。广泛评估和用户研究证明,我们的方法在嘴唇同步准确性和感知质量方面优于现有方法。

论文及项目相关链接

PDF More video demonstrations, code, models and data can be found on our project website: http://xg-chu.site/project_artalk/

Summary

语音驱动的3D面部动画技术通过音频生成逼真的唇部动作和面部表情。本文引入了一种新的自回归模型,可以实现从语音到多尺度运动代码库的映射,以实时生成高度同步的唇部动作和逼真的头部姿态以及眨眼动作。该方法可适应未见过的说话风格,并能创建超越训练期间所见身份的独特个性化三维动态头像。研究表明,该方法在唇同步准确性和感知质量方面优于现有方法。

Key Takeaways

- 论文介绍了一种新的自回归模型用于语音驱动的3D面部动画。

- 模型能够实现实时生成高度同步的唇部动作。

- 模型可以生成逼真的头部姿态和眨眼动作。

- 模型能够学习从语音到多尺度运动代码库的映射。

- 模型具有适应未见过的说话风格的能力。

- 该方法可以创建具有独特个人风格的3D动态头像。

点此查看论文截图