⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-07-15 更新

Image Translation with Kernel Prediction Networks for Semantic Segmentation

Authors:Cristina Mata, Michael S. Ryoo, Henrik Turbell

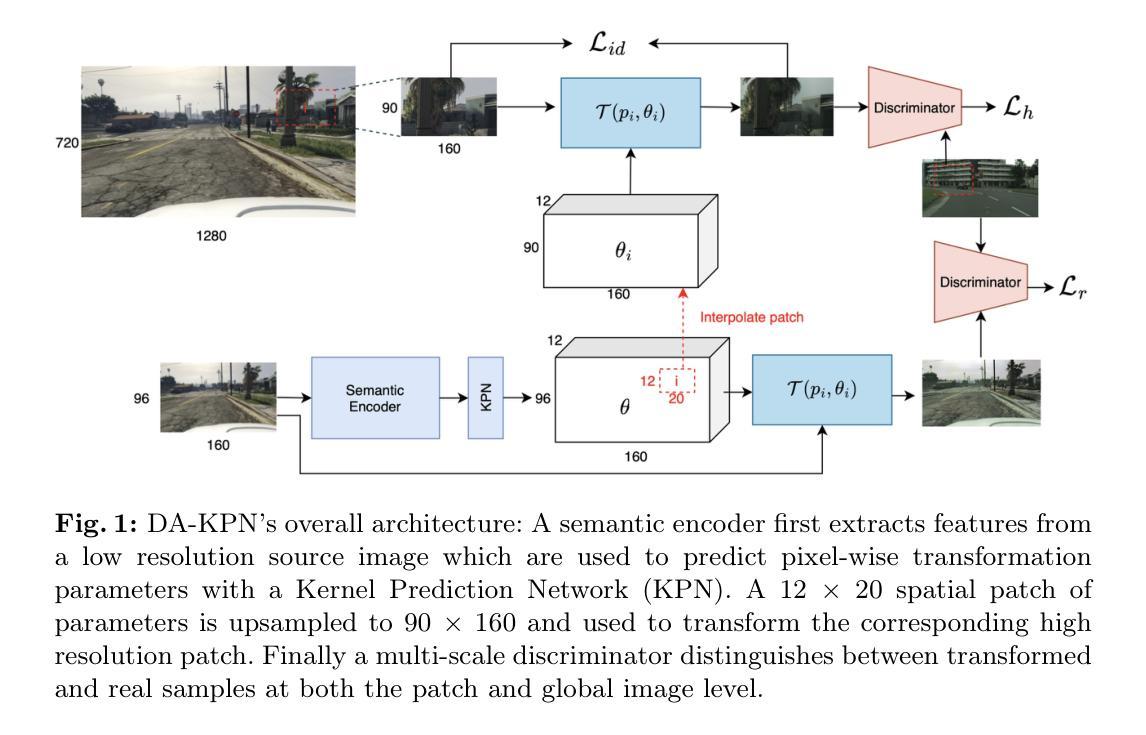

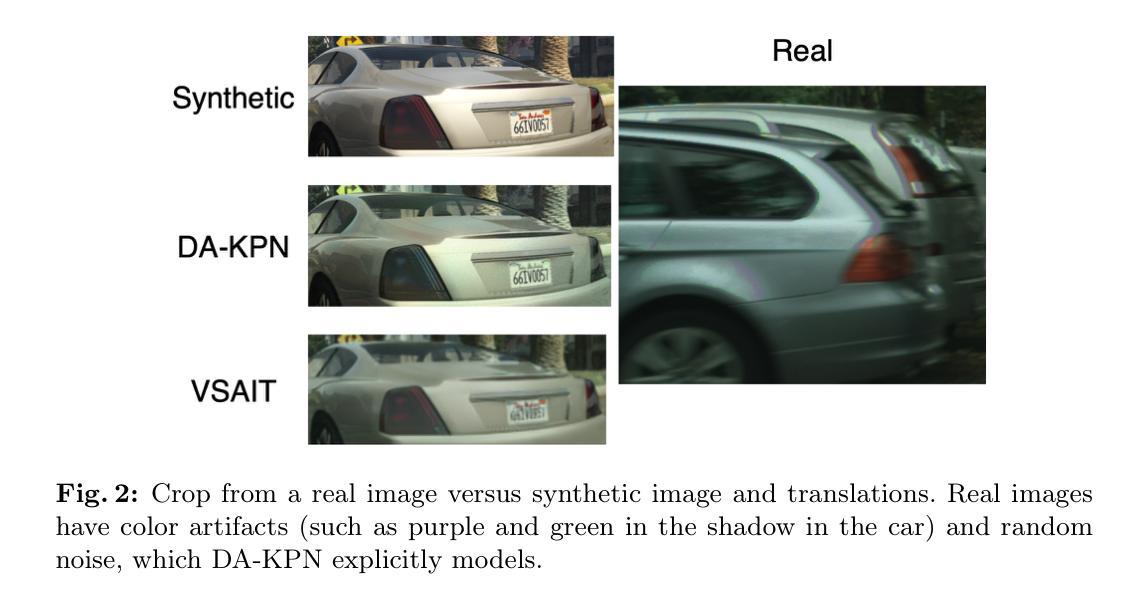

Semantic segmentation relies on many dense pixel-wise annotations to achieve the best performance, but owing to the difficulty of obtaining accurate annotations for real world data, practitioners train on large-scale synthetic datasets. Unpaired image translation is one method used to address the ensuing domain gap by generating more realistic training data in low-data regimes. Current methods for unpaired image translation train generative adversarial networks (GANs) to perform the translation and enforce pixel-level semantic matching through cycle consistency. These methods do not guarantee that the semantic matching holds, posing a problem for semantic segmentation where performance is sensitive to noisy pixel labels. We propose a novel image translation method, Domain Adversarial Kernel Prediction Network (DA-KPN), that guarantees semantic matching between the synthetic label and translation. DA-KPN estimates pixel-wise input transformation parameters of a lightweight and simple translation function. To ensure the pixel-wise transformation is realistic, DA-KPN uses multi-scale discriminators to distinguish between translated and target samples. We show DA-KPN outperforms previous GAN-based methods on syn2real benchmarks for semantic segmentation with limited access to real image labels and achieves comparable performance on face parsing.

语义分割依赖于大量的密集像素级标注来实现最佳性能,但由于现实世界数据获取精确标注的困难,实践者通常在大规模合成数据集上进行训练。无配对图像翻译是一种方法,通过生成低数据状态下的更现实的训练数据来解决由此产生的领域差距问题。当前的无配对图像翻译方法使用生成对抗网络(GANs)进行翻译,并通过循环一致性强制像素级别的语义匹配。这些方法并不能保证语义匹配的有效性,这对于对噪声像素标签敏感的语义分割来说是一个问题。我们提出了一种新的图像翻译方法,即领域对抗内核预测网络(DA-KPN),它保证了合成标签和翻译之间的语义匹配。DA-KPN估计轻量级简单翻译函数的像素级输入变换参数。为了确保像素级变换的真实性,DA-KPN使用多尺度鉴别器来区分翻译样本和目标样本。我们在有限的真实图像标签访问的语义分割syn2real基准测试上展示了DA-KPN优于先前的基于GAN的方法,并在面部解析上实现了相当的性能。

论文及项目相关链接

PDF OOD-CV Workshop at ECCV 2024

Summary

语义分割需要依赖大量的密集像素级标注才能达到最佳性能,但由于现实世界数据获取准确标注的困难,实践者通常在合成的大规模数据集上进行训练。无配对图像转换是一种利用生成对抗网络(GANs)进行翻译的方法,旨在解决因域差异导致的数据集不匹配问题,生成更真实的训练数据。我们提出了一种新型的图像翻译方法——域对抗性内核预测网络(DA-KPN),保证了合成标签和翻译之间的语义匹配。DA-KPN估计了简单翻译函数的像素级输入转换参数。为了确保像素级转换的真实性,DA-KPN使用多尺度鉴别器来区分翻译后的样本和目标样本。DA-KPN在有限的真实图像标签访问条件下,在语义分割的syn2real基准测试中表现出优于之前的基于GAN的方法,并在面部解析中实现了相当的性能。

Key Takeaways

- 语义分割需要密集像素级标注,但由于真实世界数据的标注难度,通常依赖合成的大规模数据集进行训练。

- 无配对图像转换是解决因域差异导致数据集不匹配的一种方法,使用GANs生成更真实的训练数据。

- 现有方法通过生成对抗网络(GANs)进行图像翻译,并强制像素级语义匹配,但语义匹配的保证缺失是个问题。

- 提出的Domain Adversarial Kernel Prediction Network (DA-KPN) 方法保证了合成标签和翻译之间的语义匹配。

- DA-KPN通过估计像素级的输入转换参数来实现翻译,使用轻量级且简单的翻译函数。

- DA-KPN利用多尺度鉴别器确保像素级转换的真实性。

点此查看论文截图