⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-08-09 更新

MOGO: Residual Quantized Hierarchical Causal Transformer for High-Quality and Real-Time 3D Human Motion Generation

Authors:Dongjie Fu, Tengjiao Sun, Pengcheng Fang, Xiaohao Cai, Hansung Kim

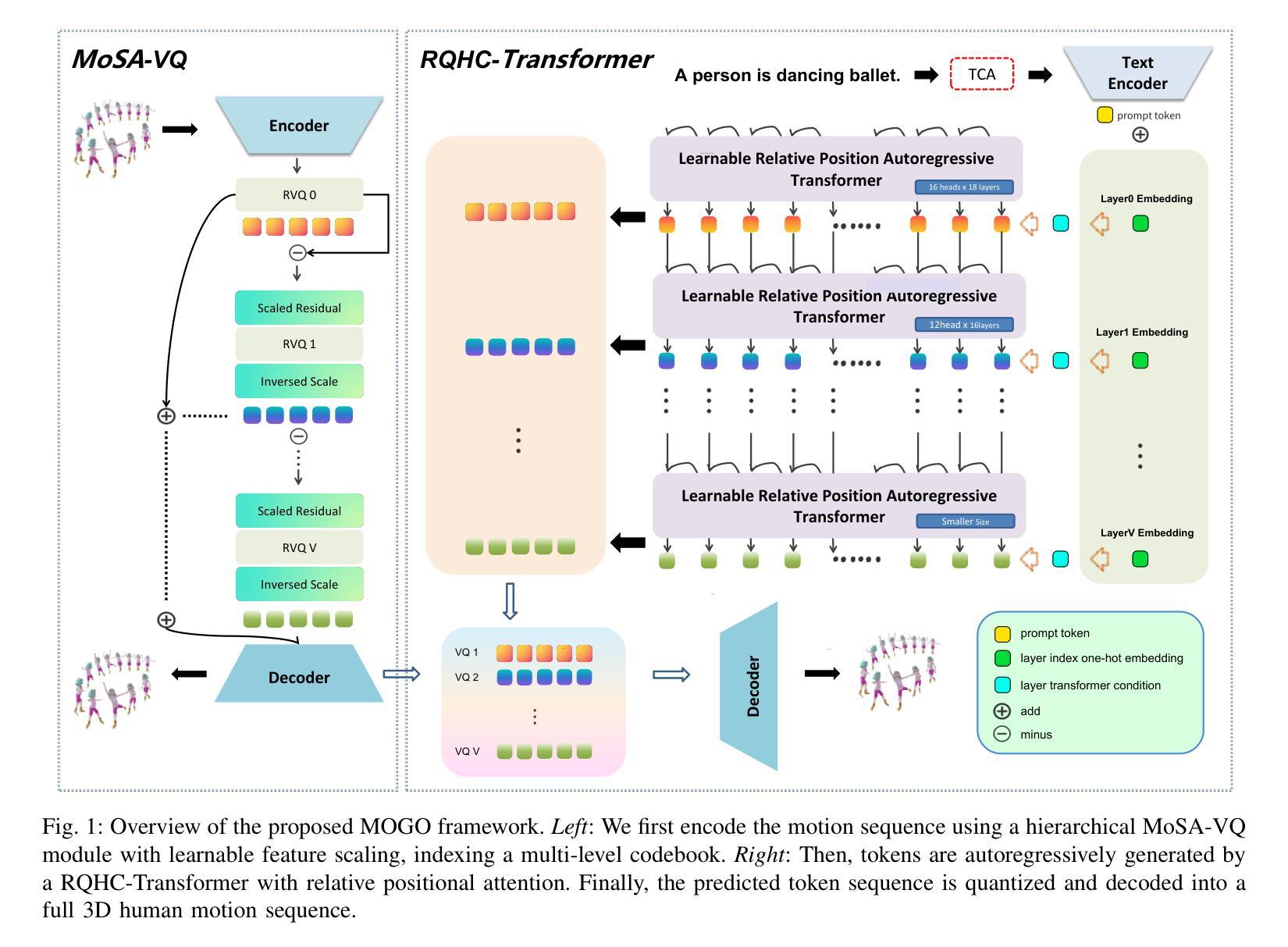

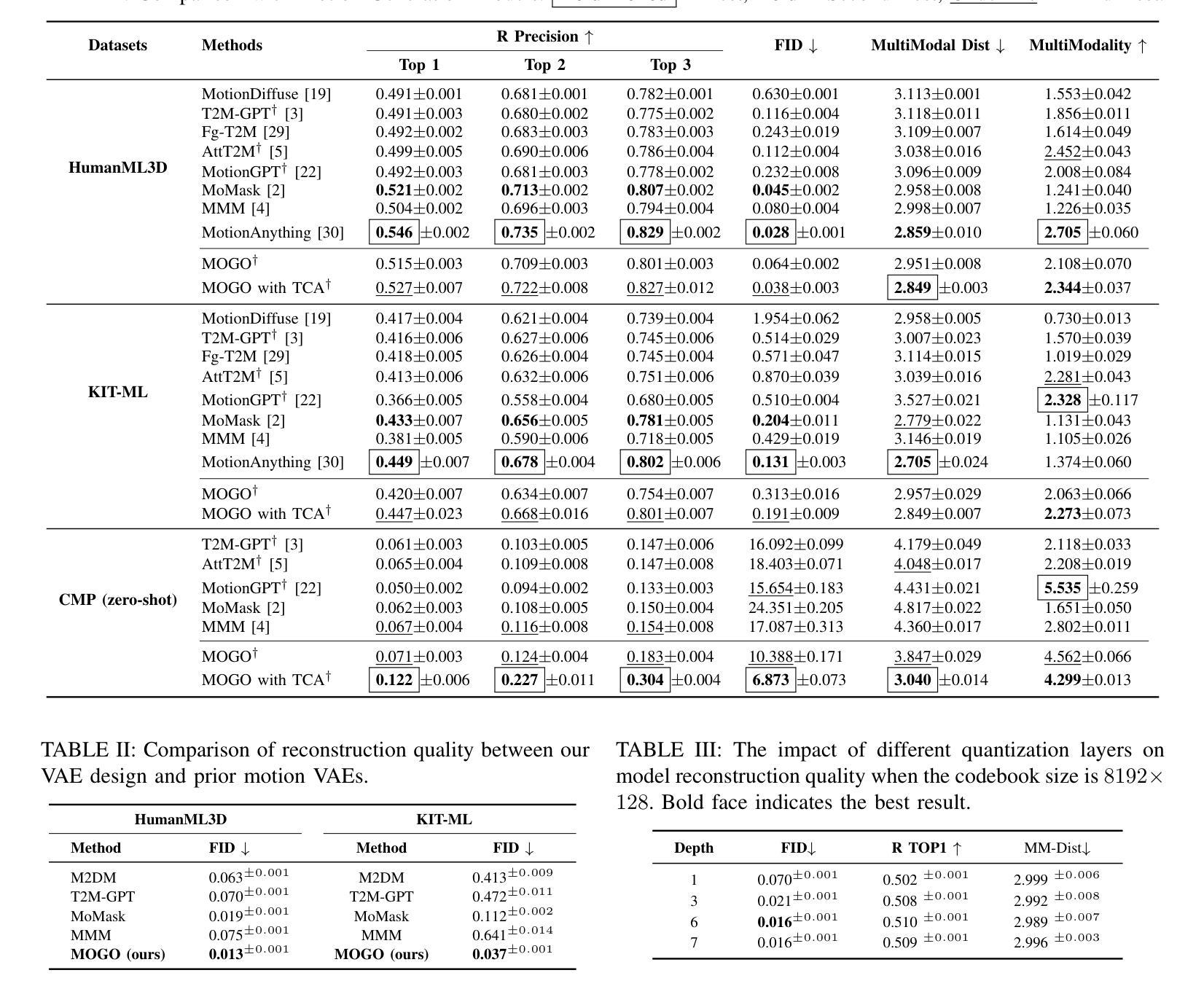

Recent advances in transformer-based text-to-motion generation have led to impressive progress in synthesizing high-quality human motion. Nevertheless, jointly achieving high fidelity, streaming capability, real-time responsiveness, and scalability remains a fundamental challenge. In this paper, we propose MOGO (Motion Generation with One-pass), a novel autoregressive framework tailored for efficient and real-time 3D motion generation. MOGO comprises two key components: (1) MoSA-VQ, a motion scale-adaptive residual vector quantization module that hierarchically discretizes motion sequences with learnable scaling to produce compact yet expressive representations; and (2) RQHC-Transformer, a residual quantized hierarchical causal transformer that generates multi-layer motion tokens in a single forward pass, significantly reducing inference latency. To enhance semantic fidelity, we further introduce a text condition alignment mechanism that improves motion decoding under textual control. Extensive experiments on benchmark datasets including HumanML3D, KIT-ML, and CMP demonstrate that MOGO achieves competitive or superior generation quality compared to state-of-the-art transformer-based methods, while offering substantial improvements in real-time performance, streaming generation, and generalization under zero-shot settings.

近期基于transformer的文本到运动生成技术的进展已经在合成高质量人类运动方面取得了令人印象深刻的进步。然而,同时实现高保真、流式传输能力、实时响应和可扩展性仍然是一个基本挑战。在本文中,我们提出了MOGO(一次运动生成),这是一个专为高效实时3D运动生成定制的自回归框架。MOGO包含两个关键组件:(1)MoSA-VQ,一种运动尺度自适应残差向量量化模块,它分层离散运动序列,通过可学习的缩放来产生紧凑而富有表现力的表示;(2)RQHC-Transformer,一种残差量化分层因果transformer,它在单次前向传递中产生多层运动令牌,大大降低了推理延迟。为了提高语义保真度,我们进一步引入了一种文本条件对齐机制,该机制改善了文本控制下的运动解码。在包括HumanML3D、KIT-ML和CMP在内的基准数据集上的广泛实验表明,MOGO与最新的基于transformer的方法相比,在生成质量方面达到了竞争或更优的水平,同时在实时性能、流式生成和零样本设置下的泛化能力方面提供了实质性的改进。

论文及项目相关链接

PDF 9 pages, 4 figures, conference

摘要

文本至动作生成领域的最新进展在合成高质量人类运动方面取得了显著成效。然而,如何同时实现高保真度、流式传输能力、实时响应性和可扩展性仍是基本挑战。本文提出MOGO(一次性动作生成),一种专为高效实时三维动作生成设计的自回归框架。MOGO包含两个关键组件:(1)MoSA-VQ,一种运动规模自适应残差向量量化模块,可分层离散运动序列并进行可学习缩放,以产生紧凑而富有表现力的表示;(2)RQHC-Transformer,一种残差量化分层因果变压器,可在单次前向传递中产生多层运动令牌,大大降低了推理延迟。为提高语义保真度,我们还引入了文本条件对齐机制,改进了文本控制下的动作解码。在HumanML3D、KIT-ML和CMP等基准数据集上的广泛实验表明,MOGO在生成质量方面与最新的基于转换器的方法相比具有竞争力或更优越,同时在实时性能、流式生成和零样本设置下的泛化能力方面实现了实质性改进。

关键见解

- 最近基于转换器的文本至动作生成领域的进展已经取得了令人印象深刻的成果。

- 同时实现高保真度、流式传输能力、实时响应性和可扩展性是该领域的基本挑战。

- MOGO框架包括两个关键组件:MoSA-VQ和RQHC-Transformer,分别用于产生紧凑而富有表现力的运动表示和降低推理延迟。

- MOGO通过引入文本条件对齐机制提高了语义保真度,改进了文本控制下的动作解码。

- 在多个基准数据集上的实验表明,MOGO在生成质量方面与最新方法相比具有竞争力,并且在实时性能、流式生成和泛化能力方面有明显改进。

- MOGO框架具有潜力解决当前文本至动作生成领域面临的挑战。

点此查看论文截图