⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-08-14 更新

Identity-Preserving Aging and De-Aging of Faces in the StyleGAN Latent Space

Authors:Luis S. Luevano, Pavel Korshunov, Sebastien Marcel

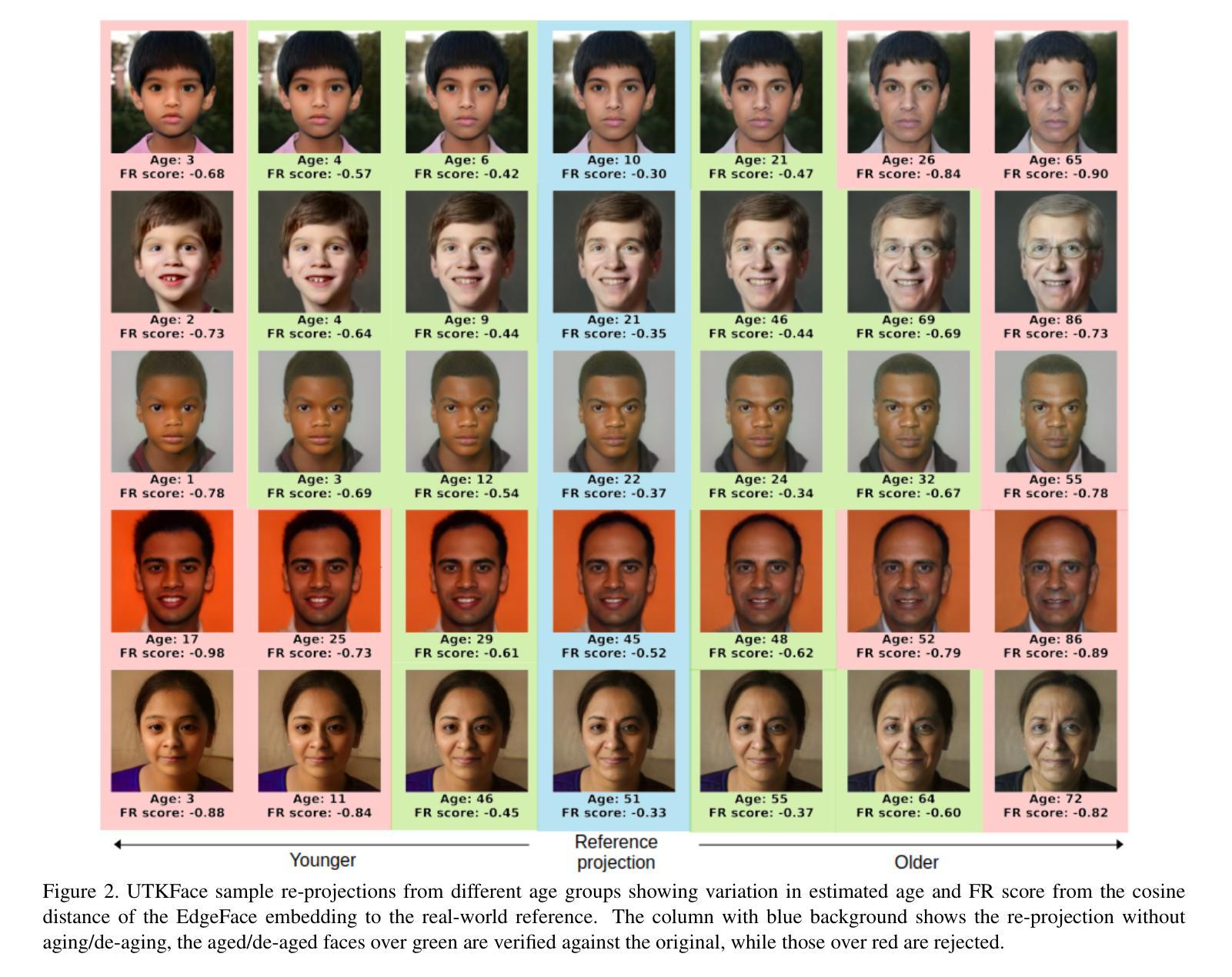

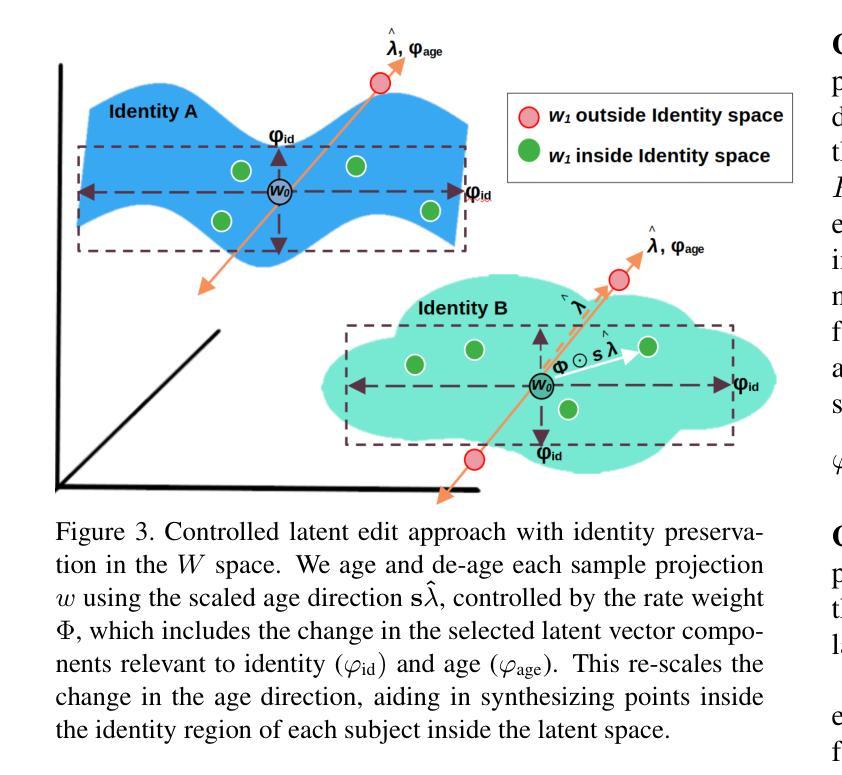

Face aging or de-aging with generative AI has gained significant attention for its applications in such fields like forensics, security, and media. However, most state of the art methods rely on conditional Generative Adversarial Networks (GANs), Diffusion-based models, or Visual Language Models (VLMs) to age or de-age faces based on predefined age categories and conditioning via loss functions, fine-tuning, or text prompts. The reliance on such conditioning leads to complex training requirements, increased data needs, and challenges in generating consistent results. Additionally, identity preservation is rarely taken into accountor evaluated on a single face recognition system without any control or guarantees on whether identity would be preserved in a generated aged/de-aged face. In this paper, we propose to synthesize aged and de-aged faces via editing latent space of StyleGAN2 using a simple support vector modeling of aging/de-aging direction and several feature selection approaches. By using two state-of-the-art face recognition systems, we empirically find the identity preserving subspace within the StyleGAN2 latent space, so that an apparent age of a given face can changed while preserving the identity. We then propose a simple yet practical formula for estimating the limits on aging/de-aging parameters that ensures identity preservation for a given input face. Using our method and estimated parameters we have generated a public dataset of synthetic faces at different ages that can be used for benchmarking cross-age face recognition, age assurance systems, or systems for detection of synthetic images. Our code and dataset are available at the project page https://www.idiap.ch/paper/agesynth/

面部衰老或年轻化通过生成式人工智能得到了广泛关注,并广泛应用于法医学、安全和媒体等领域。然而,大多数先进的方法依赖于条件生成对抗网络(GANs)、扩散模型或视觉语言模型(VLMs)来根据预定义的年龄类别和通过损失函数、微调或文本提示进行条件设置,从而实现面部的衰老或年轻化。对这些条件的依赖导致了复杂的训练要求、增加的数据需求,以及在生成一致结果方面的挑战。此外,身份保持很少被考虑或评估,并且在没有控制或保证生成的衰老或年轻化面孔中身份是否会被保留的情况下,单一面部识别系统很难对其进行评价。在本文中,我们提出通过编辑StyleGAN2的潜在空间来合成衰老和年轻化的面孔,采用简单的支持向量模型来表示衰老或年轻化的方向,并采用了几种特征选择方法。我们通过两个最先进的面部识别系统实证地找到了StyleGAN2潜在空间中的身份保持子空间,从而能够在保持身份的同时改变给定面部的表观年龄。然后,我们提出了一个简单实用的公式来估计衰老或年轻化参数的极限,以确保给定输入面部的身份得到保留。使用我们的方法和估计的参数,我们生成了一个公开的面部分布在不同年龄的合成数据集,可用于评估跨年龄面部识别、年龄验证系统或检测合成图像的系统。我们的代码和数据集可在项目页面https://www.idiap.ch/paper/agesynth/获取。

论文及项目相关链接

PDF Accepted for publication in IEEE International Joint Conference on Biometrics (IJCB), 2025

摘要

本文提出通过编辑StyleGAN2的潜在空间合成衰老和年轻化的面孔,采用衰老/年轻化方向的支撑向量建模和多种特征选择方法。在StyleGAN2的潜在空间内找到身份保留的子空间,改变给定面孔的表观年龄同时保留身份。文章还提出了一个简单实用的公式,用于估算衰老/年轻化参数的极限,以确保对给定输入面孔的身份保留。

关键见解

- 提出通过编辑StyleGAN2的潜在空间合成衰老和年轻化的面孔。

- 使用支撑向量建模和特征选择方法来模拟衰老和年轻化的方向。

- 实证找到StyleGAN2潜在空间内的身份保留子空间,在改变年龄的同时保留身份特征。

- 提出一个估算衰老/年轻化参数极限的实用公式,以确保身份保留。

- 生成了一个公开数据集,包含不同年龄段的面孔合成图像,可用于跨年龄人脸识别、年龄验证系统或检测合成图像的系统。

- 方法和数据集均可在项目页面获取。

- 该研究在面部老化或年轻化方面具有广泛的应用前景,如法医学、安全、媒体等领域。

点此查看论文截图

PC-SRGAN: Physically Consistent Super-Resolution Generative Adversarial Network for General Transient Simulations

Authors:Md Rakibul Hasan, Pouria Behnoudfar, Dan MacKinlay, Thomas Poulet

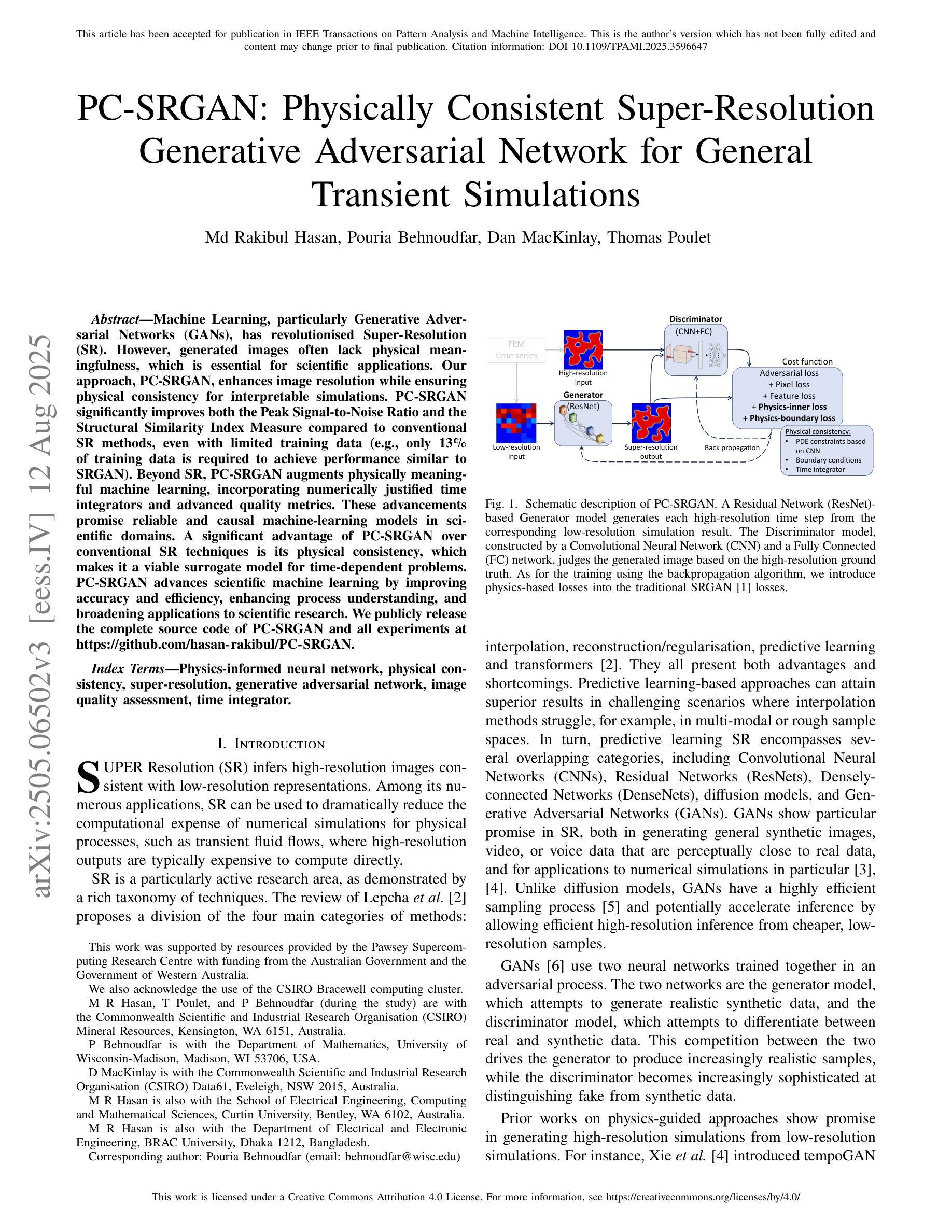

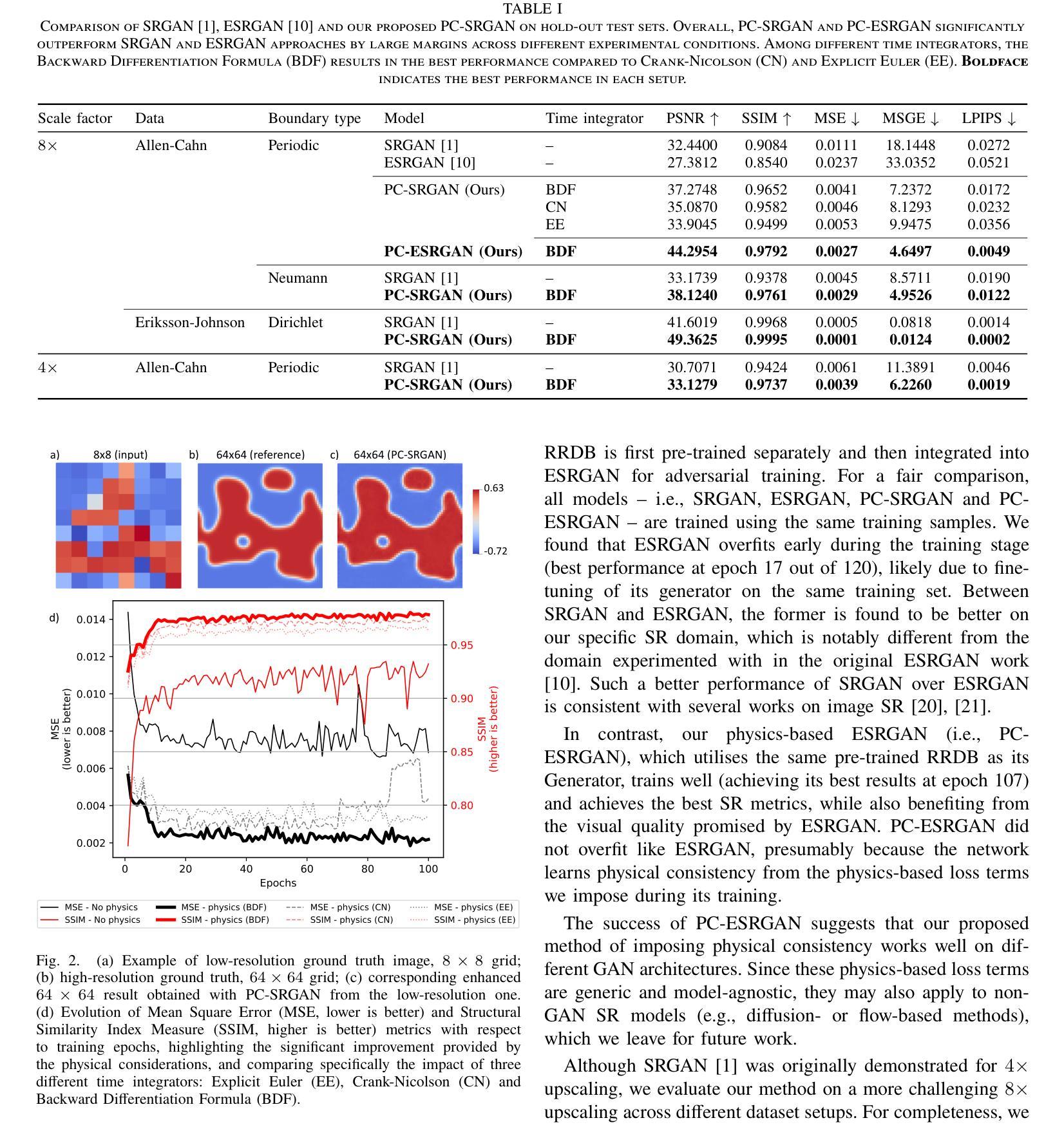

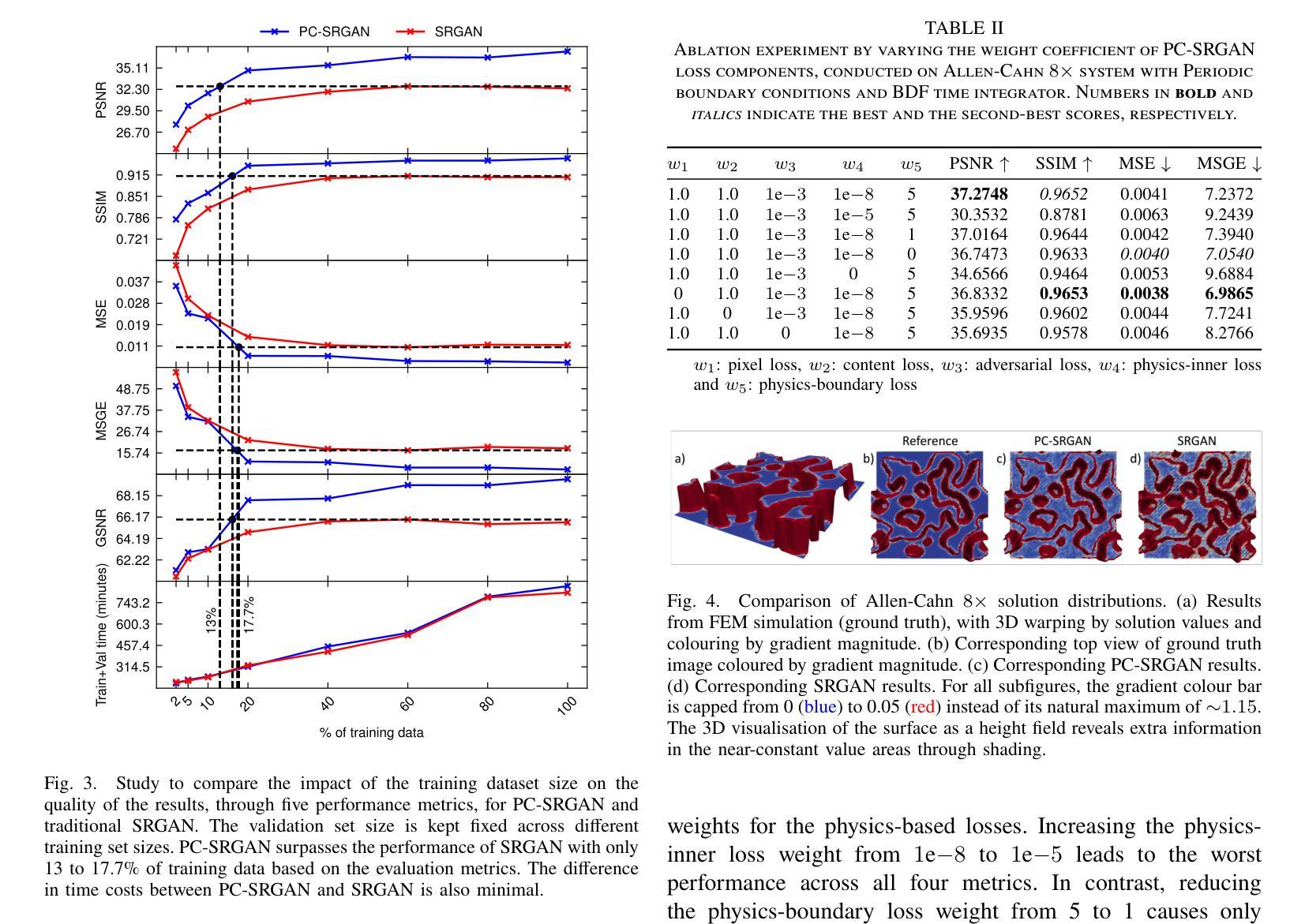

Machine Learning, particularly Generative Adversarial Networks (GANs), has revolutionised Super-Resolution (SR). However, generated images often lack physical meaningfulness, which is essential for scientific applications. Our approach, PC-SRGAN, enhances image resolution while ensuring physical consistency for interpretable simulations. PC-SRGAN significantly improves both the Peak Signal-to-Noise Ratio and the Structural Similarity Index Measure compared to conventional SR methods, even with limited training data (e.g., only 13% of training data is required to achieve performance similar to SRGAN). Beyond SR, PC-SRGAN augments physically meaningful machine learning, incorporating numerically justified time integrators and advanced quality metrics. These advancements promise reliable and causal machine-learning models in scientific domains. A significant advantage of PC-SRGAN over conventional SR techniques is its physical consistency, which makes it a viable surrogate model for time-dependent problems. PC-SRGAN advances scientific machine learning by improving accuracy and efficiency, enhancing process understanding, and broadening applications to scientific research. We publicly release the complete source code of PC-SRGAN and all experiments at https://github.com/hasan-rakibul/PC-SRGAN.

机器学习,特别是生成对抗网络(GANs),已经对超分辨率(SR)技术进行了革命性的改进。然而,生成的图像通常缺乏物理意义,这对于科学应用至关重要。我们的PC-SRGAN方法在提高图像分辨率的同时,确保了物理一致性,为可解释的模拟提供了可能。与传统的SR方法相比,PC-SRGAN在峰值信噪比(Peak Signal-to-Noise Ratio)和结构相似性指数度量(Structural Similarity Index Measure)方面有了显著的提高。即使在训练数据有限的情况下(例如,仅需要13%的训练数据即可达到与SRGAN相似的性能)。除了SR,PC-SRGAN还增强了具有物理意义的机器学习,结合了数值验证的时间积分器和高级质量指标。这些进步有望在科学领域建立可靠且因果关系的机器学习模型。PC-SRGAN相对于传统SR技术的显著优势在于其物理一致性,使其成为时间依赖问题的可行替代模型。PC-SRGAN通过提高准确性和效率、增强过程理解并拓宽科学研究的应用来推动科学机器学习的发展。我们在https://github.com/hasan-rakibul/PC-SRGAN公开发布了PC-SRGAN的完整源代码和所有实验。

论文及项目相关链接

PDF 11 pages, combining the main content and the appendices, unlike having them separated in the published version at IEEE Xplore (https://doi.org/10.1109/TPAMI.2025.3596647)

Summary

PC-SRGAN是一种结合了生成对抗网络(GANs)思想的超分辨率技术,能够在提高图像分辨率的同时保证物理一致性,对于科学模拟与仿真意义重大。该技术提升了峰值信噪比(PSNR)和结构相似性指标(SSIM),相比传统超分辨率方法优势明显,即使在训练数据量有限的情况下也能表现出良好性能。除了用于超分辨率,PC-SRGAN还能促进物理意义上具有意义的机器学习,通过引入数值验证的时间积分器和高级质量指标,推动科学领域机器学习模型的可靠性和因果性。其物理一致性使其成为解决时间依赖问题的有效替代模型。总体而言,PC-SRGAN通过提高准确性和效率、增强过程理解以及拓宽科学应用范围推动了科学机器学习的进步。其源代码和实验数据已公开发布。

Key Takeaways

- PC-SRGAN结合了生成对抗网络(GANs)技术用于提高图像分辨率,同时保证了物理一致性。

- PC-SRGAN在峰值信噪比(PSNR)和结构相似性指标(SSIM)上表现优异,相比传统超分辨率方法优势明显。

- PC-SRGAN能在训练数据量有限的情况下实现良好性能,仅需要13%的训练数据就能达到与SRGAN相似的性能。

- PC-SRGAN促进了物理意义上具有意义的机器学习,通过引入数值验证的时间积分器和高级质量指标推动了科学领域机器学习模型的进步。

- PC-SRGAN的物理一致性使其成为解决时间依赖问题的有效替代模型。

- PC-SRGAN的源代码和实验数据已经公开发布,便于研究人员使用和改进。

点此查看论文截图