⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-08-14 更新

RealisMotion: Decomposed Human Motion Control and Video Generation in the World Space

Authors:Jingyun Liang, Jingkai Zhou, Shikai Li, Chenjie Cao, Lei Sun, Yichen Qian, Weihua Chen, Fan Wang

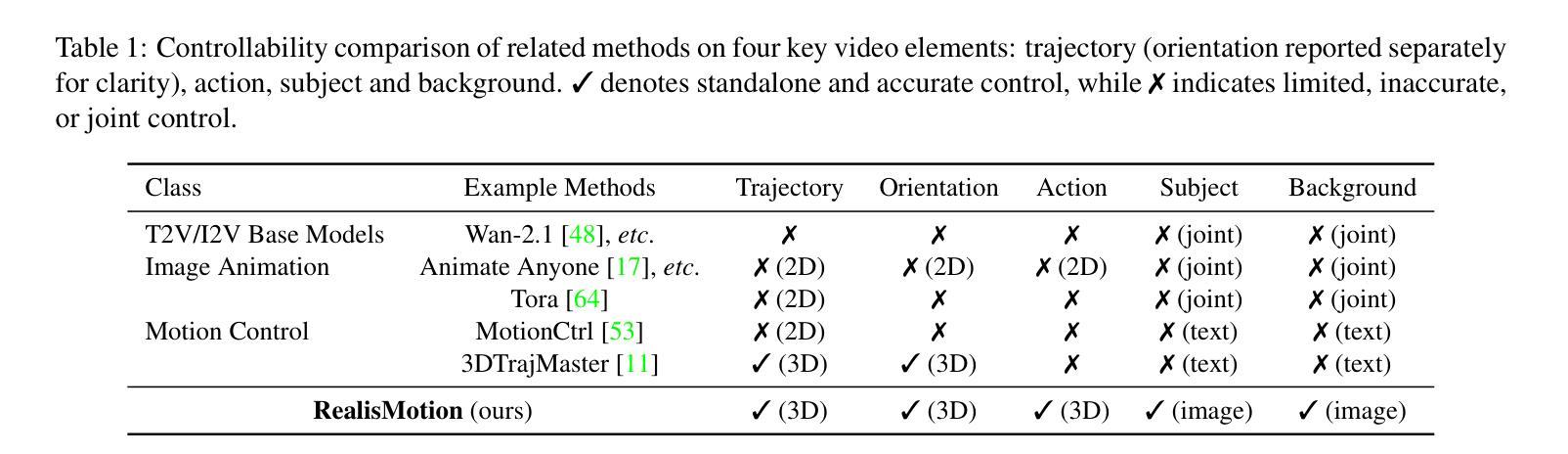

Generating human videos with realistic and controllable motions is a challenging task. While existing methods can generate visually compelling videos, they lack separate control over four key video elements: foreground subject, background video, human trajectory and action patterns. In this paper, we propose a decomposed human motion control and video generation framework that explicitly decouples motion from appearance, subject from background, and action from trajectory, enabling flexible mix-and-match composition of these elements. Concretely, we first build a ground-aware 3D world coordinate system and perform motion editing directly in the 3D space. Trajectory control is implemented by unprojecting edited 2D trajectories into 3D with focal-length calibration and coordinate transformation, followed by speed alignment and orientation adjustment; actions are supplied by a motion bank or generated via text-to-motion methods. Then, based on modern text-to-video diffusion transformer models, we inject the subject as tokens for full attention, concatenate the background along the channel dimension, and add motion (trajectory and action) control signals by addition. Such a design opens up the possibility for us to generate realistic videos of anyone doing anything anywhere. Extensive experiments on benchmark datasets and real-world cases demonstrate that our method achieves state-of-the-art performance on both element-wise controllability and overall video quality.

生成具有真实感和可控动作的人类视频是一项具有挑战性的任务。尽管现有方法可以生成视觉上引人注目的视频,但它们无法对四个关键视频元素进行单独控制:前景主体、背景视频、人类轨迹和动作模式。在本文中,我们提出了一个分解的人类运动控制和视频生成框架,该框架显式地将运动与外观、主体与背景、动作与轨迹分开,从而实现这些元素的灵活混合和匹配。具体地,我们首先建立一个地面感知的3D世界坐标系,并在3D空间中进行直接运动编辑。轨迹控制是通过将编辑的2D轨迹反投影到3D空间实现的,这涉及到焦距校准和坐标变换,接着进行速度调整和方向调整;动作则由动作库提供或通过文本到运动的方法生成。然后,基于现代文本到视频的扩散变换模型,我们将主体作为令牌进行全注意力注入,沿通道维度连接背景,并通过加法添加运动(轨迹和动作)控制信号。这样的设计为我们生成任何人、任何地方、执行任何动作的逼真视频提供了可能。在基准数据集和真实案例上的大量实验表明,我们的方法在元素级可控性和总体视频质量上都达到了最先进的性能。

论文及项目相关链接

PDF Project page: https://jingyunliang.github.io/RealisMotion

Summary

该文提出了一种分解人类运动控制与视频生成框架,能够明确地将运动与外观、主体与背景、动作与轨迹分离。通过构建地面感知的3D世界坐标系,直接在3D空间进行运动编辑。利用现代文本到视频扩散变压器模型,注入主体标记,结合背景通道维度,通过添加运动(轨迹和动作)控制信号,实现灵活组合各元素。实验证明,该方法在元素可控性和整体视频质量上均达到最佳性能。

Key Takeaways

- 现有方法难以单独控制视频中的四个关键元素:前景主体、背景视频、人类轨迹和动作模式。

- 提出了一个分解人类运动控制与视频生成框架,明确地将运动与外观、主体与背景、动作与轨迹分离。

- 通过构建地面感知的3D世界坐标系,直接在3D空间进行运动编辑。

- 实现了轨迹控制通过2D轨迹编辑并转化为3D轨迹,包含焦点距离校准和坐标变换,以及速度和方向调整。

- 动作可通过运动库提供或通过文本到运动方法生成。

- 基于现代文本到视频扩散变压器模型,将主体、背景和动作元素结合,注入运动控制信号。

点此查看论文截图