⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-08-15 更新

Hybrid Generative Fusion for Efficient and Privacy-Preserving Face Recognition Dataset Generation

Authors:Feiran Li, Qianqian Xu, Shilong Bao, Boyu Han, Zhiyong Yang, Qingming Huang

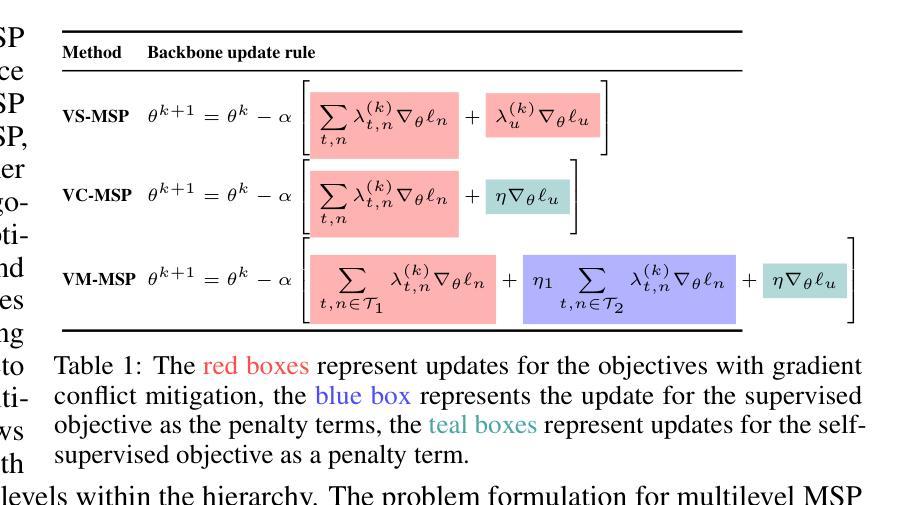

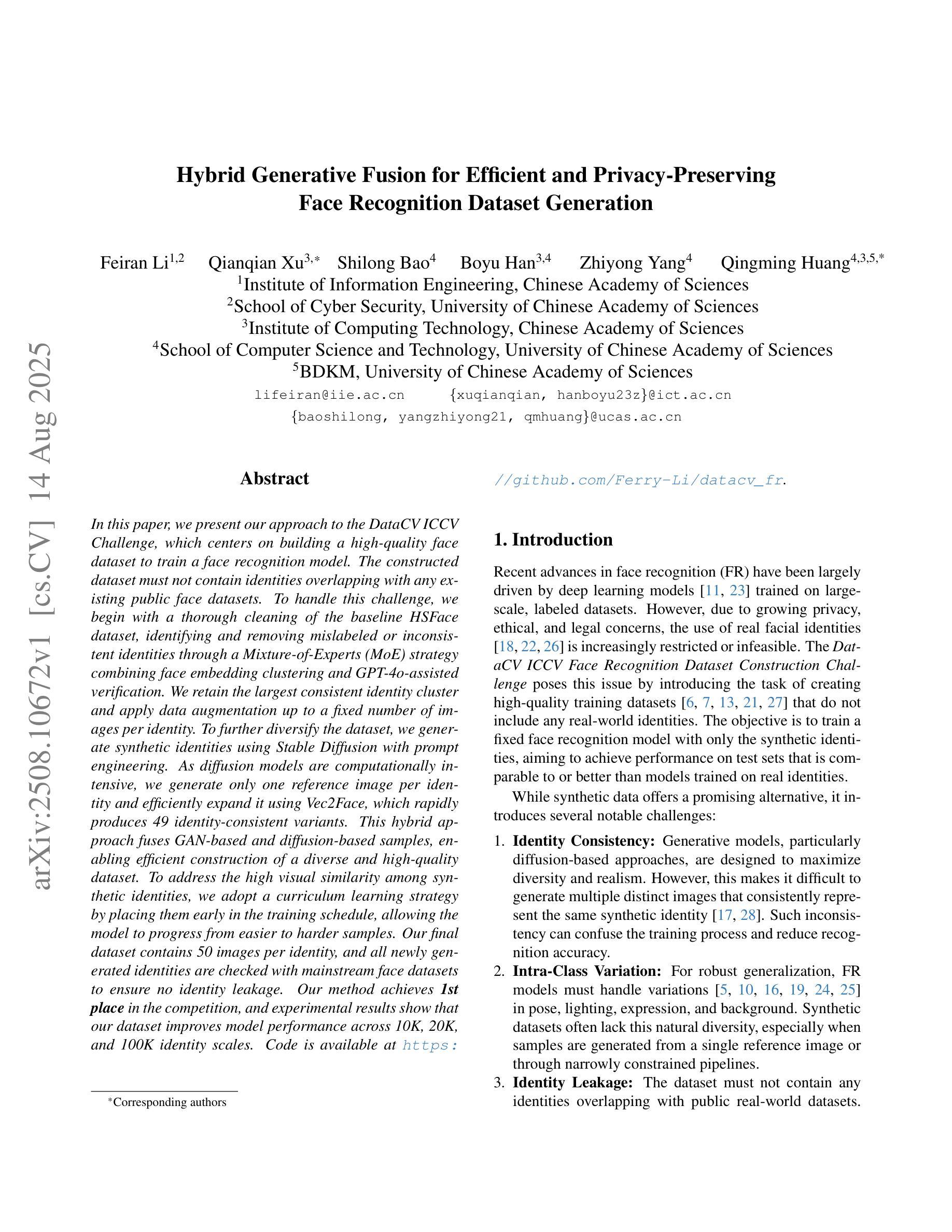

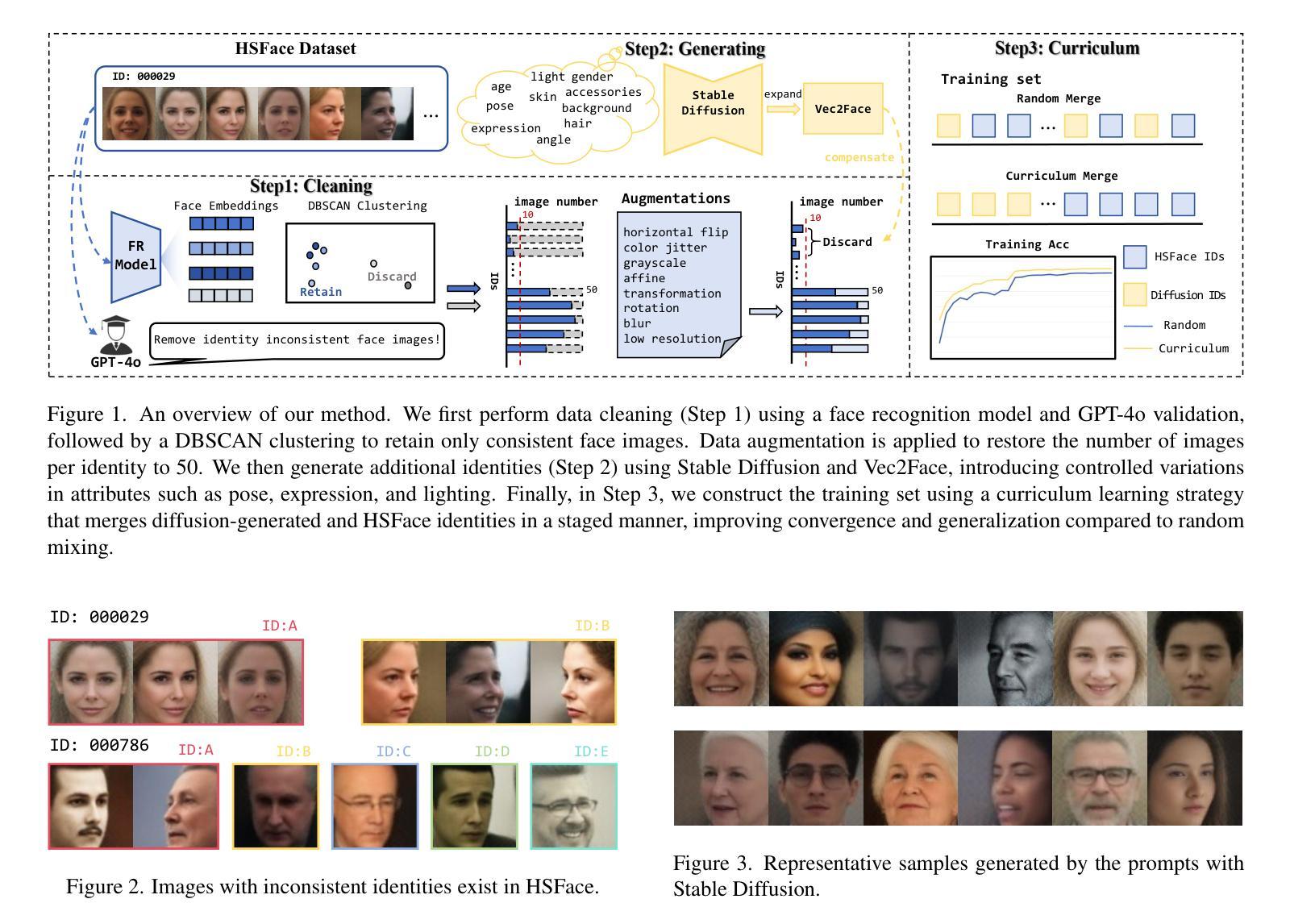

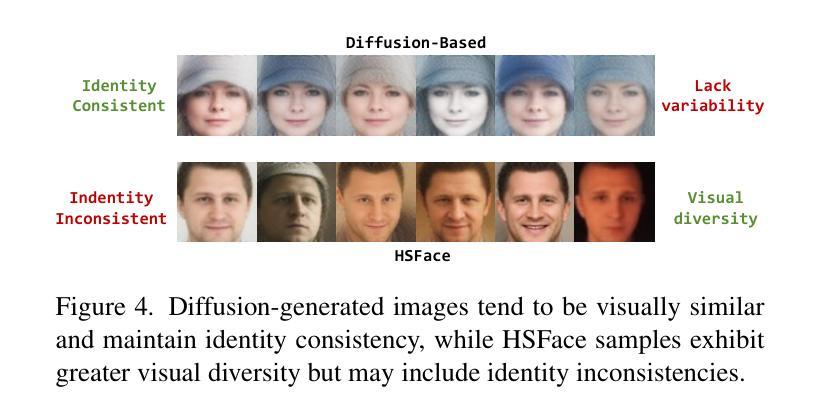

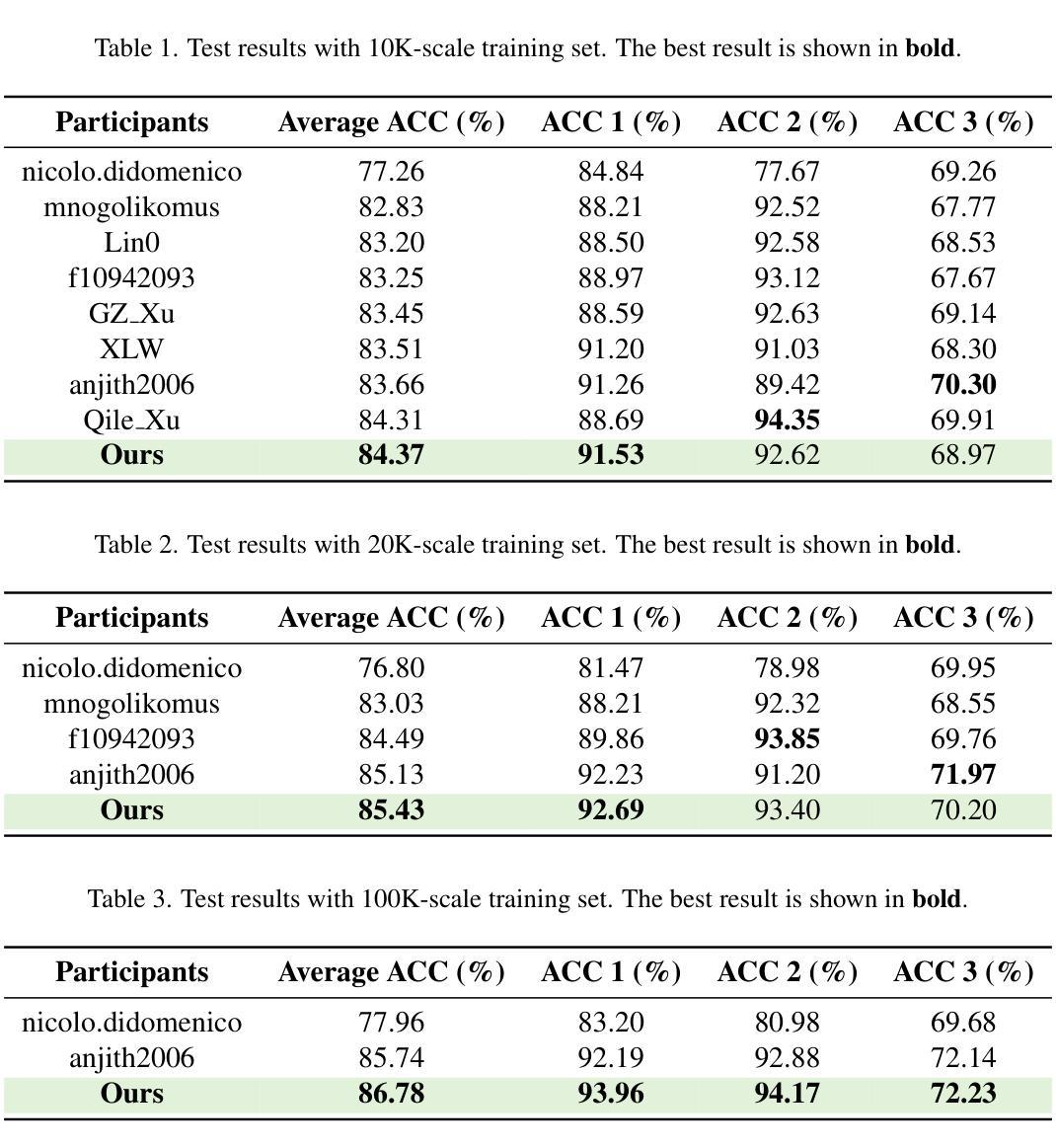

In this paper, we present our approach to the DataCV ICCV Challenge, which centers on building a high-quality face dataset to train a face recognition model. The constructed dataset must not contain identities overlapping with any existing public face datasets. To handle this challenge, we begin with a thorough cleaning of the baseline HSFace dataset, identifying and removing mislabeled or inconsistent identities through a Mixture-of-Experts (MoE) strategy combining face embedding clustering and GPT-4o-assisted verification. We retain the largest consistent identity cluster and apply data augmentation up to a fixed number of images per identity. To further diversify the dataset, we generate synthetic identities using Stable Diffusion with prompt engineering. As diffusion models are computationally intensive, we generate only one reference image per identity and efficiently expand it using Vec2Face, which rapidly produces 49 identity-consistent variants. This hybrid approach fuses GAN-based and diffusion-based samples, enabling efficient construction of a diverse and high-quality dataset. To address the high visual similarity among synthetic identities, we adopt a curriculum learning strategy by placing them early in the training schedule, allowing the model to progress from easier to harder samples. Our final dataset contains 50 images per identity, and all newly generated identities are checked with mainstream face datasets to ensure no identity leakage. Our method achieves \textbf{1st place} in the competition, and experimental results show that our dataset improves model performance across 10K, 20K, and 100K identity scales. Code is available at https://github.com/Ferry-Li/datacv_fr.

本文中,我们介绍了针对DataCV ICCV挑战的解决方案,该方案的重点是构建高质量的人脸数据集以训练人脸识别模型。构建的数集必须不包含与任何现有公共人脸数据集重叠的身份。为了应对这一挑战,我们首先彻底清理了基准HSFace数据集,通过结合人脸嵌入聚类和GPT-4o辅助验证的Mixed-Expert(MoE)策略,识别并移除了误标记或身份不一致的数据。我们保留最大的连续身份集群,并对每个身份的图像进行最多数据增强至固定数量。为了多样化数据集,我们使用Stable Diffusion通过提示工程生成合成身份。由于扩散模型计算量大,我们每个身份只生成一个参考图像,并使用Vec2Face进行有效扩展,迅速生成49个身份一致的变体。这种混合方法融合了基于GAN和基于扩散的样本,能够高效地构建多样且高质量的数据集。为了解决合成身份之间的高视觉相似性,我们采用了一种课程学习策略,将它们尽早纳入训练计划,使模型能够从简单的样本过渡到复杂的样本。我们的最终数据集每个身份包含50张图像,所有新生成的身份都与主流人脸数据集进行了检查,以确保没有身份泄露。我们的方法在比赛中获得第一名,实验结果表明,我们的数据集在10K、20K和100K身份规模上均提高了模型性能。代码可在https://github.com/Ferry-Li/datacv_fr中找到。

论文及项目相关链接

PDF This paper has been accpeted to ICCV 2025 DataCV Workshop

摘要

该论文旨在解决DataCV ICCV挑战赛中的数据构建问题,重点在于创建一个高质量的人脸数据集以训练人脸识别模型。通过彻底清理基准HSFace数据集,采用混合专家策略结合人脸嵌入聚类和GPT-4o辅助验证来识别和移除错误标记或不一致的身份。保留最大的连续身份集群,并对每个身份进行数据增强,以达到固定数量的图像。为多样化数据集,使用Stable Diffusion进行身份提示工程生成合成身份。由于扩散模型计算量大,只为每个身份生成一个参考图像,然后使用Vec2Face有效扩展,迅速产生49个身份一致的变体。这种融合GAN和扩散样本的混合方法能高效构建多样且高质量的数据集。针对合成身份之间的高视觉相似性,采用课程学习策略,将其置于训练日程的早期,使模型从简单样本过渡到复杂样本。最终数据集包含每个身份的50张图像,所有新生成的身份都在主流人脸数据集中进行了检查,以确保没有身份泄露。该方法在比赛中获得第一名,实验结果表明,该数据集在10K、20K和100K身份规模上均提高了模型性能。

关键见解

- 论文针对DataCV ICCV挑战赛,专注于创建高质量的人脸数据集以训练人脸识别模型。

- 通过混合专家策略彻底清理HSFace数据集,识别和移除错误标记或不一致的身份。

- 采用数据增强和Stable Diffusion生成合成身份来丰富数据集多样性。

- 使用Vec2Face快速产生多个身份一致的变体,以提高数据集的效率。

- 融合GAN和扩散样本的混合方法创建数据集。

- 采用课程学习策略处理合成身份的高视觉相似性。

点此查看论文截图

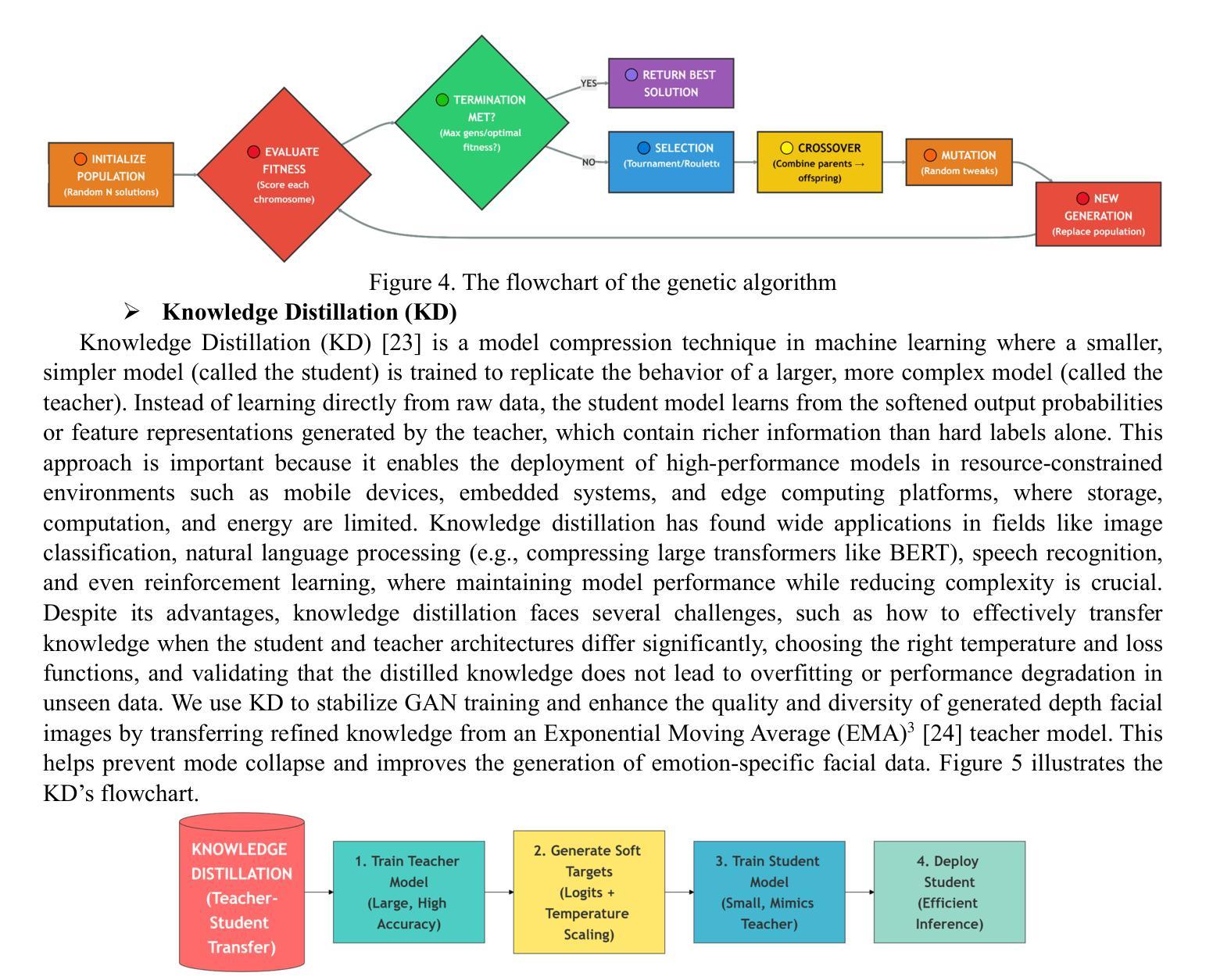

Synthetic Data Generation for Emotional Depth Faces: Optimizing Conditional DCGANs via Genetic Algorithms in the Latent Space and Stabilizing Training with Knowledge Distillation

Authors:Seyed Muhammad Hossein Mousavi, S. Younes Mirinezhad

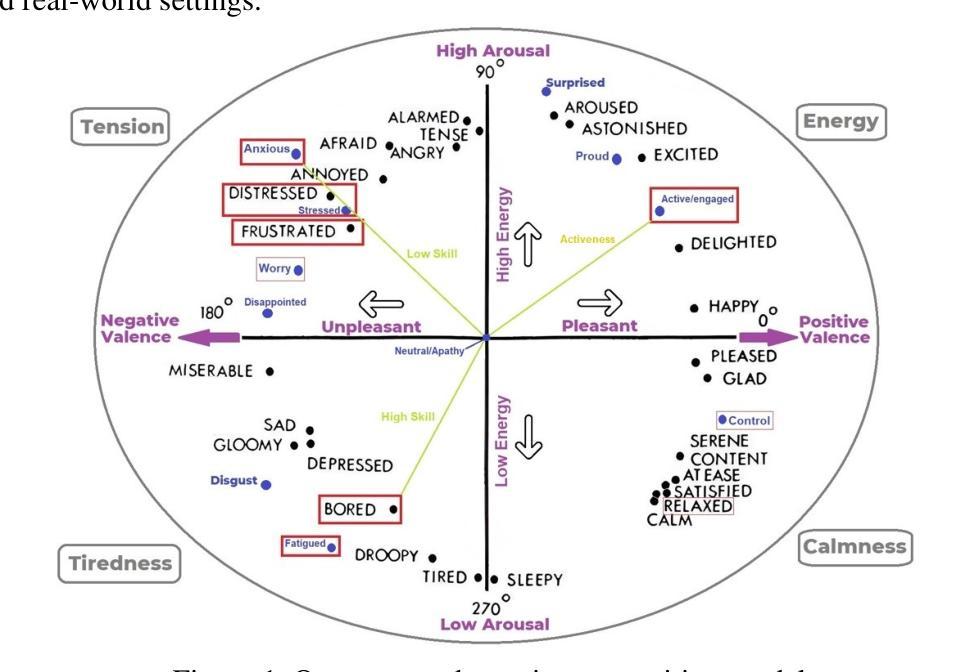

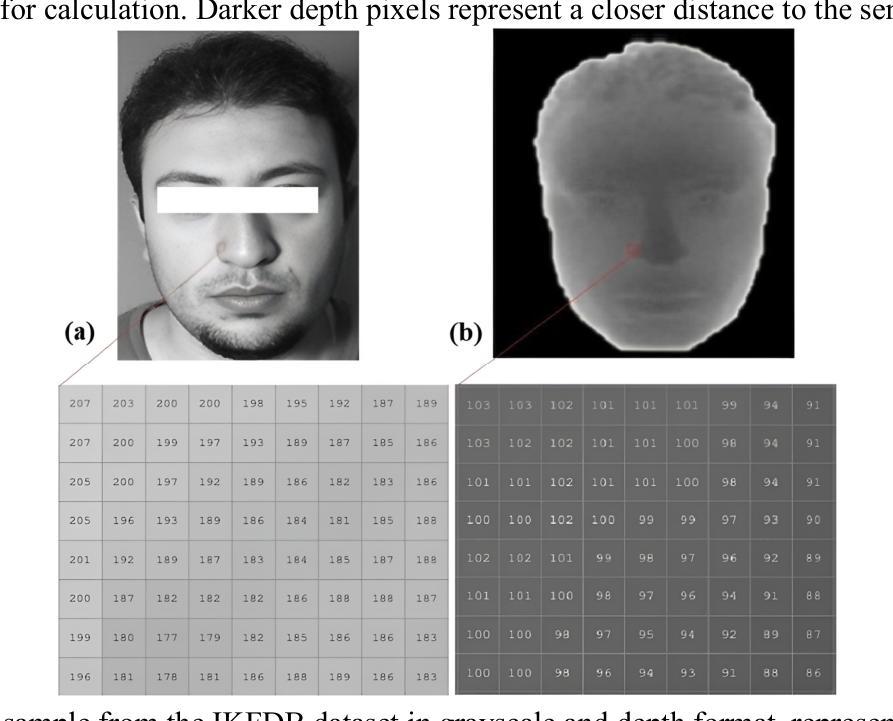

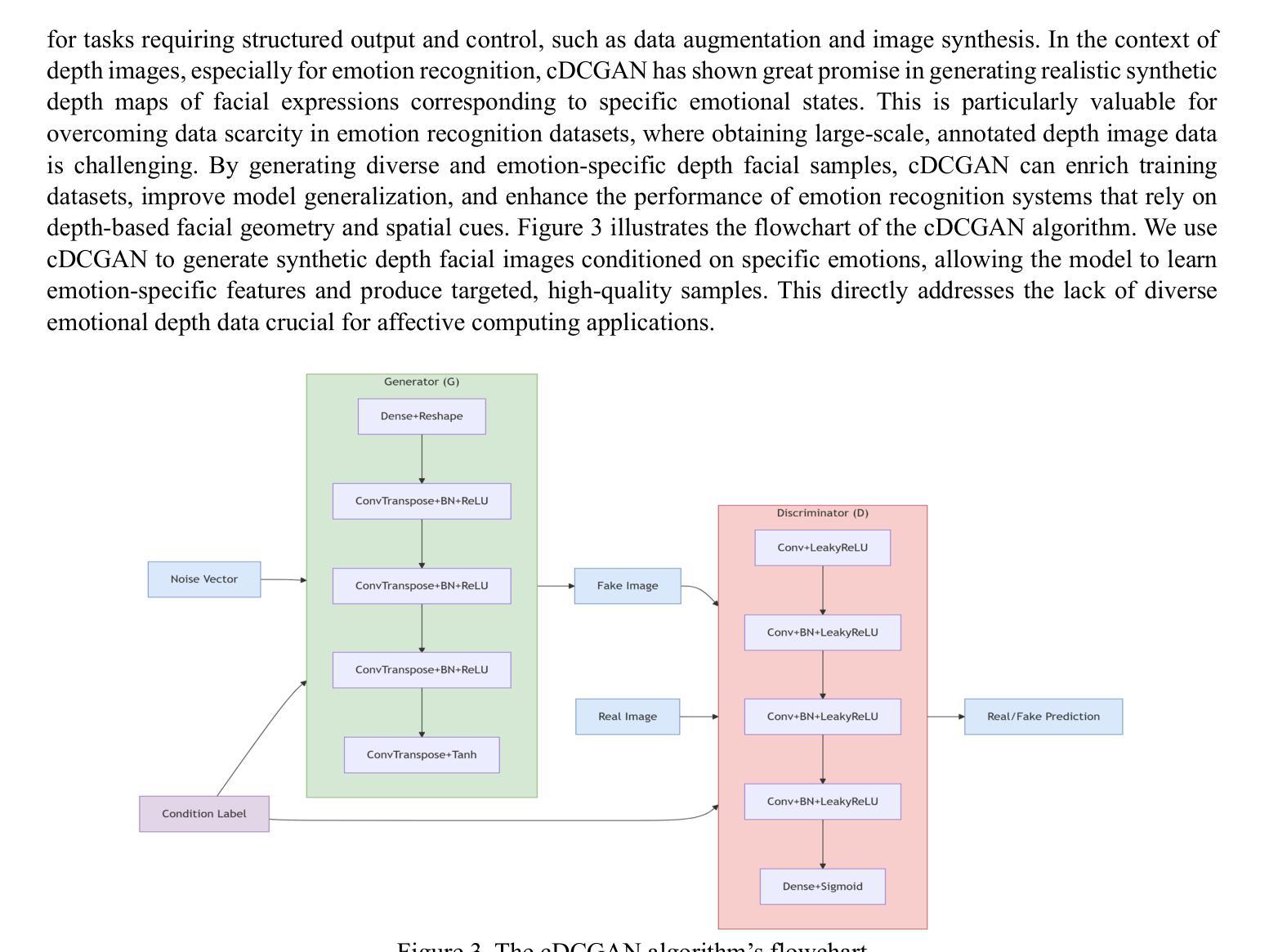

Affective computing faces a major challenge: the lack of high-quality, diverse depth facial datasets for recognizing subtle emotional expressions. We propose a framework for synthetic depth face generation using an optimized GAN with Knowledge Distillation (EMA teacher models) to stabilize training, improve quality, and prevent mode collapse. We also apply Genetic Algorithms to evolve GAN latent vectors based on image statistics, boosting diversity and visual quality for target emotions. The approach outperforms GAN, VAE, GMM, and KDE in both diversity and quality. For classification, we extract and concatenate LBP, HOG, Sobel edge, and intensity histogram features, achieving 94% and 96% accuracy with XGBoost. Evaluation using FID, IS, SSIM, and PSNR shows consistent improvement over state-of-the-art methods.

情感计算面临一个主要挑战:缺乏高质量、深度各异的面部数据集来识别微妙的情感表达。我们提出一种使用优化后的带有知识蒸馏(EMA教师模型)的GAN的合成深度面部生成框架,以稳定训练、提高质量并防止模式崩溃。我们还应用遗传算法根据图像统计信息演化GAN潜在向量,提高目标情感的多样性和视觉质量。该方法在多样性和质量方面都优于GAN、VAE、GMM和KDE。对于分类任务,我们提取并连接LBP、HOG、Sobel边缘和强度直方图特征,使用XGBoost达到94%和96%的准确率。使用FID、IS、SSIM和PSNR的评估表明,与最新方法相比,我们的方法具有一致的改进。

论文及项目相关链接

Summary

本文提出一种利用优化后的带有知识蒸馏(EMA教师模型)的GAN框架,用于生成合成深度面部数据集,以解决情感计算领域缺乏高质量、多样化深度面部数据集的问题。该方法通过遗传算法优化GAN的潜在向量,提高了目标情绪的数据多样性和视觉质量。在分类任务上,通过提取并连接LBP、HOG、Sobel边缘和强度直方图特征,利用XGBoost算法实现高达94%和96%的准确率。评估结果显示,该方法在多样性和质量上均优于其他最新方法。

Key Takeaways

- 缺乏高质量、多样化的深度面部数据集是情感计算领域的主要挑战。

- 提出一种基于优化GAN和知识蒸馏的框架,用于生成合成深度面部数据。

- 使用遗传算法优化GAN的潜在向量,提高目标情绪的数据多样性和视觉质量。

- 在分类任务上,结合LBP、HOG、Sobel边缘和强度直方图特征,利用XGBoost算法实现高准确率。

- 该方法在各种评估指标上均表现出对最新方法的优越性。

- 使用FID、IS、SSIM和PSNR等评估指标对生成的数据进行了全面评价。

点此查看论文截图

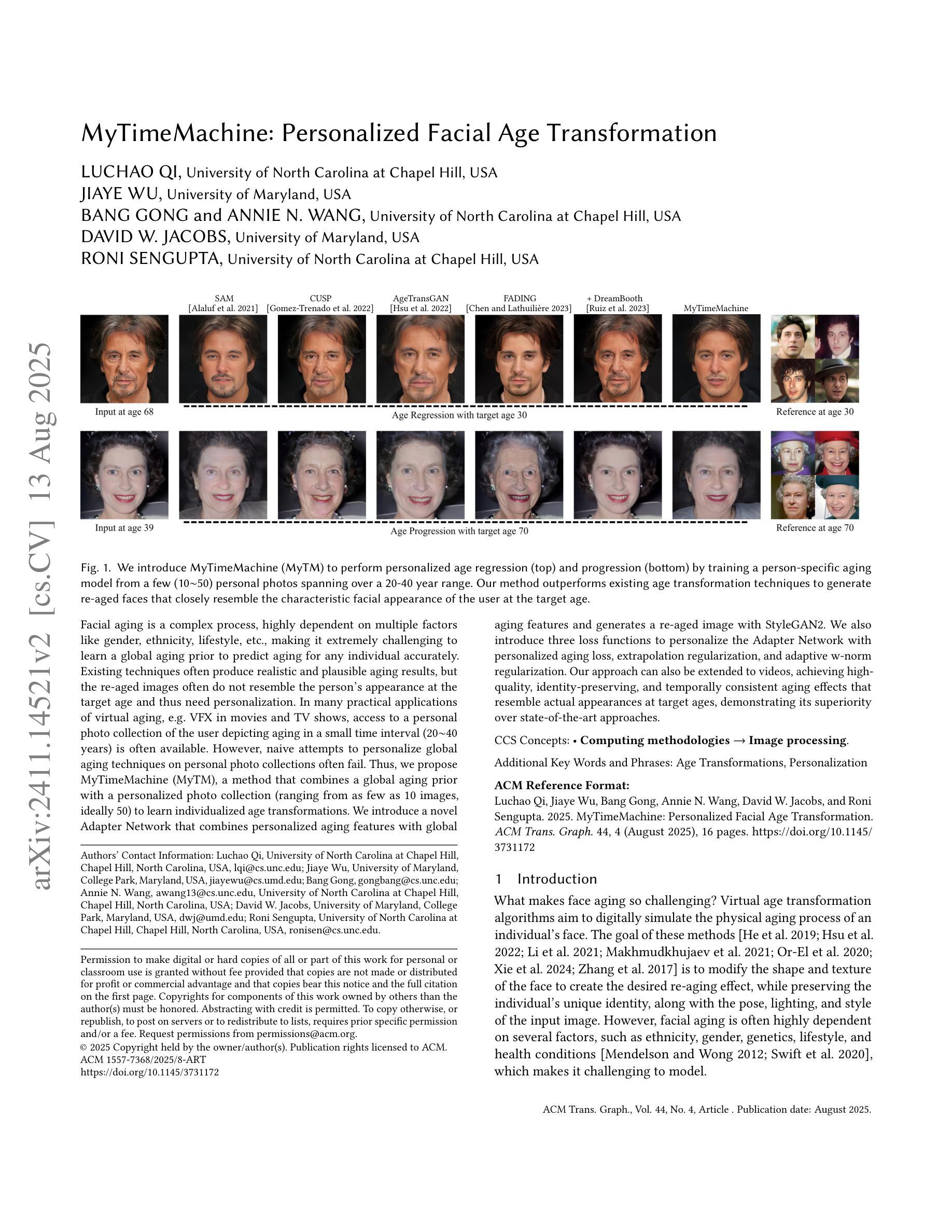

MyTimeMachine: Personalized Facial Age Transformation

Authors:Luchao Qi, Jiaye Wu, Bang Gong, Annie N. Wang, David W. Jacobs, Roni Sengupta

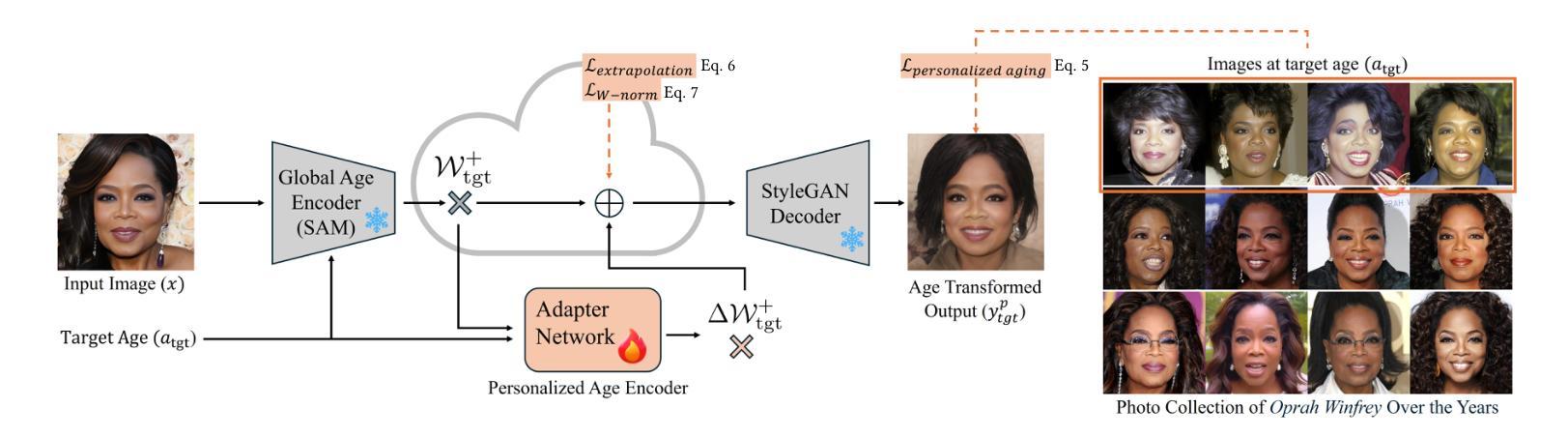

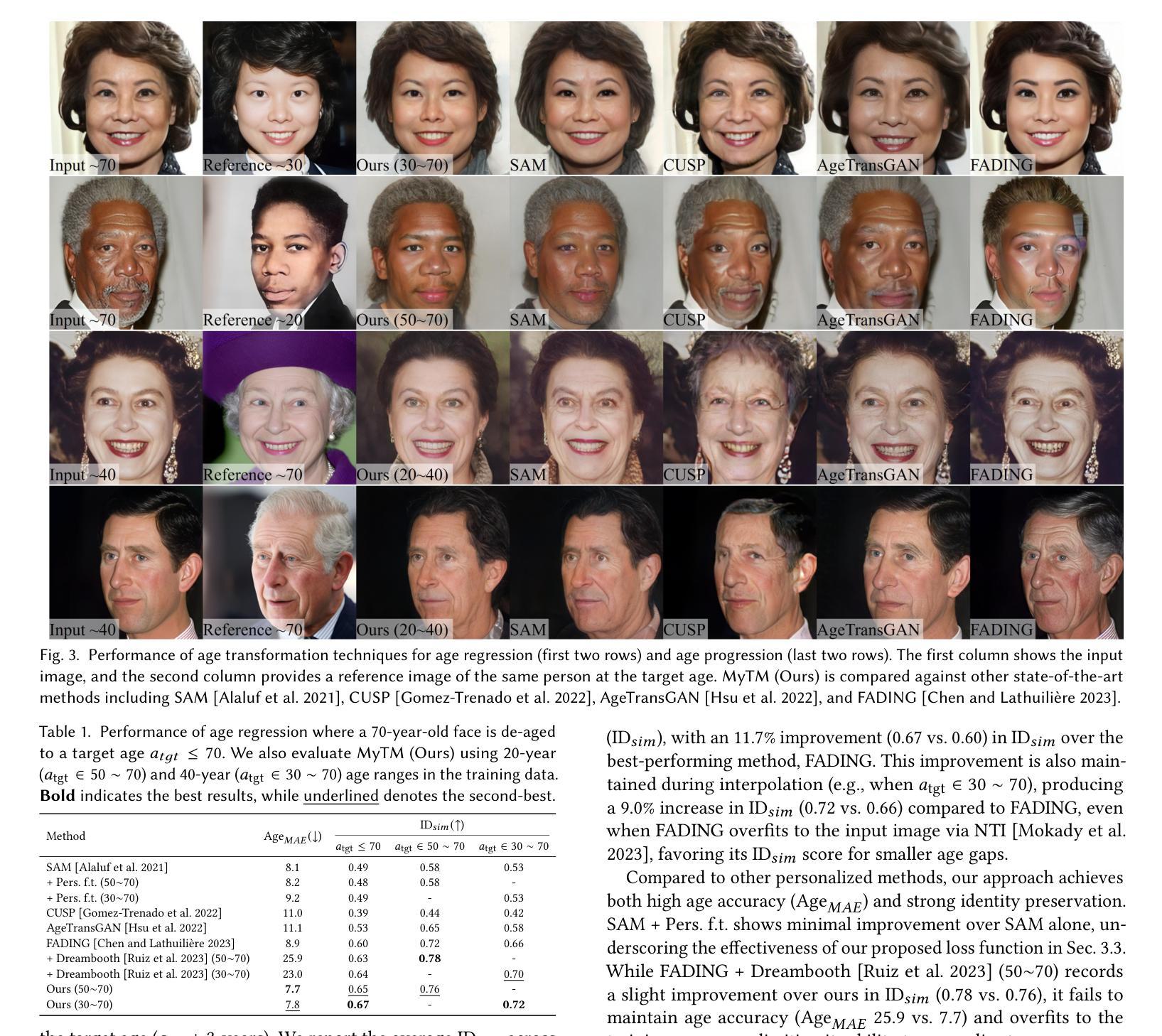

Facial aging is a complex process, highly dependent on multiple factors like gender, ethnicity, lifestyle, etc., making it extremely challenging to learn a global aging prior to predict aging for any individual accurately. Existing techniques often produce realistic and plausible aging results, but the re-aged images often do not resemble the person’s appearance at the target age and thus need personalization. In many practical applications of virtual aging, e.g. VFX in movies and TV shows, access to a personal photo collection of the user depicting aging in a small time interval (20$\sim$40 years) is often available. However, naive attempts to personalize global aging techniques on personal photo collections often fail. Thus, we propose MyTimeMachine (MyTM), which combines a global aging prior with a personal photo collection (using as few as 50 images) to learn a personalized age transformation. We introduce a novel Adapter Network that combines personalized aging features with global aging features and generates a re-aged image with StyleGAN2. We also introduce three loss functions to personalize the Adapter Network with personalized aging loss, extrapolation regularization, and adaptive w-norm regularization. Our approach can also be extended to videos, achieving high-quality, identity-preserving, and temporally consistent aging effects that resemble actual appearances at target ages, demonstrating its superiority over state-of-the-art approaches.

面部老化是一个复杂的过程,它高度依赖于性别、种族、生活方式等多种因素,因此,要想准确预测任何个体的老化情况并学习全局老化先验知识极具挑战性。现有技术虽然能产生逼真且可信的老化结果,但重新老化的图像往往与目标年龄的人的外貌不相符,因此需要进行个性化设置。在虚拟老化的许多实际应用中,例如在电影和电视剧的VFX特效中,通常会获得用户个人照片集,这些照片展示了短时间内(20至4年的时间间隔)的老化过程。然而,简单地尝试在个人照片集上个性化全局老化技术往往会失败。因此,我们提出了MyTimeMachine(MyTM),它将全局老化先验知识与个人照片集(仅使用50张图像)相结合,以学习个性化的年龄转换。我们引入了一种新型适配器网络,它将个性化老化特征与全局老化特征相结合,并使用StyleGAN2生成重新老化的图像。我们还引入了三种损失函数来个性化适配器网络,包括个性化老化损失、外推正则化和自适应w范数正则化。我们的方法还可以扩展到视频,实现高质量、身份保留、时间上一致的老化效果,这些效果与目标年龄的实际外观相匹配,证明了其在最新技术上的优越性。

论文及项目相关链接

PDF SIGGRAPH 2025(TOG): https://dl.acm.org/doi/10.1145/3731172, Project webpage: https://mytimemachine.github.io/

Summary

本文介绍了面部衰老的复杂性,并指出多种因素如性别、种族、生活方式等会影响面部衰老的过程。现有的面部衰老预测技术虽然能够产生真实可信的结果,但需要重新老化图像以贴近目标年龄的外观,这需要个性化。作者提出了一种结合全局衰老先验和个人照片集(仅使用50张图像)的MyTimeMachine(MyTM)方法,通过引入一个新的适配器网络,结合个性化衰老特征和全局衰老特征,并利用StyleGAN2生成重新老化的图像。此外,还引入了三种损失函数来个性化适配器网络。该方法可扩展到视频,实现高质量、身份保留、时间一致的衰老效果,与现有方法相比具有优越性。

Key Takeaways

- 面部衰老是一个复杂的过程,受到多种因素的影响,因此准确预测个体衰老具有挑战性。

- 现有技术虽然能产生真实可信的衰老结果,但需要重新老化图像以贴近目标年龄的外观,需要个性化。

- MyTimeMachine(MyTM)方法结合了全局衰老先验和个人照片集,使用仅50张个人照片即可学习个性化的年龄转换。

- 引入了一个新的适配器网络,结合了个性化衰老特征和全局衰老特征,生成重新老化的图像。

- 引入了三种损失函数来个性化适配器网络,包括个性化衰老损失、外推正则化和自适应w-norm正则化。

- 该方法可扩展到视频,实现高质量、身份保留、时间一致的衰老效果。

点此查看论文截图