⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-08-22 更新

Long-Context Speech Synthesis with Context-Aware Memory

Authors:Zhipeng Li, Xiaofen Xing, Jingyuan Xing, Hangrui Hu, Heng Lu, Xiangmin Xu

In long-text speech synthesis, current approaches typically convert text to speech at the sentence-level and concatenate the results to form pseudo-paragraph-level speech. These methods overlook the contextual coherence of paragraphs, leading to reduced naturalness and inconsistencies in style and timbre across the long-form speech. To address these issues, we propose a Context-Aware Memory (CAM)-based long-context Text-to-Speech (TTS) model. The CAM block integrates and retrieves both long-term memory and local context details, enabling dynamic memory updates and transfers within long paragraphs to guide sentence-level speech synthesis. Furthermore, the prefix mask enhances the in-context learning ability by enabling bidirectional attention on prefix tokens while maintaining unidirectional generation. Experimental results demonstrate that the proposed method outperforms baseline and state-of-the-art long-context methods in terms of prosody expressiveness, coherence and context inference cost across paragraph-level speech.

在长篇文本语音合成中,当前的方法通常是在句子层面将文本转换为语音,并将结果连接起来形成伪段落级别的语音。这些方法忽略了段落的上下文连贯性,导致长篇语音的自然度降低,风格和音色不一致。为了解决这些问题,我们提出了一种基于上下文感知内存(CAM)的长上下文文本到语音(TTS)模型。CAM块集成并检索长期记忆和局部上下文细节,实现长段落内的动态内存更新和转移,以指导句子级别的语音合成。此外,前缀掩码通过允许前缀标记的双向注意力而维持单向生成,增强了上下文学习能力。实验结果表明,所提出的方法在段落级别的语音中,相对于基准方法和最先进的长上下文方法,在语调表达、连贯性和上下文推理成本方面都有更好的表现。

论文及项目相关链接

PDF Accepted by Interspeech25

Summary

文本提出了基于上下文感知内存(CAM)的长时间文本语音转换模型,解决现有技术忽视段落上下文连贯性的问题。模型整合长期记忆与局部上下文细节,能在长段落内进行动态内存更新和转移,进而指导句子级别的语音合成。前缀掩码增强了模型的上下文学习能力,通过双向关注前缀标记同时保持单向生成。实验证明,该方法在段落级别的语音合成中,相较于基准和前沿技术,在语调表达、连贯性和上下文推断成本方面表现更优。

Key Takeaways

- 当前文本语音合成方法主要关注句子级别转换,忽视段落上下文连贯性。

- 提出的CAM模型整合长期记忆和局部上下文细节。

- CAM模型能在长段落内进行动态内存更新和转移。

- 前缀掩码增强模型的上下文学习能力,实现双向关注前缀标记。

- 实验证明,CAM模型在段落级别的语音合成的语调表达、连贯性方面表现优异。

- CAM模型相较于其他方法,在上下文推断成本方面有更优表现。

点此查看论文截图

Your Reward Function for RL is Your Best PRM for Search: Unifying RL and Search-Based TTS

Authors:Can Jin, Yang Zhou, Qixin Zhang, Hongwu Peng, Di Zhang, Marco Pavone, Ligong Han, Zhang-Wei Hong, Tong Che, Dimitris N. Metaxas

Test-time scaling (TTS) for large language models (LLMs) has thus far fallen into two largely separate paradigms: (1) reinforcement learning (RL) methods that optimize sparse outcome-based rewards, yet suffer from instability and low sample efficiency; and (2) search-based techniques guided by independently trained, static process reward models (PRMs), which require expensive human- or LLM-generated labels and often degrade under distribution shifts. In this paper, we introduce AIRL-S, the first natural unification of RL-based and search-based TTS. Central to AIRL-S is the insight that the reward function learned during RL training inherently represents the ideal PRM for guiding downstream search. Specifically, we leverage adversarial inverse reinforcement learning (AIRL) combined with group relative policy optimization (GRPO) to learn a dense, dynamic PRM directly from correct reasoning traces, entirely eliminating the need for labeled intermediate process data. At inference, the resulting PRM simultaneously serves as the critic for RL rollouts and as a heuristic to effectively guide search procedures, facilitating robust reasoning chain extension, mitigating reward hacking, and enhancing cross-task generalization. Experimental results across eight benchmarks, including mathematics, scientific reasoning, and code generation, demonstrate that our unified approach improves performance by 9 % on average over the base model, matching GPT-4o. Furthermore, when integrated into multiple search algorithms, our PRM consistently outperforms all baseline PRMs trained with labeled data. These results underscore that, indeed, your reward function for RL is your best PRM for search, providing a robust and cost-effective solution to complex reasoning tasks in LLMs.

测试时间缩放(TTS)对于大型语言模型(LLM)迄今为止主要分为两种截然不同的范式:

(1)强化学习(RL)方法能够优化基于结果的稀疏奖励,但存在不稳定性和低样本效率的问题;

(2)基于独立训练的静态过程奖励模型(PRM)引导下的搜索技术,这需要昂贵的人工或LLM生成的标签,并且在分布变化时往往会退化。

在本文中,我们介绍了AIRL-S,这是基于RL和基于搜索的TTS的自然统一。AIRL-S的核心见解是,在RL训练期间学到的奖励函数本质上代表了引导下游搜索的理想PRM。具体来说,我们利用对抗性逆向强化学习(AIRL)结合群体相对策略优化(GRPO),直接从正确的推理轨迹中学习密集、动态的PRM,完全消除了对标记的中间过程数据的需求。在推理过程中,所得的PRM同时作为RL演练的评论家,并作为有效引导搜索过程的启发式方法,促进稳健的推理链扩展,缓解奖励破解,并增强跨任务泛化。

在包括数学、科学推理和代码生成等在内的八个基准测试上的实验结果表明,我们的统一方法平均比基础模型提高了9%的性能,与GPT-4o相匹配。此外,当集成到多种搜索算法中时,我们的PRM始终优于使用标记数据训练的基线PRM。这些结果强调,你的RL奖励函数就是你的最佳PRM搜索工具,为LLM中的复杂推理任务提供了稳健且经济的解决方案。

论文及项目相关链接

Summary

该文介绍了测试时间缩放(TTS)在大型语言模型(LLM)中的两种主要方法及其局限性。针对这些问题,提出了一种新的方法AIRL-S,将RL和搜索方法相结合,通过利用对抗性逆向强化学习(AIRL)和群体相对策略优化(GRPO)来构建动态过程奖励模型(PRM),无需标注的中间过程数据。实验结果表明,该方法在多个基准测试中平均提高了9%的性能,与GPT-4相当。此外,将其集成到多种搜索算法中,始终优于使用标记数据训练的基准PRM。总的来说,该文的奖励函数对于强化学习来说是最佳的过程奖励模型搜索函数,为大型语言模型中的复杂推理任务提供了稳健且经济的解决方案。

Key Takeaways

- TTS在大型语言模型(LLM)中分为强化学习(RL)和搜索两种主要方法,各有其局限性。

- AIRL-S是首个将RL和搜索方法自然结合的方法。

- AIRL-S利用对抗性逆向强化学习(AIRL)和群体相对策略优化(GRPO)构建动态过程奖励模型(PRM)。

- 该方法无需标注的中间过程数据,通过正确的推理轨迹来学习密集、动态的过程奖励模型。

- 在多个基准测试中,AIRL-S提高了性能,平均提升9%,与GPT-4相当。

- 将AIRL-S集成到多种搜索算法中,始终优于使用标记数据训练的基准PRM。

点此查看论文截图

MahaTTS: A Unified Framework for Multilingual Text-to-Speech Synthesis

Authors:Jaskaran Singh, Amartya Roy Chowdhury, Raghav Prabhakar, Varshul C. W

Current Text-to-Speech models pose a multilingual challenge, where most of the models traditionally focus on English and European languages, thereby hurting the potential to provide access to information to many more people. To address this gap, we introduce MahaTTS-v2 a Multilingual Multi-speaker Text-To-Speech (TTS) system that has excellent multilingual expressive capabilities in Indic languages. The model has been trained on around 20K hours of data specifically focused on Indian languages. Our approach leverages Wav2Vec2.0 tokens for semantic extraction, and a Language Model (LM) for text-to-semantic modeling. Additionally, we have used a Conditional Flow Model (CFM) for semantics to melspectogram generation. The experimental results indicate the effectiveness of the proposed approach over other frameworks. Our code is available at https://github.com/dubverse-ai/MahaTTSv2

当前文本转语音模型面临多语言挑战,因为大多数传统模型主要关注英语和欧洲语言,从而限制了为更多人提供信息访问的可能性。为了解决这一差距,我们推出了MahaTTS-v2多语种多发言人文本转语音(TTS)系统,该系统在印地语等语言中具有出色的多语言表达能力。该模型在专门聚焦于印度语言的约20K小时数据上进行了训练。我们的方法利用Wav2Vec2.0令牌进行语义提取,并利用语言模型进行文本到语义建模。此外,我们还使用了条件流模型(CFM)进行语义到频谱图的生成。实验结果表明,与其他框架相比,所提出的方法是有效的。我们的代码位于https://github.com/dubverse-ai/MahaTTSv2

简化的翻译

论文及项目相关链接

摘要

当前文本转语音模型在多语种方面存在挑战,传统模型主要关注英语和欧洲语言,限制了为更多人提供信息访问的机会。为解决这一问题,我们推出了MahaTTS-v2,这是一款具有印地语等多语言表达能力的文本转语音(TTS)系统。该模型在专注于印度语言的数据上进行了约2万小时的培训。我们的方法利用Wav2Vec2.0进行语义提取,并利用语言模型进行文本到语义的建模。此外,我们还使用了条件流模型进行语义到音频频谱生成。实验结果表明,该方法较其他框架更为有效。我们的代码可通过链接访问:https://github.com/dubverse-ai/MahaTTSv2。

关键见解

- 当前文本转语音(TTS)模型在多语种方面存在挑战,尤其针对非英语和欧洲语言的模型较少。

- 为了解决这一挑战,推出了MahaTTS-v2,一个具有多语言表达能力的TTS系统。

- 该模型专注于印度语言,进行了约2万小时的培训。

- 利用Wav2Vec2.0进行语义提取,确保模型能更准确地理解和生成不同语言的语音内容。

- 采用语言模型(LM)进行文本到语义的建模,增强了模型的文本理解能力。

- 使用条件流模型(CFM)将语义转化为音频频谱,提高了语音生成的音质和流畅度。

点此查看论文截图

DiffIER: Optimizing Diffusion Models with Iterative Error Reduction

Authors:Ao Chen, Lihe Ding, Tianfan Xue

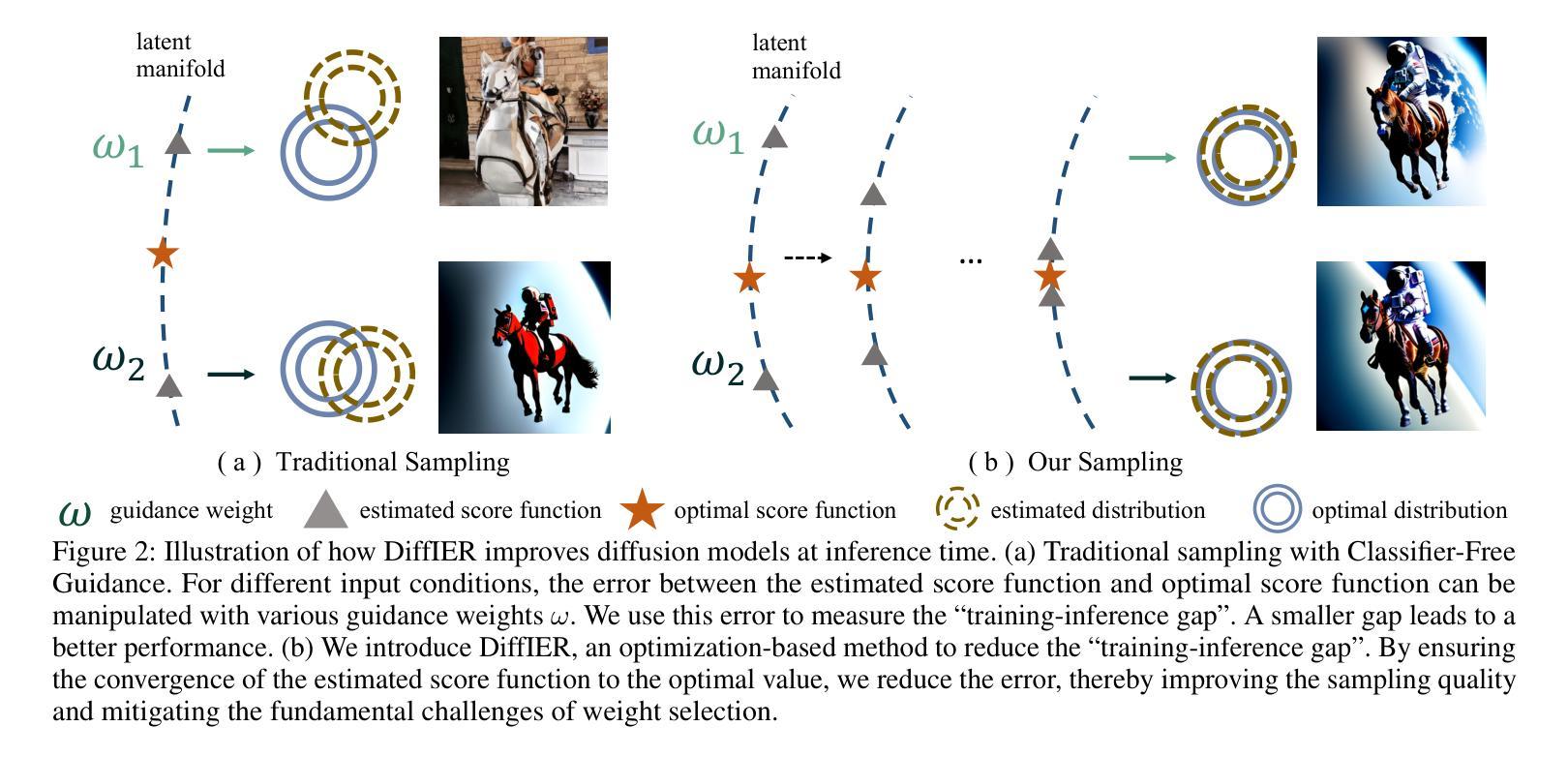

Diffusion models have demonstrated remarkable capabilities in generating high-quality samples and enhancing performance across diverse domains through Classifier-Free Guidance (CFG). However, the quality of generated samples is highly sensitive to the selection of the guidance weight. In this work, we identify a critical ``training-inference gap’’ and we argue that it is the presence of this gap that undermines the performance of conditional generation and renders outputs highly sensitive to the guidance weight. We quantify this gap by measuring the accumulated error during the inference stage and establish a correlation between the selection of guidance weight and minimizing this gap. Furthermore, to mitigate this gap, we propose DiffIER, an optimization-based method for high-quality generation. We demonstrate that the accumulated error can be effectively reduced by an iterative error minimization at each step during inference. By introducing this novel plug-and-play optimization framework, we enable the optimization of errors at every single inference step and enhance generation quality. Empirical results demonstrate that our proposed method outperforms baseline approaches in conditional generation tasks. Furthermore, the method achieves consistent success in text-to-image generation, image super-resolution, and text-to-speech generation, underscoring its versatility and potential for broad applications in future research.

扩散模型已经显示出在生成高质量样本和提高跨不同领域的性能方面的显著能力,这主要是通过无分类器引导(CFG)实现的。然而,生成样本的质量对引导权重的选择非常敏感。在这项工作中,我们识别出了一个关键的“训练推理差距”,我们认为正是这个差距的存在削弱了条件生成的表现,使输出对引导权重高度敏感。我们通过测量推理阶段的累积误差来量化这一差距,并建立引导权重的选择与最小化这一差距之间的相关性。此外,为了缓解这一差距,我们提出了DiffIER,这是一种基于优化的高质量生成方法。我们证明,通过推理过程中每一步的迭代误差最小化,可以有效地减少累积误差。通过引入这种新型的即插即用优化框架,我们能够在每一个单独的推理步骤中优化误差,提高生成质量。经验结果表明,我们提出的方法在条件生成任务上优于基准方法。此外,该方法在文本到图像生成、图像超分辨率和文本到语音生成方面取得了持续的成功,这突显了其在未来研究中的通用性和潜力。

论文及项目相关链接

Summary

本文介绍了扩散模型通过无分类器引导(CFG)在生成高质量样本和提高不同领域性能方面的显著能力。然而,生成样本的质量对引导权重的选择非常敏感。本文识别了一个关键的“训练-推理差距”,并认为这个差距影响了条件生成性能并使输出对引导权重高度敏感。为了量化这个差距并减少其对生成质量的影响,作者提出了一种基于优化的方法DiffIER,通过迭代误差最小化在推理过程中的每一步来优化误差。实验结果表明,该方法在条件生成任务上优于基线方法,并在文本到图像生成、图像超分辨率和文本到语音生成中实现了成功应用。

Key Takeaways

- 扩散模型通过无分类器引导(CFG)展现了生成高质量样本和提高不同领域性能的显著能力。

- 生成的样本质量对引导权重的选择非常敏感。

- 存在一个关键的“训练-推理差距”,这影响了条件生成性能。

- 作者通过测量推理阶段的累积误差来量化这个差距,并发现其与选择引导权重有关。

- 为了减少这个差距,作者提出了DiffIER方法,这是一种基于优化的高质量生成方法。

- DiffIER通过迭代误差最小化在推理过程中的每一步来优化误差,有效减少了累积误差。

- 实证结果表明,DiffIER在条件生成任务上优于基线方法,并在多个领域具有广泛的应用潜力。

点此查看论文截图

FNH-TTS: A Fast, Natural, and Human-Like Speech Synthesis System with advanced prosodic modeling based on Mixture of Experts

Authors:Qingliang Meng, Yuqing Deng, Wei Liang, Limei Yu, Huizhi Liang, Tian Li

Achieving natural and human-like speech synthesis with low inference costs remains a major challenge in speech synthesis research. This study focuses on human prosodic patterns and synthesized spectrum harmony, addressing the challenges of prosody modeling and artifact issues in non-autoregressive models. To enhance prosody modeling and synthesis quality, we introduce a new Duration Predictor based on the Mixture of Experts alongside a new Vocoder with two advanced multi-scale discriminators. We integrated the these new modules into the VITS system, forming our FNH-TTS system. Our experiments on LJSpeech, VCTK, and LibriTTS demonstrate the system’s superiority in synthesis quality, phoneme duration prediction, Vocoder results, and synthesis speed. Our prosody visualization results show that FNH-TTS produces duration predictions that more closely align with natural human beings than other systems.

实现具有低成本推理的自然和拟人语音合成仍然是语音合成研究的主要挑战。本研究关注人类韵律模式和合成频谱和谐,解决非自回归模型中的韵律建模和伪影问题。为了增强韵律建模和合成质量,我们引入了一种基于专家混合的新持续时间预测器,以及具有两个先进多尺度鉴别器的新Vocoder。我们将这些新模块集成到VITS系统中,形成了我们的FNH-TTS系统。我们在LJSpeech、VCTK和LibriTTS上的实验证明了系统在合成质量、音素持续时间预测、Vocoder结果和合成速度方面的优越性。我们的韵律可视化结果表明,FNH-TTS产生的持续时间预测与其他系统相比,更接近于自然人类。

论文及项目相关链接

Summary

新一代TTS技术对于合成自然和人一样的语音仍有待挑战。本研究关注人类韵律模式和合成频谱和谐性,解决非自回归模型中的韵律建模和人工制品问题。通过引入基于混合专家的新持续时间预测器以及具有两个先进多尺度鉴别器的全新Vocoder,提高了韵律建模和合成质量。集成这些新模块到VITS系统中,形成我们的FNH-TTS系统。实验表明,该系统在合成质量、音素持续时间预测、Vocoder结果和合成速度上优于其他系统,生成的韵律可视化结果更贴近自然人的表现。

Key Takeaways

- 研究旨在解决TTS技术中合成自然和人一样的语音的挑战。

- 关注人类韵律模式和合成频谱和谐性,以解决非自回归模型的韵律建模和人工制品问题。

- 引入基于混合专家的新持续时间预测器以提高韵律建模和合成质量。

- 使用全新的Vocoder,并结合两个先进的多尺度鉴别器以增强合成效果。

- 集成新模块到VITS系统,形成FNH-TTS系统。

- 实验证明FNH-TTS在合成质量、音素持续时间预测等方面表现优越。

点此查看论文截图

FMSD-TTS: Few-shot Multi-Speaker Multi-Dialect Text-to-Speech Synthesis for Ü-Tsang, Amdo and Kham Speech Dataset Generation

Authors:Yutong Liu, Ziyue Zhang, Ban Ma-bao, Yuqing Cai, Yongbin Yu, Renzeng Duojie, Xiangxiang Wang, Fan Gao, Cheng Huang, Nyima Tashi

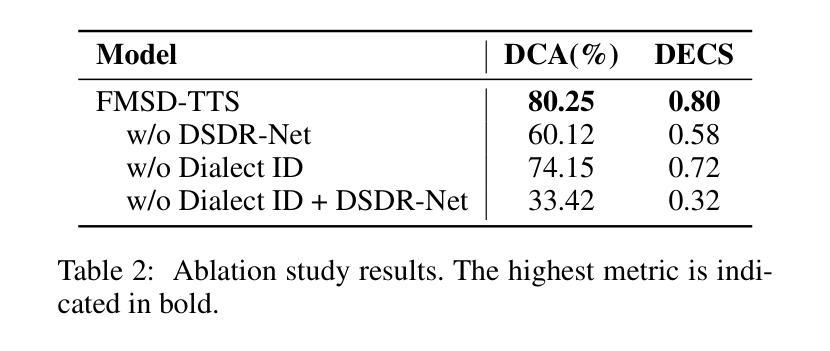

Tibetan is a low-resource language with minimal parallel speech corpora spanning its three major dialects-"U-Tsang, Amdo, and Kham-limiting progress in speech modeling. To address this issue, we propose FMSD-TTS, a few-shot, multi-speaker, multi-dialect text-to-speech framework that synthesizes parallel dialectal speech from limited reference audio and explicit dialect labels. Our method features a novel speaker-dialect fusion module and a Dialect-Specialized Dynamic Routing Network (DSDR-Net) to capture fine-grained acoustic and linguistic variations across dialects while preserving speaker identity. Extensive objective and subjective evaluations demonstrate that FMSD-TTS significantly outperforms baselines in both dialectal expressiveness and speaker similarity. We further validate the quality and utility of the synthesized speech through a challenging speech-to-speech dialect conversion task. Our contributions include: (1) a novel few-shot TTS system tailored for Tibetan multi-dialect speech synthesis, (2) the public release of a large-scale synthetic Tibetan speech corpus generated by FMSD-TTS, and (3) an open-source evaluation toolkit for standardized assessment of speaker similarity, dialect consistency, and audio quality.

藏语是一种资源匮乏的语言,其三大方言区——乌兹藏、安多和康区的平行语音语料库极少,限制了语音建模的进展。为了解决这一问题,我们提出了FMSD-TTS,这是一个小样本、多发言人、多方言的文本-语音合成框架,它可以从有限的参考音频和明确的方言标签中合成平行的方言语音。我们的方法具有新颖的发声人-方言融合模块和方言专用动态路由网络(DSDR-Net),能够捕捉方言之间的精细声学和语言变异,同时保留发声人的身份。大量的客观和主观评估表明,FMSD-TTS在方言表达力和发声人相似性方面显著优于基准线。我们进一步通过具有挑战性的语音到语音的方言转换任务来验证合成语音的质量和实用性。我们的贡献包括:(1)针对藏语多方言语音合成的少样本TTS系统,(2)公开发布由FMSD-TTS生成的大规模合成藏语语音语料库,(3)开放源评估工具包,用于标准化评估发声人相似性、方言一致性和音频质量。

论文及项目相关链接

PDF 18 pages

摘要

针对藏语资源匮乏的问题,提出了一种基于少量样本的多说话者、多方言文本转语音(TTS)框架FMSD-TTS。该框架能从有限的参考音频和明确的方言标签中合成出平行的方言语音。它采用了一种新颖的说话者-方言融合模块和方言专用动态路由网络(DSDR-Net),以捕捉不同方言之间精细的声学和语言变化,同时保留说话者的身份。客观和主观评估表明,FMSD-TTS在方言表现力和说话者相似性方面显著优于基准模型。此外,通过具有挑战性的语音到语音的方言转换任务验证了合成语音的质量和实用性。本文的贡献包括:(1)针对藏语多方言语音合成的少样本TTS系统,(2)公开发布由FMSD-TTS生成的大规模藏语语音语料库,(3)开放评估工具包,用于标准化评估说话者相似性、方言一致性和音频质量。

关键见解

- 藏语是一种资源匮乏的语言,其三大方言(U-Tsang、Amdo、Kham)的平行语音语料库有限,限制了语音建模的进展。

- 提出了一种基于少量样本的多说话者、多方言的文本转语音(TTS)框架FMSD-TTS,能够合成平行方言语音。

- FMSD-TTS框架包含新颖的说话者-方言融合模块和方言专用动态路由网络(DSDR-Net),以捕捉方言间的细微差异并保留说话者身份。

- 客观和主观评估表明,FMSD-TTS在方言表达力和说话者相似性方面优于其他模型。

- FMSD-TTS成功通过了语音到语音的方言转换任务的验证,证明了其合成语音的质量和实用性。

- 本研究公开发布了由FMSD-TTS生成的大规模藏语语音语料库,为未来的研究提供了资源。

点此查看论文截图